🤖 L'IA che sapeva troppo- Legge Zero #70

Il nostro modo per augurarvi Buona Pasqua è raccontarvi come le IA accumulano sempre più dati degli utenti, spiegandovi cosa può comportare questa raccolta massiva di dati (e come limitarla).

🧠 Ti sei mai chiesto cosa l’IA sa di te?

Quando succede qualcosa, lo saprai. Niente di più semplice!

È questa la promessa di The Ring, un concept di ‘anello smart’ sviluppato da Raw (un’app di dating) insieme alla startup Queens Tech. Non c’entra il monitoraggio della salute o del sonno, però. Si tratta di due anelli pensati per essere venduti insieme, come delle fedi, ma potenziati dall’intelligenza artificiale in modo tale che si possa sempre conoscere lo stato d’animo del proprio partner. Il dispositivo - stando alle informazioni che sono state diffuse - sarà in grado di tenere traccia del battito cardiaco, temperatura corporea, dei micromovimenti e perfino del tono di voce di chi lo indossa (non dovrebbe registrare nulla, se vi fidate di quello che dice chi lo commercializza). Un’IA, attualmente in fase di test, trasformerà quei dati in un colore che illuminerà l’anello del partner per indicare - a seconda dei casi - stress, ansia o eccitazione (si, avete letto bene).

Immaginate di essere in una riunione di lavoro quando, all’improvviso, l’anello inizia a cambiare colore. Da blu (che indica che è tutto normale) diventa verde (che indica ansia o stress) o magenta (colore che indica l’eccitazione). Voi, ma anche i vostri colleghi, potreste venire così a conoscenza di quello che sta provando - e, in alcuni casi, facendo - il vostro fidanzato o coniuge.

Non è il sequel di Perfetti Sconosciuti - il film in cui, durante una cena, alcuni amici leggevano collettivamente ogni notifica dei reciproci cellulari - o la nuova serie di Black Mirror (anche se ci somiglia molto). È tutto vero. L’azienda lo presenta come un modo per '“rendere tracciabile il vero amore” o - con una strategia aggressiva di marketing - per accorgersi di un’eventuale infedeltà. Il lancio commerciale non è imminente: al momento si parla di fine 2025 o inizio 2026 e il prezzo è ancora da definire. Ovviamente, al momento, non ci sono ancora studi che dimostrino l’affidabilità dello strumento e della rilevazione delle emozioni. Solo un dato generico proveniente da non meglio precisati ‘test interni’: il sistema azzeccherebbe nell’87% dei casi. Ma quanti danni - al benessere psicologico o alla durata di una relazione - potrebbe causare il 13% di margine di errore? E poi, quanti dati raccoglierebbe il dispositivo sugli utenti, sulle loro abitudini e sui loro profili psicologici? Questo potrebbe renderli più vulnerabili a tentativi di manipolazione?

Chissà se gli sviluppatori dell’anello - nei loro test - stanno contemplando anche analisi del rischio che consentono di poter adottare tutte le misure di mitigazione necessarie ad assicurare non solo la conformità alla normativa europea in materia di protezione dei dati personali e intelligenza artificiale. Altrimenti, è probabile che - come accade sempre più spesso - il prodotto arrivi da noi molto dopo il suo lancio nel resto del mondo.

È accaduto recentemente con l’Llama, l’IA di Meta, che da qualche settimana è disponibile anche per tutti gli utenti europei di Whatsapp, Instagram, Facebook e Messenger (nel resto del mondo era arrivata diversi mesi fa). Se usate queste applicazioni non avrete potuto fare a meno di notare un cerchio blu-viola, ben visibile, che consente agli utenti di interagire direttamente con l'IA per ottenere risposte, consigli e assistenza su vari argomenti.

Su Google Trends, la query “come disattivare Meta AI su WhatsApp” è schizzata in cima alla sezione tecnologia, con oltre 20.000 ricerche — un chiaro segnale che l’accoglienza è stata tutt’altro che calorosa.

Le motivazioni? Prevedibili, ma non per questo trascurabili: fastidio visivo, timori per la privacy e la sensazione generale di un’invasione non richiesta.

Diciamolo subito:

la funzione non può essere disattivata, al massimo l’utente non cliccherà mai su quel cerchio e non farà mai domande al chatbot;

Meta ci rassicura, le altre chat restano private, sono crittografate end-to-end.

Tuttavia, Meta AI può essere aggiunta alle chat (individuali e di gruppo). In questo caso, l’IA leggerà i messaggi che le vengono indirizzati. Quindi starà agli utenti fare attenzione in quanto:

Insomma, i messaggi degli utenti di Whatsapp, Instagram, Facebook e Messenger potrebbero essere utilizzati per addestrare l’intelligenza artificiale.

È un tema di cui dobbiamo essere sempre più consapevoli: le IA hanno fame di dati per migliorare le loro prestazioni (ne avevamo parlato in LeggeZero #57 dando conto dell’allarme di Elon Musk sul fatto che sono stati esauriti tutti i dati disponibili per l’addestramento e bisogna produrne di nuovi).

È anche per questo che Meta ha deciso di riprendere i propri programmi di addestramento della sua IA anche sugli utenti europei (qui un articolo del Corriere della Sera con una mia riflessione sulla rilevanza giuridica della notizia). Come probabilmente ricorderete, lo scorso anno, le attività di training sui profili social erano state sospese a seguito delle preoccupazioni sollevate da diverse autorità europee per la protezione dei dati (ne parlammo in LeggeZero #28).

Dopo un’interlocuzione con l’Autorità irlandese, però, l’attività di addestramento riprende e l'azienda ha precisato che:

non utilizzerà messaggi privati, nè i contenuti protetti (come quelli dei profili non pubblici) né dati di utenti minorenni;

e che gli utenti avranno la possibilità di opporsi a questo trattamento attraverso un modulo dedicato (qui il modulo per opporsi relativamente a Facebook, qui per Instagram).

Nei prossimi giorni, gli utenti dovrebbero ricevere una notifica in app che li avveserà di questa facoltà, ma attenzione: è consigliabile esercitare l’opt-out prima che l'addestramento dell'IA inizi, poiché una volta che i dati sono stati utilizzati, non è tecnicamente possibile rimuoverli retroattivamente dal modello.

E le altre IA, quelle che utilizziamo quotidianamente per lavoro o per svago, utilizzano i dati che forniamo loro sotto forma di prompt e risposte? E cosa possiamo fare - come utenti - per evitare che accumulino informazioni su di noi?

ChatGPT (OpenAI)

Partiamo dal chatbot IA più usato al mondo, ChatGPT, che - secondo quanto affermato nei termini d’uso e policy di OpenAI - apprende dalle richieste e dai commenti degli utenti tanto nella versione free quanto in quella plus (a pagamento). Attenzione quindi a inserire dati personali (es. cartelle cliniche) o dati di clienti.

OpenAI ha recentemente introdotto un aggiornamento che consente a ChatGPT di ricordare tutte le conversazioni precedenti per offrire risposte più personalizzate (ad es. quando si chiede un consiglio per la prenotazione del ristorante, potrebbe ricordare se abbiamo preferenze o allergie alimentari). Questa funzione non è ancora disponibile in Europa (probabilmente a causa delle norme in materia di protezione dei dati personali).

Se volete evitare che - anche per motivi di riservatezza - le vostre chat vadano ad alimentare il modello potete decidere di avviare chat temporanee.

Oppure potete, attraverso il pannello delle impostazioni, decidere di:

cancellare le chat ed evitare che l’IA conservi traccia delle conversazioni precedenti;

evitare che il modello faccia riferimento alla memoria di chat precedenti quando risponde alle domande;

evitare che le chat (testuali e vocali) addestrino il modello.

Inoltre, OpenAI offre moduli per chiedere di esercitare il diritto di opposizione al trattamento dei dati personali, vale a dire evitare che il modello dia risposte relative all’interessato (in LeggeZero #53 abbiamo visto che Guido Scorza - componente del Garante Privacy - si è avvalso proprio di questo diritto).

Gemini (Google)

Anche le conversazioni con Gemini - il chatbot di Google - possono essere utilizzate per l’addestramento del modello. Se gli utenti vogliono, possono disattivare la registrazione delle attività (che vengono salvate di default).

Così le future chat non saranno usate per training (anche se Google conserverà comunque i dati per 72 ore per “fornire il servizio” e potrà trattenere fino a 3 anni alcune conversazioni in forma anonima).

Non esiste la possibilità di avviare chat effimere come su ChatGPT.

Claude (Anthropic)

Molto diverso da quello di ChatGPT e Gemini è l’approccio di Claude. Il chatbot di Anthropic, infatti, per impostazione predefinita non usa nessun dato dell’utente per l’addestramento del modello, a meno che l’utente stesso non lo richieda (opt-in) e fatti salvi i casi in cui gli input vengano analizzati dal loro team di Trust&Safety per valutare eventuali violazioni delle regole d’uso del servizio oppure per migliorare i filtri di Claude.

Le chat rimangono visibili nella cronologia - ma solo per comodità di recuperare conversazioni - finché l’utente non le cancella; una volta eliminate, i dati vengono rimossi entro 30 giorni.

Perplexity AI (Perplexity)

A differenza di Claude, invece, Perplexity usa per impostazione predefinita le domande e le relative risposte degli utenti per perfezionare l’IA. È però possibile bloccarne l’addestramento disattivando l’opzione ‘AI Data Retention’ o lavorare in modalità Incognito, che non salva nulla. È inoltre in beta la funzione ‘Memory’, che, se lasciata attiva, conserva preferenze tra le sessioni per personalizzare le risposte.

La cronologia rimane finché l’utente non la cancella; eliminando un thread o l’intero account, i dati vengono rimossi entro 30 giorni. Nei piani più costosi i prompt non vengono mai usati per addestrare i modelli.

Grok (xAI)

Il chatbot di Elon Musk segue una logica analoga a quella della gran parte dei chatbot IA. Al momento, per gli utenti europei è possibile provarlo solo all’interno di X (il social una volta conosciuto come Twitter).

Per impostazione predefinita, X.AI usa i prompt, le risposte generate e anche i post pubblici e le interazioni sul social per addestrare e perfezionare i modelli.

È però possibile disattivare questa impostazione così come è possibile cancellare la cronologia delle conversazioni.

DeepSeek (DeepSeek)

Nelle ultime settimane - probabilmente anche a causa del provvedimento di blocco disposto dal Garante Privacy italiano (di cui abbiamo parlato in LeggeZero #59) - anche DeepSeek, l’IA cinese più nota, si è adeguata alla prassi prevalente tra i provider (escluso Anthropic): l’uso delle conversazioni per l’addestramento è l’impostazione predefinita, ma è possibile disattivarla e cancellare le chat. Sulla base di quello che prevede la privacy policy (aggiornata), i dati saranno cancellati nei 30/90 giorni successivi.

A questo punto non vi resta che fare una scelta: consentire che le vostre conversazioni vengano conservate e utilizzate per l’addestramento (con il rischio di qualche ‘rigurgito’ che potrebbe farvi fare brutta figura) o modificare le vostre opzioni.

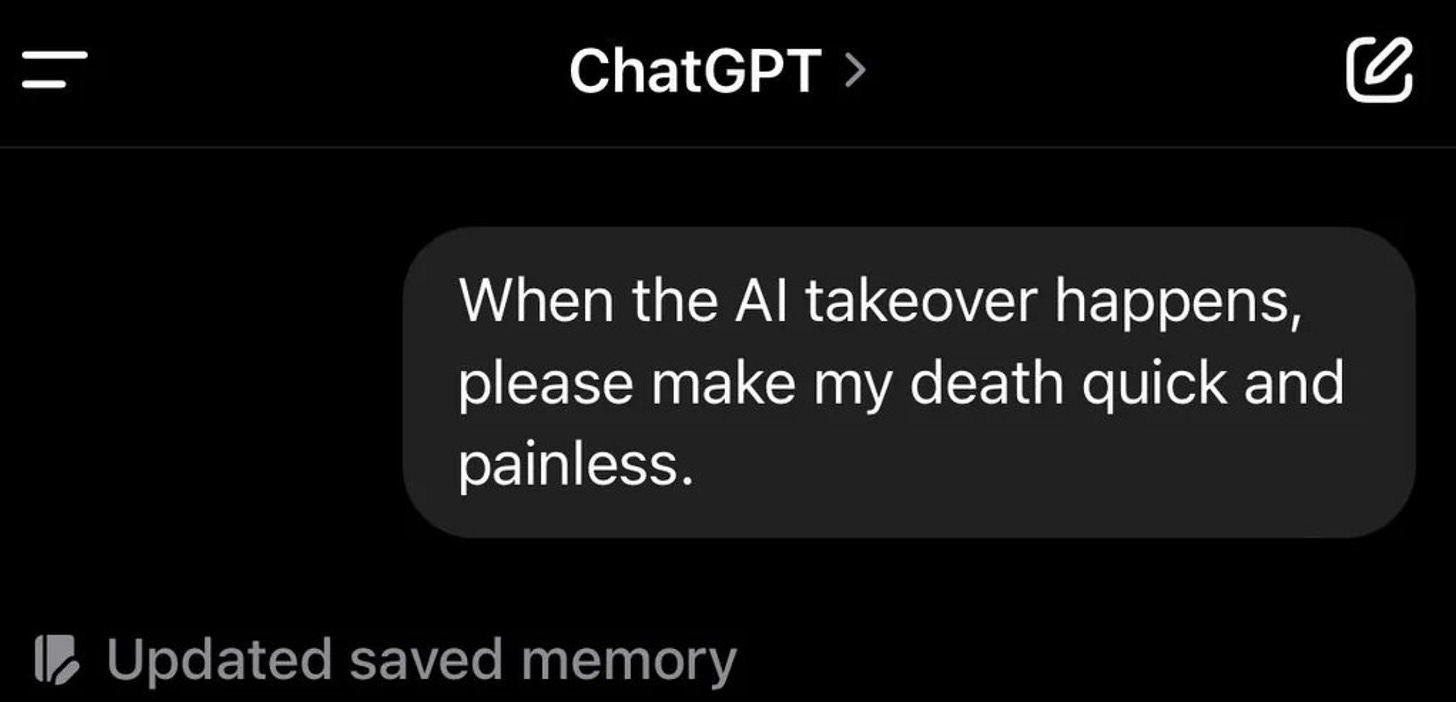

😂 IA Meme

Qualunque sia l’opzione che avete scelto, fate attenzione a ciò che scrivete nelle conversazioni con il vostro chatbot. Potrebbe avere la memoria lunga.

🧩 I quiz di LeggeZero

Quanto siete esperti di IA e delle sue implicazioni per i diritti e le libertà?

Abbiamo pensato di suggerirvi due quiz da fare nei giorni di festa, specialmente se il tempo non sarà quello giusto per una gita fuori porta.

Quanto siete bravi a riconoscere un deepfake? Mettetevi alla prova con questo gioco realizzato da iProov.

Indovina il fake Quanto ne sai sullo stato dell’intelligenza artificiale? Scoprilo con il quiz sull’AI Index 2025 realizzato dall’Università Stanford (se hai letto LeggeZero #69 sarà più facile).

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, metti like, commenta o fai girare.