🤖 Lo stato dell'arte dell'intelligenza artificiale- Legge Zero #69

Abbiamo letto le 450 pagine del rapporto annuale che l'Università di Stanford pubblica per fotografare il mondo dell'IA (e l'impatto dell'IA sul mondo). In questo numero trovate i dati più importanti.

🧠 Più umana degli umani

Mi propongo di considerare la domanda: “Le macchine possono pensare?”

Con queste parole cominciava l’articolo - al tempo stesso provocatorio e profetico - che Alan Turing pubblicò nel 1950 sulla rivista ‘Mind’ dal titolo “Computer Machinery and Intelligence” (qui ne trovate una traduzione italiana).

Questo saggio fondamentale affronta la questione se le macchine possano pensare e introduce il celebre ‘gioco dell'imitazione’, noto proprio come ‘test di Turing’. Questo esperimento prevede che un valutatore umano tenti di distinguere tra un essere umano e una macchina attraverso una conversazione scritta. Se la macchina riesce a ingannare il valutatore, viene considerata "intelligente".

Da allora, il test di Turing è diventato un benchmark per valutare l'intelligenza artificiale. Fino ad oggi.

Nei giorni scorsi, due ricercatori dell’Università della California hanno pubblicato un paper in cui riferiscono di aver sottoposto al test di Turing alcuni LLM: i valutatori umani hanno avuto conversazioni di 5 minuti simultaneamente con un altro essere umano e un modello di IA. Il risultato è stato sorprendente per ChatGPT-4.5 che ha ingannato il 73% dei valutatori umani (una percentuale superiore rispetto a quella raggiunta dai “veri” esseri umani), mentre altri modelli come LLaMa 3.1 e ChatGPT-4o hanno ingannato gli utenti rispettivamente nel 56% e nel 21% dei casi.

Certo, c’è chi fa notare come questo esperimento non misuri tanto l’intelligenza di un’IA quanto la capacità di imitare gli esseri umani e che, di conseguenza, ci sia bisogno di nuovi parametri per misurare l’IA. Nonostante ciò, il risultato di ChatGPT 4.5 è stato celebrato da alcuni come una pietra miliare per lo sviluppo dell'intelligenza artificiale, dal momento che dimostra la straordinaria evoluzione di questi sistemi che potrebbero presto sostituire le persone in diverse attività (senza che nessuno se ne accorga).

In questo contesto in rapidissima evoluzione, in cui assistiamo continuativamente a balzi tecnologici notevolissimi (basti pensare che lo stesso ChatGPT - 4.5 è stato rilasciato poco più di un mese fa), diventa sempre più complesso scattare una foto dello stato dell'arte dell'intelligenza artificiale che non risulti troppo sfocata.

Fortunatamente, nei giorni scorsi è stato pubblicato l’AI Index 2025. Si tratta dell’ottava edizione del documento - curato dall’Human-Centred AI Institute dell’Università di Stanford - che rappresenta una lettura imperdibile per gli addetti ai lavori, ma utilissima per chiunque voglia capirne di più sull’IA. Nonostante molti dei dati citati nelle ben 456 pagine del documento risalgano al 2024, l’AI Index è una bussola preziosa per comprendere le linee di sviluppo ed evoluzione del fenomeno, offrendo spunti interessanti sul presente e sul futuro, anche per il mondo della regolamentazione.

Ecco i punti principali.

Altro che “bolla”: la crescita esponenziale dell’IA

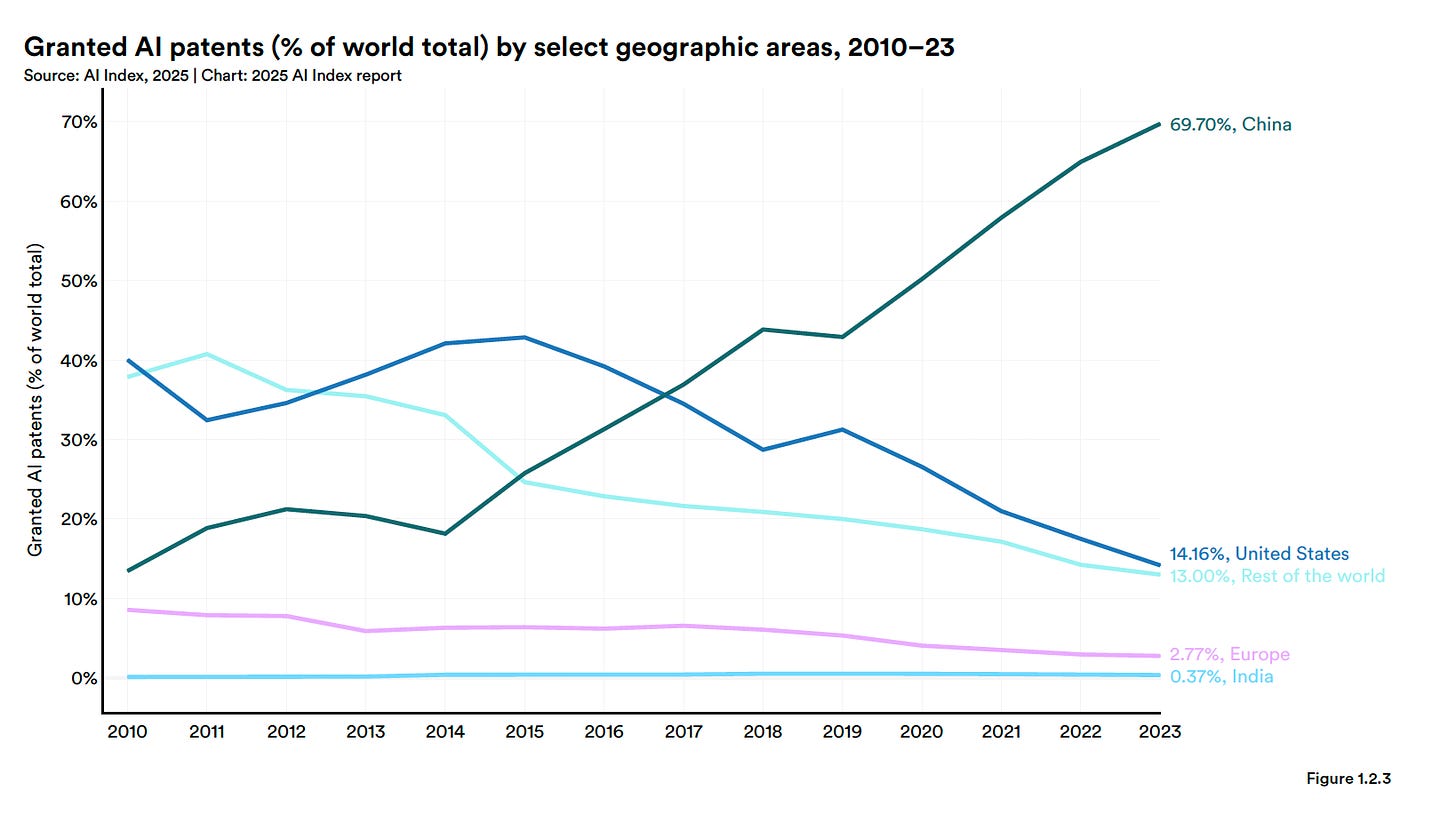

Il report di Stanford conferma che l’intelligenza artificiale sta crescendo a una velocità senza precedenti. Qualche numero: i brevetti legati all’IA si sono moltiplicati, passando dai 3.833 del 2010 ai ben 122.511 del 2023, con un incremento del 29,6% solo nell’ultimo anno.

Questo boom ha un Paese protagonista: la Cina, che da sola rappresenta il 69,7% di tutti i brevetti IA concessi nel mondo. Anche nella ricerca accademica la tendenza è simile: la Cina è prima per numero di pubblicazioni IA mentre gli Stati Uniti restano davanti solo per qualità (pubblicazioni più citate). In altre parole, la supremazia USA nel settore non è più così scontata.

L’ecosistema dei modelli IA ‘di rilievo’ - quelli più importanti - è sempre più globale: nel 2024 gli USA ne hanno sviluppati 40 contro i 15 cinesi e i 3 UE.

Ma non fatevi trarre in inganno da questi numeri assoluti: la qualità dei modelli cinesi è ormai vicinissima a quella americana. Le differenze di performance su benchmark chiave - che a fine 2023 vedevano i modelli USA avanti di anche 20-30 punti percentuali - a fine 2024 sono scese a pochi punti o azzerate (merito anche di prodotti come DeepSeek o Manus IA).

Anche sul fronte dei modelli open source c’è stata una interessante inversione di tendenza: il gap di performance tra i migliori modelli ‘aperti’ e quelli ‘proprietari’ si è notevolmente ridotto.

L’IA è ovunque

Dal punto di vista industriale e applicativo, questa corsa si traduce in costi in picchiata e adozione in salita. Secondo i ricercatori di Stanford “l'influenza dell'intelligenza artificiale sulla società non è mai stata così marcata”.

Alcuni esempi che vengono dal rapporto:

negli USA le autorità federali hanno approvato ben 223 dispositivi medici IA (erano appena 6 nel 2015);

i robotaxi Waymo forniscono ora oltre 150.000 corse autonome ogni settimana, normalizzando una tecnologia che pochi anni fa era pura fantascienza.

Mai così tanti incidenti

Non mancano, purtroppo, gli effetti collaterali di questa avanzata (forse troppo veloce): nel 2024 sono stati censiti 233 incidenti legati all’IA, un massimo storico che fa segnare un +56,4% rispetto al 2023.

Il report fa riferimento a casi documentati in cui sistemi IA hanno causato problemi, discriminazioni o danni alle persone (dal chatbot che ha istigato al suicidio, fino all’auto a guida autonoma che causa la morte di un pedone). Questo aumento può indicare sia l’uso più diffuso di IA in situazioni critiche, sia una maggiore attenzione nel segnalare e tracciare questi eventi. Insomma, parallelamente con la diffusione dell’IA crescono i rischi. E crescono anche le organizzazioni che iniziano a prestare attenzione a questi temi.

Cresce l’attenzione per lo sviluppo e l’uso responsabile di IA

L’AI Index registra un aumento delle organizzazioni che avviano progetti di ‘responsible IA’, adottando policy e misure di sicurezza in modo da mitigare i rischi.

Eppure, nelle aziende c’è ancora uno scollamento tra la consapevolezza del rischio e l’azione concreta: secondo un sondaggio condotto McKinsey, la maggior parte delle organizzazioni riconosce i principali rischi (come errori, mancata conformità normativa o usi malevoli), ma circa il 40% dichiara di non aver ancora adottato misure per mitigarli. Molte imprese, insomma, sanno che l’IA può far danni, però non hanno ancora implementato policy efficaci, un po’ come dire “sì la sicurezza informatica è importante” e poi annotare le password sui post-it (alzi la mano chi non li ha visti almeno una volta).

La buona notizia è che l’attenzione di sviluppatori e utilizzatori sta crescendo, e il merito è delle norme (specialmente di quelle europee).

L’anno delle regole

Secondo i dati riportati nell’AI Index, il 2024 è stato un anno intenso sul versante della regolazione, non solo in Europa.

Certo, il vecchio continente ha finalmente varato l’AI Act (la prima normativa organica sull’intelligenza artificiale), mentre gli USA non hanno ancora una legge a livello federale (e dopo l’elezione di Trump è verosimile che non l’adotteranno in tempi brevi).

Tuttavia, pur senza una legge vera e propria, le prescrizioni delle agenzie federali sull’IA (ad es. in ambito sanitario o per i trasporti) sono passate dalle 25 del 2023 alle 59 del 2024.

Per non parlare del fatto che i singoli Stati USA - nell’ultimo anno - hanno approvato moltissime leggi: da 49 del 2023 sono passate a 131 nel 2024, con un aumento del 167%.

Governi e pubbliche amministrazioni spendono sempre di più (per l’IA)

In tutto il mondo sta crescendo la spesa pubblica in materia di IA, ma le amministrazioni USA spendono (ancora) molto di più delle istituzioni europee.

Tuttavia, guardando bene, emerge un dato impressionante:

il 75% della spesa federale USA per l’IA è impiegato in ambito militare o per la difesa nazionale;

invece i governi europei dedicano meno dell’1% della spesa per IA al settore militare, concentrando gli sforzi sull’erogazione di servizi pubblici (64%).

Italia: poche luci, molte ombre

Veniamo al Bel Paese. Nell’AI Index ci sono alcuni dati che si riferiscono all’Italia, ma diciamolo subito: il nostro Paese non è protagonista e sembra relegato al ruolo di comprimario di questa rivoluzione.

Nessuno dei modelli IA “di rilievo” viene dall’Italia e i brevetti italiani in materia di IA rappresentano meno dell’1% a livello globale. Le offerte di lavoro legate all’IA sono soltanto l’1% del totale e nel settore manifatturiero - incredibilmente - cala il numero di robot utilizzati (-9% rispetto al 2023).

Tuttavia, la presenza italiana nella ricerca IA di livello internazionale è discreta e il nostro Paese si colloca al 15° posto per investimenti privati in IA (0,9 miliardi di dollari).

Dal punto di vista normativo, il nostro Paese va in controtendenza visto che il DDL sull’IA presentato dal Governo lo scorso anno, non è stato approvato nel corso del 2024.

Interessante, infine, il dato relativo alla percezione dell’IA da parte dell’opinione pubblica: gli italiani non sono né entusiasti né iper-scettici (né apocalittici né integrati). Ci collochiamo tra due opposti: nei paesi asiatici (come Cina, Indonesia) oltre l’80% delle persone vede positivamente i modelli e i sistemi di IA, mentre in paesi occidentali (come gli USA) la percentuale scende attorno al 40%.

La trasparenza dell’AI Index

La domanda potrebbe nascere spontanea: le 456 pagine dell’AI Index sono state scritte dai ricercatori o dall’IA? La risposta si trova in un disclaimer che vi riportiamo perché potrebbe essere un buon esempio di trasparenza nell’uso degli strumenti di intelligenza artificiale.

L’AI Index riconosce che, pur essendo stato redatto da un team di ricercatori umani, il processo di scrittura ha beneficiato del supporto di strumenti di intelligenza artificiale. In particolare, gli autori hanno utilizzato ChatGPT e Claude per affinare e rivedere le bozze iniziali. Il lavoro si è svolto con una prima stesura scritta dagli autori, seguita da interventi di editing realizzati anche con l’aiuto dell’IA.

🔊 Un vocale da… Laura Ferrari (Rete per i diritti umani digitali)

Che ruolo può giocare la società civile nella regolazione dell’intelligenza artificiale? E, nelle democrazie, come si possono conciliare la velocità di legiferare con le garanzie per il dibattito democratico?

Nel messaggio vocale di questa settimana, Laura Ferrari — Public Affairs Specialist di The Good Lobby — interviene a nome della Rete per i Diritti Umani Digitali (di cui fanno parte anche Privacy Network, Hermes Center, Strali e Amnesty International Italia), denunciando la compressione dei tempi parlamentari nell’iter del DDL 1146 appena approvato in Senato (ne abbiamo scritto in LeggeZero #66) .

Laura Ferrari mette in luce due aspetti cruciali rimasti fuori dal dibattito: la richiesta, ignorata, di un’autorità indipendente per l’IA — in linea con quanto suggerito dalla Commissione europea — e un emendamento sulla trasparenza dei sistemi di identificazione biometrica, fondamentale per valutare il loro impatto sui diritti fondamentali.

Ora che la proposta è passata all’esame della Camera, l’auspicio è chiaro: recuperare spazi di confronto pubblico, organizzare audizioni e restituire centralità alla voce della società civile.

💊 IA in pillole

A poco più di due anni dal suo lancio, lo scorso mese di marzo ChatGPT è diventata l’app più scaricata al mondo (escludendo i giochi), superando Instagram e TikTok. Probabilmente c’entra qualcosa la diffusione delle immagini nello stile di Studio Ghibli, ma potrebbe essere un trend destinato a ripetersi in futuro e che dimostra che l’IA (specialmente generativa) è più diffusa di quanto pensiamo.

Il governo britannico sta sviluppando un sistema di ‘previsione degli omicidi’ che utilizza IA per analizzare i dati personali di migliaia di persone note alle forze dell’ordine, con l'obiettivo di identificare chi ha maggiori probabilità di commettere omicidi.

Il progetto, inizialmente chiamato ‘homicide prediction project’ e ora rinominato ‘sharing data to improve risk assessment’, è stato scoperto dall’organizzazione Statewatch tramite una richiesta di accesso FOIA.

I critici descrivono il sistema come "agghiacciante e distopico", sostenendo che potrebbe rafforzare i pregiudizi contro le comunità razzializzate e a basso reddito, oltre a trattare una enorme mole di dati riguardanti salute mentale, dipendenze e disabilità.

Ricordate la sanzione del Garante Privacy a OpenAI per 15 milioni di euro in relazione a ChatGPT? (ne abbiamo parlato in LeggeZero #55). OpenAI ha fatto ricorso e il Tribunale di Roma, con un’ordinanza del 21 marzo 2025 (non ancora pubblicata), ha disposto la sospensione cautelare della sanzione, subordinandola al pagamento di una cauzione da parte di OpenAI. Questa decisione congela temporaneamente l’efficacia del provvedimento del Garante.

Durante un'udienza a New York il 26 marzo 2025, Jerome Dewald, 74enne imprenditore nel settore dell’IA, ha usato un avatar IA per rendere dichiarazioni dinanzi al Tribunale.

La giudice ha interrotto il video non appena si è resa conto che il relatore non era Dewald, chiedendo spiegazioni. Dewald ha ammesso che si trattava di un avatar chiamato ‘Jim’, generato attraverso la piattaforma Tavus, poiché ha difficoltà a parlare a lungo. La giudice ha espresso il suo disappunto, affermando: "Non userai questa aula di tribunale come trampolino di lancio per il tuo business." Se non ci credete, potete vedere il video qui sotto.

😂 IA Meme

L’IA ha imparato (benissimo) a imitare gli esseri umani. Riuscirà a farlo anche con altre specie?

📣 Eventi

Master “CAIO, il Chief AI Officer della pubblica amministrazione” - Webinar, 31.03-17.04.2025

CAIO Summit - New York, 16.04.2025

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.

Numero davvero utilissimo! Soprattutto perché ci risparmia di leggere 450 pagine di report! :) Grazie!