🤖 La mappa mondiale delle leggi sull'IA – Legge Zero #28

Alla vigilia del G7 italiano sull'intelligenza artificiale, abbiamo realizzato e pubblicato una mappa delle leggi mondiali in materia di IA. La tecnologia corre, i legislatori provano a starle dietro.

🧠 Il diritto di mettere in guardia

Siamo dipendenti ed ex dipendenti di aziende leader nel settore dell’IA, e crediamo nel potenziale di questa tecnologia per offrire benefici senza precedenti all'umanità. Tuttavia, conosciamo anche i gravi rischi posti da questi sistemi.

Comincia così la lettera di 13 ex dipendenti di OpenAI, Anthropic e Google. Hanno scritto un appello alle loro ex società, con la benedizione di tre guru nel campo dell’IA: Yoshua Bengio, Geoffrey Hinton e Stuart Russell. Rivendicano il diritto di mettere in guardia l’opinione pubblica sui rischi dell’intelligenza artificiale (‘the right to warn’ appunto). Alcuni di loro però sono anonimi, non possono firmare l’appello con il proprio nome, in quanto hanno sottoscritto contratti con clausole che impediscono loro di parlare dei problemi collegati allo sviluppo dei sistemi di IA a cui hanno lavorato.

Per questi motivi chiedono ai provider di IA:

1. di non fare più firmare accordi che inibiscano ai loro dipendenti di criticare pubblicamente le scelte fatte in relazione alla mitigazione dei rischi di sicurezza;

2. di prevedere un processo di whistleblowing che consenta ai dipendenti - in modo anonimo - di segnalare ai manager, alle istituzioni di vigilanza e alla società civile le preoccupazioni legate ai rischi di sicurezza;

3. di consentire ai dipendenti di discutere pubblicamente i rischi dell’IA, proteggendo ovviamente i segreti commerciali;

4. di non attuare ritorsioni contro i dipendenti che condividono pubblicamente informazioni riservate sui rischi, dopo che altri tentativi hanno fallito.

Si tratta di un’iniziativa che merita di essere seguita, ma che dimostra che il mercato - per ammissione degli stessi protagonisti di questa rivoluzione - non è capace, da solo, di essere sufficientemente trasparente, di regolamentarsi adeguatamente e di affrontare efficacemente i rischi connessi allo sviluppo di sistemi avanzati di IA.

Per questo c’è bisogno delle regole.

Per questo, in tutto il mondo - non solo in Europa con l’AI Act - si stanno moltiplicando leggi sull’intelligenza artificiale, a partire da quelle legate alla difesa dal fenomeno dei deepfake.

Noi di LeggeZero - da alcune settimane e con la fondamentale collaborazione di Piersoft, uno dei più importanti civic hacker italiani - abbiamo iniziato a raccoglierle su una mappa in continuo aggiornamento (dalla Cina alla California, passando per il vecchio continente). La trovate qui. È una mappa in cui abbiamo deciso di tracciare le norme sovranazionali, quelle statali, quelle regionali e anche gli atti di soft law (per comodità di lettura, li troverete contrassegnati con colori diversi).

Naturalmente, in questo momento di grande fermento globale, è più che probabile che qualche provvedimento esserci sfuggito. In questo caso, vi chiediamo di segnalarcelo a scrivi@leggezero.ai. L’obiettivo è quello di facilitare la conoscenza, la comprensione e la comparazione delle varie normative internazionali.

Mettetela tra i preferiti: con la collaborazione di tutti, ci impegniamo a tenerla aggiornata.

🔊 Un vocale da… Giovanni Maria Riccio (E-Lex): come si legge la mappa sulle leggi dell’IA nel mondo? come interpretare le differenze tra i diversi ordinamenti? Nel vocale di questa settimana, alcuni utili consigli per evitare giudizi frettolosi.

📰 Dal MIT di Boston un chatbot per parlare con il sé del futuro

Se avessimo la possibilità parlare con i noi “del futuro”, cosa chiederemmo? Un gruppo di ricercatori del MIT di Boston ha annunciato la creazione di un nuovo chatbot progettato per aiutare le persone a prendere decisioni di vita più sagge (qui l’articolo di The Guardian che ha pubblicato anche il video che trovate sotto).

L'idea alla base del chatbot "Future Self" è quella di permettere agli utenti di conversare con una versione futura di sé stessi, con l'obiettivo di esplorare le conseguenze delle proprie azioni e decisioni attuali. Gli sviluppatori sperano che questa tecnologia - che per funzionare ha bisogno di tanti dati personali dell’utente - possa diventare uno strumento prezioso per il miglioramento personale, la pianificazione della carriera e il raggiungimento di obiettivi a lungo termine.

Lo trovate più affascinante o inquietante?

📰 Negli USA 🇺🇸 un’IA è candidata a Sindaco di una città

Ci siamo già occupati dell’uso dell’IA nelle campagne elettorali (per esempio, in LeggeZero #26 e LeggeZero #14), eppure questa sembra una prima volta. Nella città di Cheyenne, nel Wyoming, un'intelligenza artificiale di nome Vic (che sta per ‘Virtual Integrated Citizen’ e usa la tecnologia di OpenAI) compare tra i sei candidati Sindaco (l’elenco ufficiale è pubblicato qui).

Se l’idea era quella di sfruttare una falla nel sistema di presentazione delle candidature per una provocazione politica, l’obiettivo appare centrato. Per il resto, in base alle leggi attualmente vigenti, un’IA non può ancora diventare Sindaco: parafrasando Michael Moore, possiamo dire che ‘la democrazia non è uno spot per bot’.

⚖️ Dal Garante europeo per la protezione dei dati 🇪🇺 arrivano le prime indicazioni sull'uso delle IA generative da parte delle istituzioni UE L'Autorità europea per la protezione dei dati (EDPS) ha pubblicato un interessante documento riguardante l'uso delle intelligenze artificiali generative da parte delle istituzioni dell'Unione Europea.

Con queste prime indicazioni - destinate alle istituzioni UE ma utili per tutte le amministrazioni europee - l'EDPS mira a garantire che l'uso delle IA generative sia conforme alle normative sulla protezione dei dati e rispetti i diritti e le libertà fondamentali degli individui.

Il documento contiene alcune raccomandazioni chiave, tra cui:

l’importanza di effettuare valutazioni d'impatto sulla protezione dei dati (DPIA) prima di implementare soluzioni di IA generativa;

l’adozione di misure di sicurezza adeguate per proteggere i dati personali trattati dalle IA generative;

la trasparenza nell'uso delle IA, assicurando che gli utenti siano informati quando interagiscono con sistemi automatizzati;

la necessità di formazione specifica per il personale delle istituzioni UE sull'uso responsabile e sicuro delle IA generative.

⚖️ Privacy e Dati Personali sotto Attacco? NOYB contro l’addestramento delle IA di Meta sui dati degli utenti di Instagram e Facebook

Ne avevamo scritto la scorsa settimana (LeggeZero #27): Meta sta informando tutti gli utenti europei dei cambiamenti alla sua privacy policy, anche in relazione all’addestramento dell’IA con i dati personali di chi ha un account Instagram e Facebook.

In relazione a tale attività NOYB (None of Your Business), l'organizzazione di difesa della privacy fondata da Max Schrems, ha chiesto ai Garanti Privacy di 11 Paesi europei (tra cui l’Italia) di intervenire immediatamente per fermare l'uso improprio dei dati personali da parte di Meta per l’addestramento delle sue IA.

Secondo NOYB, Meta sta raccogliendo e utilizzando i dati personali degli utenti in modo illecito per addestrare e migliorare i suoi modelli di AI, violando così le normative sulla protezione dei dati. L'organizzazione ha evidenziato diverse preoccupazioni, tra cui:

Raccolta Illegittima dei Dati: Meta starebbe utilizzando i dati personali senza il consenso esplicito degli utenti, un requisito fondamentale secondo il GDPR (Regolamento Generale sulla Protezione dei Dati).

Uso dei Dati per l'IA: i dati raccolti sarebbero impiegati per addestrare gli algoritmi di intelligenza artificiale, ma senza trasparenza sulle modalità di utilizzo e senza garanzie sufficienti per la protezione della privacy degli utenti (per chi non si oppone, in futuro, sarà impossibile esercitare il diritto all’oblio?).

Il modulo di opposizione: NOYB contesta la farraginosità del meccanismo di opposizione (definito “una farsa”) che renderebbe troppo complesso evitare l’addestramento sui propri dati.

Adesso leggeremo la difesa di Meta e vedremo se le 11 Autorità riusciranno a provvedere prima del 26 giugno (il termine in cui diventerà operativa la nuova privacy policy), ma soprattutto cosa decideranno sul tema centrale: il legittimo interesse è una base giuridica a cui è possibile fare ricorso per le attività di addestramento?

😂 IA Meme

L’IA ci ucciderà tutti o risolverà da sola ogni problema? Nel meme di questa settimana - ricondiviso anche da Elon Musk - un po’ di autoironia sul tecnodeterminismo che si respira in Silicon Valley.

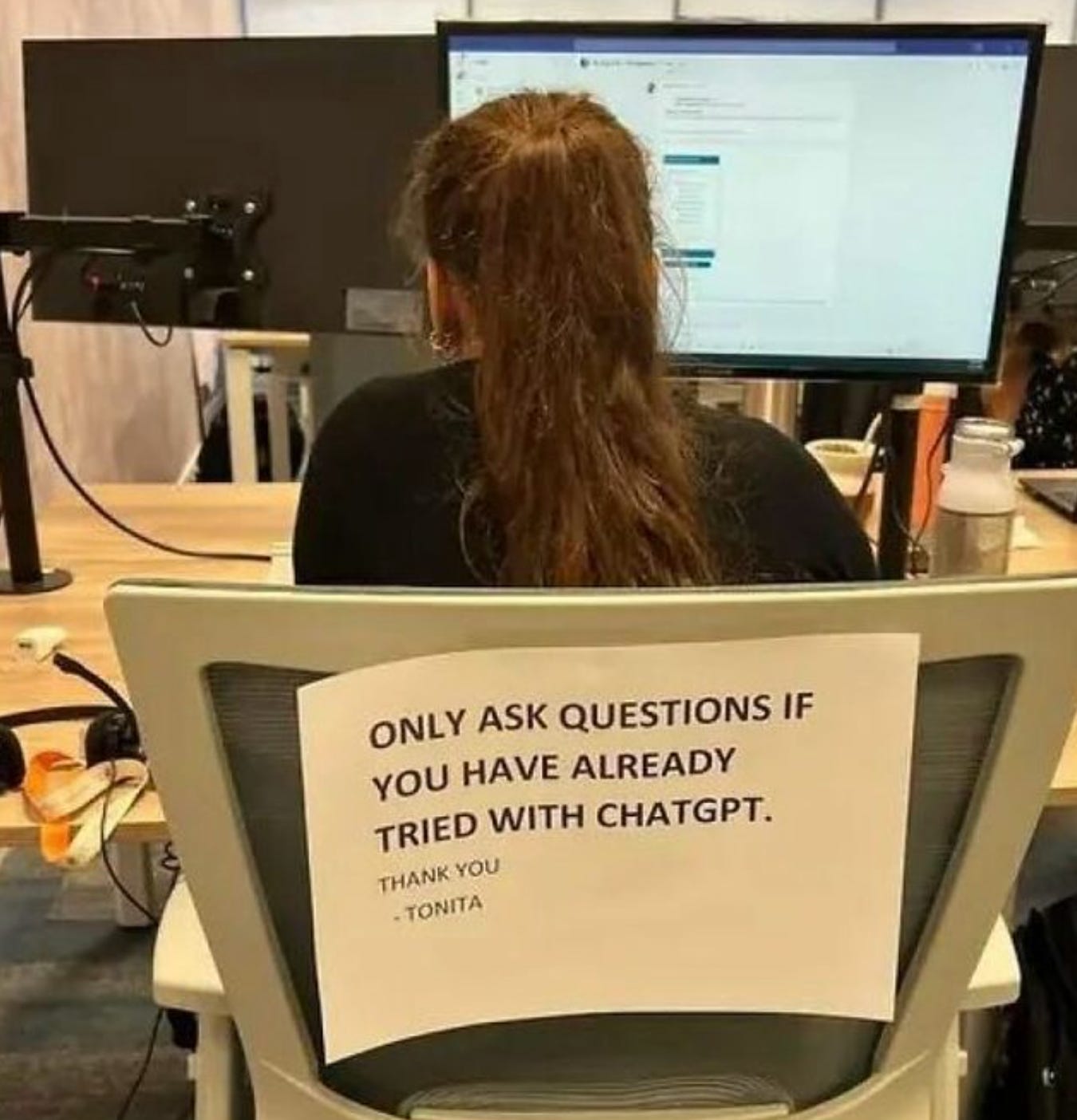

😂 IA Meme che non lo erano

Stanca delle domande dei colleghi, Tonita ha scritto un cartello che - ne siamo sicuri - in tanti appenderanno nei propri uffici.

📚 Consigli di lettura: “Senza allucinazioni? Valutare l’affidabilità dell’IA nel settore legale” di V. Magesh, F. Surani, M. Dahl, M. Suzgun, C. D. Manning e D. E. Ho

L'introduzione dell'intelligenza artificiale negli studi legali ha sollevato interrogativi sulla sua affidabilità, specialmente in contesti ad alto rischio (ne abbiamo scritto LeggeZero #27 commentando l’esordio di ChatGPT in una sentenza della Cassazione).

Nell'articolo "Hallucination-Free? Assessing the Reliability of Leading AI Legal Research Tools”, alcuni ricercatori dell'Università di Stanford e di Yale hanno valutato le affermazioni di alcuni fornitori riguardo alla presunta eliminazione delle “allucinazioni” nei loro strumenti di ricerca giuridica (rispetto a ChatGPT).

Spoiler: le allucinazioni, allo stato dell’arte, non sono completamente eliminabili, anche se le IA specializzate generano risposte errate in misura inferiore rispetto a ChatGPT, ma comunque tra il 17% e il 33% delle volte. Tuttavia, questo non significa che, sotto un adeguato controllo umano, questi strumenti possano essere potentissimi per gli avvocati (e i loro clienti).

Servono regole (per i fornitori e i professionisti) e formazione.

📚 Consigli di lettura: “IA e democrazia” la summer reading list dell’Università di Harvard

Volete approfondire gli impatti dell’intelligenza artificiale sulle nostre democrazie? Volete farlo in modo rigoroso evitando titoli sensazionalistici? Non sapete come orientarvi tra tutte le centinaia di pubblicazioni in materia di IA? Siete alla ricerca di cosa leggere in vacanza?

Ecco quello che fa per voi: la lista di letture estive su IA e democrazia pubblicata dalla Kennedy School dell’Università di Harvard. Questo elenco - 6 libri, 4 saggi e 2 conferenze - offre una panoramica su come, per alcuni tra i più importanti esperti al mondo, l'IA sta plasmando il futuro della governance e della partecipazione civica, esplorando le implicazioni etiche, sociali e politiche di questa tecnologia emergente.

Un elenco prezioso di letture, magari da fare in vacanza, su come fare in modo che le democrazie escano migliori da questa rivoluzione.

💬 Il dibattito sull’IA

“A volte voglio partecipare a una call, e allora lo faccio. Se non voglio, posso inviare un “gemello digitale”. Questo sarà il futuro”.

Lo ha detto Eric Yuan, CEO di Zoom, in un’intervista concessa a The Verge, raccontandoci una delle funzionalità a cui stanno lavorando: un gemello digitale che non solo è in grado di prendere gli appunti, ma anche le decisioni al posto nostro, o magari condurre una trattativa. Forse è il caso di ragionare fin da subito sulle implicazioni lavoristiche. Potremo essere mai obbligati dalla nostra azienda ad avere un gemello digitale per ragioni di efficienza? Chi risponderà nel caso di decisione assunta dal gemello digitale?

📣 Eventi

We Make Future 2024- Bologna, 13-15.06.2024

Privacy Tour 2024: la protezione dei dati personali nell’era dell’IA generativa - Napoli, 18.06.2024

Salesforce World Tour - Milano, 18.06.2024

Tech Tour 2024 - Firenze, 21.06.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.