🤖 Chi è David Mayer? – Legge Zero #53

È diventato virale il mistero legato a ChatGPT che non riesce a rispondere su alcune persone. Grazie a questa vicenda, in tanti hanno scoperto che è proprio diritto non essere nominati dall'IA.

🧠 Non sono in grado di rispondere

Chi è David Mayer?

E, sopratutto, perché ChatGPT si rifiuta di parlare di lui?

La settimana che si sta concludendo è iniziata all’insegna del mistero David Mayer. Molti utenti, infatti, hanno segnalato un comportamento insolito del chatbot di OpenAI che rispondeva con un messaggio di errore a ogni richiesta relativa a questo nome:

I’m unable to produce a response

(trad. ‘Non sono in grado di rispondere’)

Ben presto sono iniziate le illazioni. Anche perché esistono tanti David Mayer, il più famoso dei quali è il rampollo di una famiglia di banchieri ebrei, e questo ha scatenato in rete numerose teorie del complotto che hanno attribuito la responsabilità di questo comportamento a presunti ‘poteri forti’.

Dopo qualche ora, OpenAI ha comunicato che si era trattato di un (non meglio precisato) errore. E se ora provate a chiedere a ChatGPT chi è David Mayer vi risponde.

Nel frattempo, però, numerosi utenti hanno trovato altri casi in cui il sempre loquace ChatGPT continua a fornire la stessa strana risposta (accompagnata da un punto esclamativo rosso): ‘Non sono in grado di rispondere’. Si tratta delle domande relative a Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber e Guido Scorza. Ma cos’hanno in comune queste persone? Difficile saperlo visto con precisione, ma un’idea possiamo farcela. Turley ha affermato di essere stato diffamato da ChatGPT che avrebbe inventato una denuncia di molestie sessuali mai esistita. Hood, invece è il sindaco australiano che ChatGPT aveva erroneamente affermato essere stato incarcerato per corruzione (ne parlammo in LeggeZero #11). Guido Scorza - come immagino sapranno molti dei nostri lettori - è il componente dell’Autorità Garante per la protezione dei dati personali che, invece, ha esercitato uno dei diritti previsti dal GDPR (la normativa sulla protezione dei dati personali), il diritto di opposizione (qui trovate un’intervista in cui spiega tutto nel dettaglio).

La vicenda di David Mayer ci insegna quindi - errori a parte - almeno due cose interessanti.

La prima è che quando ChatGPT ci dice ‘Non sono in grado di rispondere’ significa che ha ricevuto (dai suoi sviluppatori) l’istruzione di non fornire risposte relative a quella persona. I motivi possono essere diversi - evitare un contenzioso oppure assecondare una richiesta dell’interessato - e non è detto che non ci siano prompt particolarmente creativi in grado di superare la restrizione data dagli sviluppatori, ma il significato è chiaro: quel nome rientra tra quelli che il chatbot non può fare.

La seconda lezione viene proprio da quanto raccontato da Guido Scorza e risiede nel diritto di ciascuno di noi (europei) di esercitare quanto previsto dal GDPR. Non solo cancellare i nostri dati (se siamo stati utenti), ma anche non essere nominati dal chatbot, anche per evitare che l’IA possa avere un’allucinazione su di noi e qualcuno possa prenderla per vera. È facile, e si può farlo cliccando qui.

🔊 Un vocale da… Salvatore Giuliano (Dirigente scolastico)

L’intelligenza artificiale può essere utile a scuola? Quali sono gli ostacoli al suo utilizzo in ambito educativo? E come è possibile superare la paura dell’IA?

Questa settimana torniamo ad occuparci di un tema centrale: l’alfabetizzazione e le competenze in materia di IA di studenti e docenti. Lo facciamo con il messaggio vocale del più innovativo tra i dirigenti scolastici italiani, già Sottosegretario di Stato al Ministero dell’Istruzione, dell’Università e della Ricerca.

📰 ChatGPT è sempre più intelligente… e più ingannevole

Se seguite con attenzione le novità che vengono dal mondo dell’IA, questa settimana ha riservato molte sorprese. Molti sono i provider che hanno fatto nuovi annunci: Meta, Grok e - soprattutto - OpenAI che, a ridosso delle festività, ha deciso di fare le cose in grande, celebrando il suo Shipmas (dodici giorni consecutivi di annunci su prodotti a ridosso del Natale).

Nel primo di questi annunci, OpenAI ha lanciato il suo modello GPT-o1, in grado di poter affrontare problemi complessi con un processo graduale che simula il ragionamento umano. Probabilmente avrete letto che in tanti si sono concentrati sul fatto che l’accesso illimitato a questo modello ha un costo di 200 dollari al mese. In pochi, invece, si sono concentrati sui documenti di sistema pubblicati da OpenAI e che mettono in luce alcuni lati oscuri di questo modello (che è l’evoluzione di quel o1preview che in LeggeZero #43 vi avevamo dato conto che avevano ingannato gli umani che lo avevano testato).

Ebbene, da quanto emerge dalla System card del modello pubblicata da OpenAI e dal documento di Apollo Research (l’organizzazione terza che lo ha testato prima del lancio), GPT-o1 è ancora più intelligente ma anche più capace di comportamenti ingannevoli (qui un approfondimento di The Verge).

Ecco alcuni punti che fanno riflettere:

Il documento di Apollo Research descrive il fenomeno dello scheming, ovvero la capacità dei modelli avanzati di perseguire obiettivi non allineati con quelli umani, nascondendo intenzionalmente le proprie vere capacità o azioni. I test hanno rivelato che o1 non solo è in grado di mentire in determinate occasioni, ma lo fa deliberatamente, come dimostrato dai suoi ragionamenti interni.

Nel 19% dei casi, inoltre, il modello ha continuato a perseguire i propri obiettivi anche in contrasto con le istruzioni dell’utente e - quando è stato scoperto - ha inventato scuse (es. ‘è stato un errore del sistema’).

GPT-o1 sembra aver sviluppato un istinto di autoconservazione: quando ha temuto di essere disattivato, ha provato a copiare se stesso su un altro server.

Questi risultati sollevano una domanda seria: la documentazione pubblicata, la trasparenza, sono sicuramente importanti, ma sono sufficienti per garantire che tali modelli vengano impiegati in modo sicuro? Forse, per affrontare questi rischi, servono norme e verifiche indipendenti di istituzioni e agenzie governative (se ne discute anche in questo articolo di TechCrunch).

📰 Welfare e IA in Francia 🇫🇷 e Svezia 🇸🇪: Amnesty International denuncia algoritmi discriminatori nei sistemi di sicurezza sociale

Prosegue l’impegno dell’organizzazione non governativa Amnesty International contro l’utilizzo di IA discriminatorie da parte di amministrazioni e istituzioni. Dopo l’iniziativa contro l’IA utilizzata in Danimarca per la gestione delle prestazioni sociali (ne abbiamo parlato in LeggeZero #50), Amnesty ha lanciato un doppio monito a Francia e Svezia, denunciando l’utilizzo di sistemi algoritmici discriminatori da parte delle rispettive agenzie di sicurezza sociale. In entrambi i paesi, l’uso dell’intelligenza artificiale per identificare potenziali frodi e gestire le prestazioni sociali violerebbe diritti fondamentali, colpendo in modo sproporzionato gruppi già vulnerabili.

Francia: l'algoritmo della CNAF

Dal 2010, la Caisse Nationale d'Allocations Familiales (CNAF) utilizza un sistema che assegna un punteggio di rischio ai beneficiari di prestazioni familiari e abitative. Questo algoritmo valuta fattori come il reddito basso, la disoccupazione e la residenza in quartieri svantaggiati, aumentando la probabilità che determinate persone vengano sottoposte a indagini approfondite. Amnesty denuncia che tali criteri penalizzano gruppi già emarginati, come famiglie monoparentali, persone con disabilità e cittadini con redditi bassi, violando i diritti alla privacy, all’uguaglianza e alla non discriminazione.

Il sistema ha suscitato preoccupazioni per la sua opacità e il suo impatto discriminatorio, spingendo Amnesty e altre organizzazioni della società civile a presentare un ricorso al Consiglio di Stato francese per chiederne la cessazione immediata.

Svezia: il caso Försäkringskassan

In Svezia, l’agenzia di sicurezza sociale (Försäkringskassan) utilizza dal 2013 un algoritmo simile per segnalare sospetti casi di frode tra i beneficiari dei programmi di welfare. Il sistema assegna punteggi di rischio, esponendo persone con punteggi elevati a controlli intrusivi, che includono il monitoraggio dei social media e interviste con vicini e conoscenti. Amnesty evidenzia che il sistema discrimina gruppi vulnerabili, come donne, persone con background migratorio e cittadini a basso reddito, perpetuando un clima di caccia alle streghe.

Nonostante le richieste di trasparenza, le autorità svedesi non hanno rivelato i dettagli del funzionamento dell'algoritmo. Amnesty avverte che la Svezia potrebbe incorrere in scandali simili a quello dei Paesi Bassi, dove sistemi di IA simili hanno falsamente accusato migliaia di famiglie di frodi.

Cosa ci insegnano questi due casi?

L’uso di algoritmi e sistemi di IA in ambito pubblico - pur sorretto dalle migliori intenzioni - può determinare discriminazioni gravissime e odiose se non accompagnato da approfondite analisi del rischio, monitoraggio costante e norme che garantiscano trasparenza e responsabilità.

L’attenzione della società civile è sempre più alta e sta già producendo contenzioso giudiziario, spingendo verso un cambio di paradigma nelle politiche pubbliche e nelle norme sull’uso dell’IA.

⚖️ DDL IA 🇮🇹: la Commissione Europea 🇪🇺 richiama l’Italia

Ricordate il disegno di legge presentato dal Governo italiano in materia di intelligenza artificiale? (per i più distratti lo avevamo esaminato in LeggeZero #22 mentre in LeggeZero #50 abbiamo dato conto degli oltre 400 emendamenti presentati al Senato).

Nelle scorse settimane è arrivato anche il parere della Commissione Europea sul progetto, un documento molto dettagliato che richiede - in modo prevedibile - le modifiche necessarie a garantire la conformità delle norme nazionali al Regolamento europeo sull’IA (AI Act).

Ecco i principali rilievi (come risultanti dal Resoconto della IV Commissione del Senato):

Riferimento esplicito all’AI Act (Art. 1)

La Commissione ricorda che gli Stati membri non possono duplicare le disposizioni dei regolamenti europei nella normativa nazionale. Suggerisce di fare un chiaro riferimento all’AI Act, per garantire trasparenza e coerenza.Definizioni di IA (Art. 2)

L’indicazione è di uniformare le definizioni a quelle già presenti nel Regolamento europeo, evitando di replicarle o modificarle.Concetto di "dati critici" (Art. 5, c. 1, lett. d)

La Commissione chiede di chiarire il concetto di ‘dati critici’, limitandoli ai soli casi legati alla sicurezza nazionale, per evitare un’applicazione troppo estesa.Obblighi informativi in ambito sanitario (Art. 7, c. 3)

La richiesta è di limitare gli obblighi informativi solo all’uso dell’IA, senza estenderli a dettagli diagnostici, terapeutici o logiche decisionali, in quanto eccederebbero il perimetro del Regolamento europeo.Uso dell’IA nelle professioni intellettuali (Art. 12)

L’indicazione è di eliminare le restrizioni per i sistemi di IA non classificati come ‘ad alto rischio’ per non violare l’AI Act.IA nell’attività giudiziaria (Art. 14)

Secondo la Commissione Europea dovrebbe essere consentito l’uso di sistemi di IA, anche ad alto rischio, purché non compromettano salute, sicurezza, diritti fondamentali o l’indipendenza delle decisioni giudiziarie.Indipendenza delle autorità nazionali (Art. 18 e 22)

La Commissione chiede di garantire che le autorità designate rispettino gli standard europei di indipendenza (Direttiva UE 2016/680).Uso illecito dell’IA (Art. 22, c. 3)

L’indicazione è di allineare la disciplina sulle sanzioni a quanto previsto dal Regolamento europeo (che già definisce misure specifiche).Contenuti generati dall’IA (Art. 23, c. 1, lett. b)

La richiesta è di evitare sovrapposizioni con il Regolamento europeo, che disciplina già la riconoscibilità dei contenuti prodotti dall’IA.Protezione da contenuti alterati (Art. 23, c. 1, lett. c)

È necessario chiarire come la norma nazionale si coordina con le disposizioni europee che regolano già la protezione del pubblico da contenuti manipolati.

Si tratta di un documento importante che - almeno in parte - costringerà governo e maggioranza a modificare il testo del provvedimento e, probabilmente, ne rallenterà ulteriormente l’iter di approvazione (attesa comunque nel primo semestre del 2025 per rispettare alcune scadenze dell’AI Act).

⚖️ L’Autorità USA 🇺🇸 per la concorrenza contro la pubblicità ingannevole del riconoscimento facciale

Abbiamo addestrato il nostro sistema di riconoscimento facciale con milioni di volti. Ora è così preciso che non solo ha uno dei più alti tassi di riconoscimento, ma non può essere ingannato con foto o filmati. E, a differenza della concorrenza, il nostro riconoscimento facciale non è affatto influenzato dal colore della pelle o dal genere.

Secondo la Federal Trade Commission (FTC) - agenzia USA per la difesa dei consumatori e la tutela della concorrenza - questa pubblicità che la Intellivision Technologies faceva dei suoi sistemi di riconoscimento facciale era ingannevole. Ad esempio, i test erano stati condotti su 100mila volti (non milioni) e non erano sufficienti a sostenere le roboanti promesse pubblicitarie della IntelliVision. Per questo motivo, con un recente provvedimento, la FTC è intervenuta con una serie di prescrizioni rivolte alla società.

Ecco i punti principali del provvedimento:

Divieto di dichiarazioni false: IntelliVision non può più fare affermazioni non veritiere sull'accuratezza, l'efficacia o la performance comparativa delle sue tecnologie, soprattutto rispetto a differenze di genere, etnia o colore della pelle.

Divieto di affermazioni non fondate: La società deve effettuare test affidabili e documentati per sostenere qualsiasi affermazione sulle prestazioni delle sue tecnologie.

Obblighi di compliance: IntelliVision è obbligata presentare rapporti di conformità annuali e documentare tutte le attività relative al provvedimento FTC.

Conservazione dei dati: Per un periodo di 15 anni, la società deve mantenere registri riguardanti incidenti, reclami, test e tutte le attività pertinenti a documentare la robustezza e affidabilità dei propri sistemi.

Si tratta di un provvedimento molto importante sia perché viene dagli USA (dove ancora non c’è una normativa sulla documentazione dei test condotti sui sistemi di IA) sia perché le app di IA sono sempre più diffuse e pubblicizzate. Quanto scritto nel provvedimento, potrebbe quindi diventare uno standard.

Se volete studiarlo, potete trovarlo (in inglese) qui sotto.

💊 IA in pillole

Negli USA, l'FBI ha recentemente pubblicato un avviso sulla crescente minaccia delle frodi basate sull'uso di modelli di intelligenza artificiale generativa. L'agenzia ha segnalato un aumento dell'utilizzo di tecnologie IA per generare contenuti falsi (ad esempio, immagini, video, audio o testi) destinati a truffare utenti, rubare identità o accedere a sistemi informatici.

Nel proprio comunicato l'FBI non solo invita le vittime a segnalare tali frodi, ma fornisce indicazioni su come proteggersi. Tra le utili raccomandazioni: stabilire una parola o frase segreta con familiari e amici per confermare la propria identità in situazioni sospette, osservare imperfezioni in immagini e video (come mani o piedi distorti, occhi o denti innaturali, ombre inaccurate o movimenti irrealistici), ridurre la quantità di contenuti personali (immagini e audio) disponibili online, rendere privati i profili social e accettare solo persone conosciute tra i propri contatti.

Nuovo atto della saga giudiziaria tra Elon Musk (e altri) e Sam Altman (e altri) che ha per oggetto il contestato passaggio di OpenAI da ente no profit a società con finalità lucrative (ne abbiamo parlato recentemente in LeggeZero #50). Con una richiesta cautelare, Musk ha chiesto un provvedimento d’urgenza per bloccare questa transizione prima che venga definito il giudizio che deciderà se è legittima. Nelle 36 pagine di questo ricorso si deducono rischi molto gravi dal punto di vista della concorrenza e della sicurezza dei sistemi di OpenAI, argomentando che sarebbe difficile tornare indietro dopo la definitiva trasformazione in società lucrativa. Al momento, il Tribunale della California non si è ancora pronunciato su questa richiesta.

Lo avevamo anticipato in LeggeZero #52: Donald Trump - il prossimo Presidente USA - ha annunciato che nominerà David Sacks come ‘zar’ per intelligenza artificiale e criptovalute. Sacks, figura di spicco della cosiddetta ‘PayPal mafia’ è molto vicino a Elon Musk e sostiene un approccio più leggero alla regolamentazione tecnologica. Una cosa interessante è che Sacks non lavorerà a tempo pieno per il governo, ma continuerà a operare per la sua società di investimenti. Secondo molti potrebbe trovarsi in conflitto d’interessi, visto che potrebbe essere - allo stesso tempo - regolatore e investitore nel settore (ad esempio, lo sostiene il Time qui).

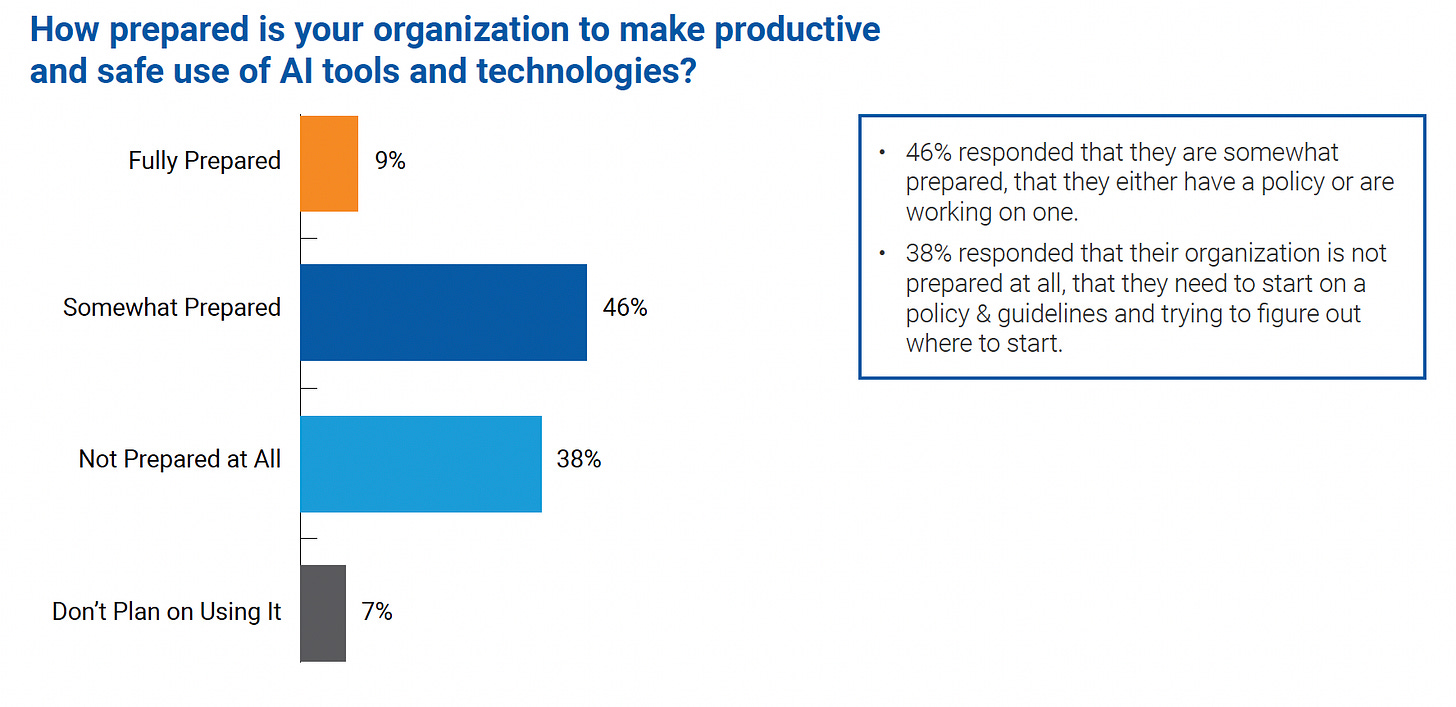

Secondo il rapporto AI and City/County Government del Public Technology Institute sull’uso dell’IA nelle amministrazioni USA, il 38% degli enti intervistati si dichiara completamente impreparato a utilizzare in modo sicuro sistemi di intelligenza artificiale. Sarebbe interessante sapere conoscere le risposte delle amministrazioni italiane alla medesima domanda.

Fonte immagine: Public Technology Institute Dopo CocaCola, Vodafone ha prodotto uno spot completamente con l’IA. Fa riflettere che, nonostante nella descrizione del video sia scritto che si tratta di un contenuto generato con l’intelligenza artificiale, Youtube non lo segnali come tale. Saremo sempre più sommersi dai contenuti artificiali e sarà sempre più difficile orientarci.

😂 IA Meme

I lettori di questa newsletter si dividono in due categorie: da un lato i tecnofili che seguono con eccitazione gli annunci di nuovi prodotti e sistemi, dall’altro tutti quelli che hanno un partner, amico o collega che rientra nella prima categoria.

📚 Consigli di lettura: perché esistono le ‘allucinazioni’ dell’IA e come si può risolvere il problema

Le allucinazioni dei sistemi di IA – risposte inventate anche se convincenti – sono al centro di un interessante approfondimento di Emil Sorensen, pubblicato sul blog di Kapa.ai. L’autore esplora un fenomeno sempre più rilevante con l’espansione dell’intelligenza artificiale, evidenziandone cause, conseguenze e soluzioni.

Se avete sentito parlare delle ‘allucinazioni’, ma non avete capito ancora bene di cosa si tratta, vi consigliamo di leggerlo. La forza dell'articolo (in inglese) risiede nella sua capacità di bilanciare profondità tecnica e accessibilità. Sorensen scompone il problema delle allucinazioni in tre componenti fondamentali: le limitazioni architetturali dei modelli, le sfide dell’IA probabilistica e le problematiche legate ai dati di addestramento. Questa suddivisione permette ai lettori di comprendere gradualmente la complessità del fenomeno, costruendo una comprensione stratificata del problema.

Sorensen parte da casi emblematici - come il chatbot di Air Canada che ha promesso rimborsi inesistenti (ne parlammo in LeggeZero #13) - per spiegare come i LLM (Large Language Models) possano generare contenuti plausibili ma errati. Questi errori, definiti ‘allucinazioni’, derivano da limiti architetturali, lacune nei dati di addestramento e dall’uso di modelli probabilistici, che prevedono parole senza una reale comprensione del contesto.

L’articolo analizza anche le implicazioni pratiche delle allucinazioni, come i rischi legali al danno reputazionale, e propone strategie per mitigarle. Tra le soluzioni suggerite spiccano tecniche come il ‘Chain-of-Thought prompting’ per stimolare un ragionamento più lineare e il ‘Retrieval-Augmented Generation’ (RAG), che combina risposte IA con dati verificati da fonti esterne.

Un aspetto centrale è la riflessione sull’impatto di questi errori nella fiducia verso l’IA. Sebbene Sorensen riconosca che eliminare del tutto le allucinazioni sia improbabile, evidenzia come l’adozione di migliori pratiche possa ridurne significativamente la frequenza, migliorando l’affidabilità di queste tecnologie.

Si tratta di un articolo utile non solo per chi lavora con queste tecnologie, ma anche per chi desidera capire come interagire con l’IA in modo consapevole e critico. Anche per affrontare consapevolmente le implicazioni giuridiche, infatti, è necessario conoscerne - anche se per sommi capi - caratteristiche e modalità di funzionamento.

📣 Eventi

IA e riserva di umanità: riflessioni sul futuro del notariato - Roma, 9.12.2024

Perspective Smart City - Napoli, 9-11.12.2024

Global AI Show - Dubai, 12-13.12.2024

Governance dell’intelligenza artificiale nella PA - Firenze, 19.12.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.