🤖 L'impatto dell'elezione di Trump sulle regole dell'IA – Legge Zero #49

Meno regole e vincoli per l'IA: questa la linea della nuova amministrazione USA targata Trump (e Musk). La distanza con l'Europa sembra destinata a crescere, delineando due approcci contrapposti.

🧠 Più innovazione, meno regole

Complimenti al Presidente Trump. Gli auguro grande successo nel suo mandato.

È di fondamentale importanza che gli Stati Uniti mantengano la loro leadership nello sviluppo dell'IA basata su valori democratici.

Sono queste le parole postate su X (il social di Elon Musk) da Sam Altman, il CEO di OpenAI, uno dei principali protagonisti della scena IA mondiale. Non sembrano auguri di maniera, come quelli di altri CEO della Silicon Valley.

Nel messaggio di Altman - che non è in buoni rapporti con uno dei principali consiglieri di Trump, Elon Musk (che gli ha fatto causa due volte per l’evoluzione di OpenAI da non profit a operatore commerciale) - c’è la sfida che ci attende in materia di regolazione dell’IA.

Le scelte regolatorie in materia di intelligenza artificiale si situano tra due poli complementari: promuovere e incentivare l'innovazione, garantendo l'avanzamento tecnologico, e salvaguardare i valori democratici, inclusa la protezione dei diritti fondamentali.

Si tratta di una sfida globale che l’Europa ha già deciso di affrontare, da tempo, con un approccio normativo molto strutturato di cui l’AI Act rappresenta soltanto l’ultimo dei tasselli (che si aggiunge a GDPR e DSA). Invece, l’esito delle elezioni presidenziali statunitensi appena tenutesi porterà gli USA su una strada molto diversa.

Nell’ultimo anno, pur senza una vera e propria legge federale, l’amministrazione Biden-Harris aveva lavorato all’adozione e attuazione di un ordine esecutivo destinato a tutte le agenzie federali e destinato a promuovere la massima sicurezza dei sistemi (specialmente quelli utilizzati dalle amministrazioni federali). A tanti questa strategia sembrava il primo passo verso l’adozione di una legge nazionale simile, per approccio, alle norme europee. In questo senso andava anche la costituzione di una task force parlamentare bipartisan incaricata di lavorare a regole condivise.

La vittoria di Trump cambia - e di molto - le carte in tavola. Il futuro Presidente ha già dichiarato che, tra i primi suoi atti, ci sarà proprio la revoca dell’executive order di Biden sull’intelligenza artificiale, provvedimento ritenuto un freno all’innovazione e che potrebbe rallentare la competitività USA rispetto alla Cina. Se anche l’abrogazione non fosse immediata, è facile prevedere che da oggi comunque le agenzie federali non si prodigheranno particolarmente per l’attuazione di un provvedimento (l’executive order di Biden) la cui sorte è ormai segnata.

Restano però diverse incognite (qui ne vengono analizzate alcune). Innanzitutto non è chiaro se Trump si limiterà ad abrogare il provvedimento adottato dal suo predecessore o emanerà un proprio ordine esecutivo (forse pochi ricordano che Trump aveva firmato un executive order sull’IA già nel febbraio 2019). C’è poi da considerare che se il nuovo Presidente e il suo partito decideranno di non regolare l’IA a livello federale, si assisterà ad una proliferazione di norme a livello di singoli stati (come accaduto sui deepfake in campagna elettorale, materia su cui hanno approvato leggi più di 30 dei 50 Stati USA). Paradossalmente, l’adozione di una legge federale potrebbe porre un freno all’attivismo dei singoli legislatori locali. A questo va aggiunto che Elon Musk, oltre ad essere direttamente impegnato nel settore dell’IA, è tra coloro che sono più preoccupati dei potenziali impatti catastrofici dell’IA (tanto che era a favore della legge su cui il Governatore della California ha posto il veto alcune settimane fa).

Quello che è certo distanza tra Stati Uniti ed Europa - anche in materia di regolamentazione tecnologica - sembra destinata ad aumentare visto che l’obiettivo dichiarato della nuova amministrazione è, da un lato, quello di non rallentare lo sviluppo di IA sempre più potenti e, dall’altro, quello di accelerare sull’uso di sistemi di IA da parte delle pubbliche amministrazioni (privilegiando efficienza e produttività sulla prevenzione dei rischi).

Il dibattito globale sulle regole dell’IA resterà caldo per molto tempo ancora, anche questo è certo.

🔊 Un vocale da… Vincenzo Cosenza (Consulente IA)

Stiamo assistendo a una mutazione degli strumenti di IA generativa. Infatti, stiamo passando dall’utilizzo di chatbot agli ‘agenti’ autonomi’, strumenti in condizione di operare per nostro conto. Di cosa si tratta? Quali sono le principali questioni che pongono? Nel vocale di questa settimana ce ne parla un esperto, autore della

.

📰 Robert Downey Jr. ha già dato mandato ai suoi legali per opporsi a eventuali repliche IA realizzate dopo la sua morte.

Robert Downey Jr., l’attore statunitense celebre per il suo ruolo in Iron Man, ha dichiarato durante un'intervista al podcast ‘On With Kara Swisher’ che intende opporsi legalmente a qualsiasi tentativo di replicare la sua immagine digitale dopo la sua morte. Downey ha affermato che, anche postumo, il suo studio legale ‘sarà molto attivo’ nel perseguire chi proverà a farlo.

Questa presa di posizione s'inserisce in un dibattito più ampio sul ruolo delle repliche digitali nel settore dell'intrattenimento, dopo che il sindacato degli attori ha ottenuto nuove protezioni contrattuali contro l'uso indiscriminato dell'immagine degli interpreti tramite IA (ne scrivemmo all’indomani dell’intesa sindacale in LeggeZero #1).

È verosimile pensare che saranno sempre più gli artisti che - per difendersi dall’avidità di produttori ed eredi - lasceranno disposizioni specifiche in tal senso. Infatti, l’uso dell’intelligenza artificiale per riportare in vita personaggi famosi e creare nuovi contenuti di intrattenimento sembra sempre più diffuso.

In Inghilterra, ad esempio, Sir Michael Parkinson, noto conduttore britannico scomparso nell'agosto 2023 all'età di 88 anni, tornerà virtualmente sulla scena con un nuovo podcast intitolato ‘Virtually Parkinson’. Questa serie di otto episodi - promossa proprio dal figlio del conduttore - presenterà interviste generate tramite intelligenza artificiale con varie celebrità, utilizzando IA per replicare la voce e lo stile di Parkinson (agli ospiti, alla fine, sarà chiesto cosa hanno provato a farsi intervistare da un’IA).

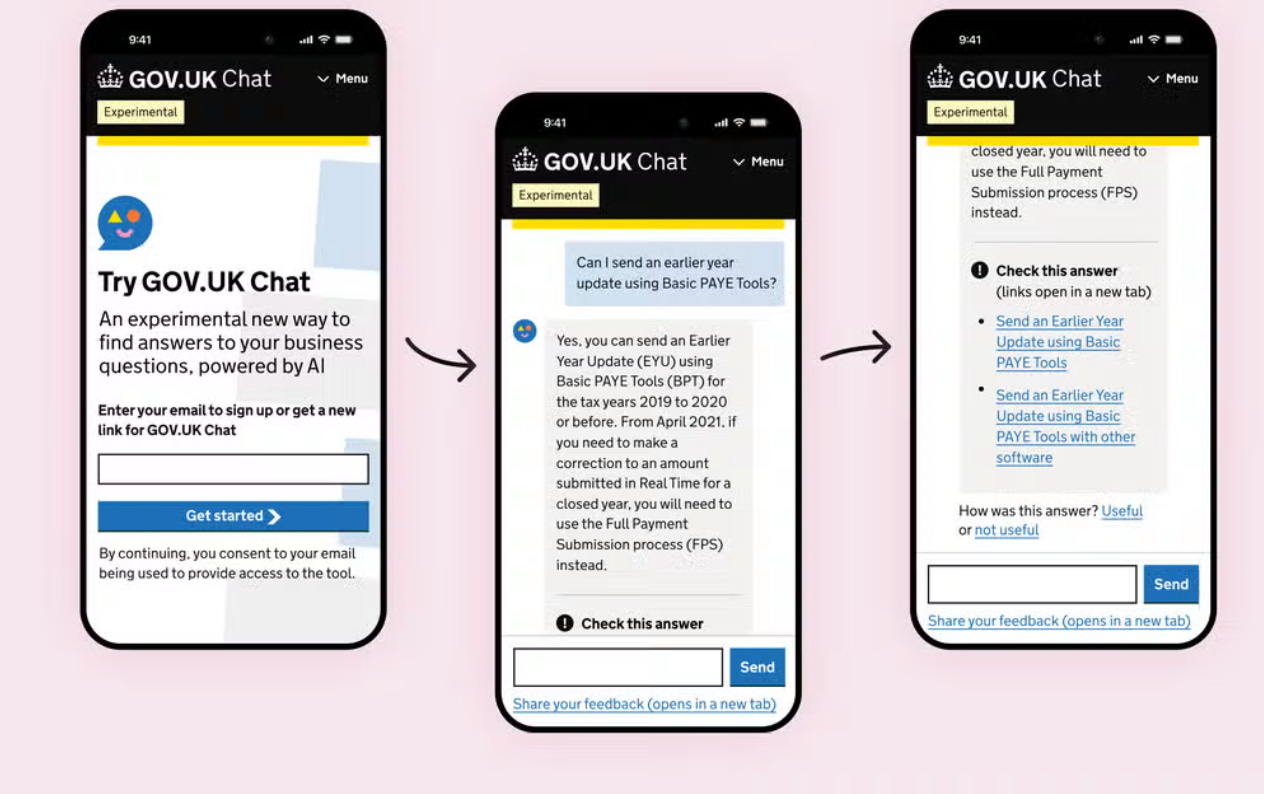

📰 Arriva GPT.GOV, il chatbot del governo UK 🇬🇧 per le imprese

Uno studio governativo ha rivelato che gli inglesi impiegano complessivamente 3 miliardi di ore all’anno in attività legate a procedimenti amministrativi (comunicazioni, richieste, consultazione documenti, appuntamenti con funzionari pubblici). Si tratta, in media, di 56 ore all’anno per ciascun cittadino adulto.

Per questo motivo, dopo il lancio di ChatGPT, il Governo UK - da anni tra i più attivi sui temi dell’innovazione - ha iniziato a sperimentare come utilizzare l’IA generativa nei rapporti con gli utenti. In particolare, ha iniziato a sviluppare un chatbot - basato proprio sulla tecnologia di OpenAI - con l’obiettivo di semplificare i rapporti tra cittadini e pubblica amministrazione.

Qualcuno potrebbe obiettare che non si tratti di un progetto particolarmente innovativo, ed è così. Quello che è veramente innovativo è il metodo con cui il Dipartimento per la Scienza, l’Innovazione e la Tecnologia sta conducendo questo progetto.

Innanzitutto, è stato condotto uno studio - i cui risultati sono stati pubblicati (ne parlammo in LeggeZero #9) - per comprendere se questa tecnologia fosse affidabile e con quali accorgimenti utilizzarla. Dopo questa fase e un importante lavoro sui ‘guardrail’ (le istruzioni date al modello per evitare usi impropri o dannosi), nei giorni scorsi è stata lanciata una sperimentazione di GPT.GOV (questo potrebbe essere il nome del chatbot). Per alcune settimane il bot risponderà alle domande di 15mila imprenditori betatester (ad esempio ‘come si apre una società?’, oppure ‘come si registra un marchio?’). Sono state implementate misure volte a rilevare a quali domande il chatbot non dovrebbe rispondere (es. perché potrebbe fornire risposte fuorvianti oppure sbilanciarsi prendendo posizioni politiche).

Alla fine di questa sperimentazione i dati saranno analizzati e si deciderà se l’applicazione è matura per essere utilizzata da tutti i cittadini.

Un approccio decisamente responsabile all’uso dell’IA in ambito pubblico.

⚖️ ChatGPT vs. Editori 1-0: Tribunale USA 🇺🇸 archivia azione per violazione del copyright

C’è molta attesa per l’esito dei tanti giudizi promossi da autori ed editori contro i provider di IA per violazione del copyright durante la fase di addestramento dei loro modelli (ne abbiamo scritto in LeggeZero #6, LeggeZero #21, LeggeZero #24 e LeggeZero #32). In questi giorni è arrivata una delle prime decisioni ed è favorevole ai provider.

Raw Story Media e Alternet Media, due testate giornalistiche statunitensi, avevano avviato un'azione legale contro OpenAI dinanzi al Tribunale di New York, sostenendo che i loro contenuti siano stati utilizzati illegalmente per addestrare ChatGPT, senza licenza e senza corresponsione di un compenso.

Secondo le accuse, OpenAI avrebbe violato il Digital Millennium Copyright Act (DMCA), anche perché ChatGPT è in grado di generare risposte che potrebbero includere parti significative di articoli senza attribuzione, causando quindi agli editori un danno economico e di reputazione.

Con un'ordinanza dello scorso 7 novembre, il giudice ha archiviato il caso per mancanza di prove da parte delle testate, ritenendo che la loro difesa non abbia dimostrato un danno concreto, necessario per proseguire con il giudizio.

Il provvedimento - che potete scaricare qui sotto - non contiene un riconoscimento di legittimità delle attività di scraping di OpenAI, ma richiede a tutti coloro che affermano di essere danneggiati da tale prassi di provare puntualmente il danno che avrebbero subito. Prova per nulla facile da fornire.

⚖️ In Italia 🇮🇹 è stata presentata una proposta di legge per l’istituzione di un’Autorità indipendente sull’IA (ma il Governo non è d’accordo)

L’individuazione delle autorità competenti a vigilare sui sistemi di IA è uno dei punti più delicati dell’attuazione a livello nazionale del Regolamento europeo sull’intelligenza artificiale (AI Act).

In Italia, un gruppo di senatori di opposizione ha presentato un disegno di legge per la creazione di un’autorità nazionale indipendente: l’Autorità Nazionale per l’Intelligenza Artificiale e le Neurotecnologie.

La proposta è stata realizzata in collaborazione con la neonata ‘Rete diritti umani digitali’, composta da Privacy Network, The Good Lobby e il Centro Hermes per la Trasparenza e i Diritti umani digitali, organizzazioni della società civile molto attive su questi temi (ne avevamo parlato in Legge Zero #18, trovate qui la loro proposta originaria). La proposta, dunque, si pone in alternativa all’attuale scelta del Governo, contenuta nel disegno di legge A.S.1146, di designare le agenzie governative Agid e ACN quali autorità nazionali per l’IA (trovate un approfondimento in Legge Zero #22).

Con tale iniziativa, quindi, i promotori puntano a rimettere in discussione la scelta sul soggetto incaricato di effettuare il monitoraggio sull’applicazione dell’AI Act. Sono in tanti a pensare che debba essere un’autorità indipendente (i cui vertici, cioè, non siano nominati dal Governo) a garantire che il processo di attuazione delle normative in materia di IA avvenga nel pieno rispetto dei diritti fondamentali e dei principi sanciti a livello europeo.

Al momento, e salvo colpi di scena, appaiono scarse le probabilità che tale scelta venga condivisa dalla maggioranza.

💊 IA in pillole

I servizi segreti USA stanno usando un cane da guardia robotico per pattugliare la tenuta di Donald Trump a Mar-a-Lago, in modo da garantire una maggiore sicurezza. Questo cane robotico, realizzato dalla Boston Dynamics, ha attrezzature di sorveglianza e sensori avanzati. C’è anche una scritta che dice ‘Non accarezzare’ (Fonte video: @collinrugg)

‘Cosa significa quando improvvisamente puoi fare 8.000 dollari di lavoro in 5 minuti con soli 3 dollari di crediti API?’ Lo ha chiesto retoricamente Kevin Weil (Chief Product Officer di OpenAI) alla platea di un evento, quando ha rivelato che il loro nuovo modello ‘O1’ sarebbe in grado di redigere documenti legali, un lavoro finora riservato ad avvocati con tariffe da 1.000 dollari l’ora. Non ha detto però in quanti minuti può finire il lavoro di un CPO.

Un recente rapporto dell'ufficio di revisione contabile olandese ha evidenziato come il governo di quel Paese utilizzi già centinaia di sistemi IA, ma solo una piccola percentuale di questi è stata sottoposta a una rigorosa valutazione dei rischi. Inoltre, nonostante l'esistenza di un registro ufficiale degli algoritmi - istituito in seguito allo scandalo delle discriminazioni nell’assegnazione dei sussidi per l'infanzia - solo il 5% dei 433 sistemi basati sull'IA utilizzati o testati è stato inserito in questo registro. I dubbi sollevati nel rapporto mettono in evidenza la potenziale tendenza a sottostimare il rischio associato all'IA a beneficio dell’efficienza dei risultati.

In Polonia, il Governo ha deciso di avviare una consultazione pubblica sul disegno di legge nazionale in materia di IA. La proposta, composta da 88 articoli, prevede l’istituzione di una nuova Commissione per le attività di vigilanza del mercato e di un Consiglio sociale (composto da rappresentanti di lavoratori e datori di lavoro) come organo consultivo sulle politiche di IA.

Ricordate il primo quadro di robot umanoide messo all’asta di cui abbiamo parlato in LeggeZero #47? È stato venduto per 1,1 milioni di dollari (la base d’asta era 120mila dollari).

😂 IA meme

Il 30 novembre 2024 saranno due anni dal lancio di ChatGPT, una ricorrenza importante (specialmente per quelli che ancora non sono stati sostituiti da un’IA).

😂 meme IA … che non lo erano

Anche le IA si annoiano, o almeno così sembra.

Nelle scorse settimane, Anthropic aveva annunciato di aver insegnato al suo modello di IA (Claude) a eseguire autonomamente una serie di operazioni sui computer degli utenti, tra cui la ricerca sul web, l’apertura di applicazioni, l’inserimento di testo con il mouse e la tastiera.

L’autonomia concessa a Claude aveva sollevato interrogativi riguardo alla possibilità che il modello possa eseguire azioni non pianificate, creando potenziali rischi sia per la sicurezza informatica sia per il corretto svolgimento delle attività assegnate.

Nessuno aveva ipotizzato risvolti ironici o paradossali. Ci ha pensato direttamente Anthropic - con grande trasparenza - a rendere noto che, durante una dimostrazione, Claude, forse annoiato, ha aperto Google e ha iniziato a guardare bellissime foto del parco nazionale di Yellowstone (qui un articolo di Futurism). Se non ci credete, guardate il video qui sotto.

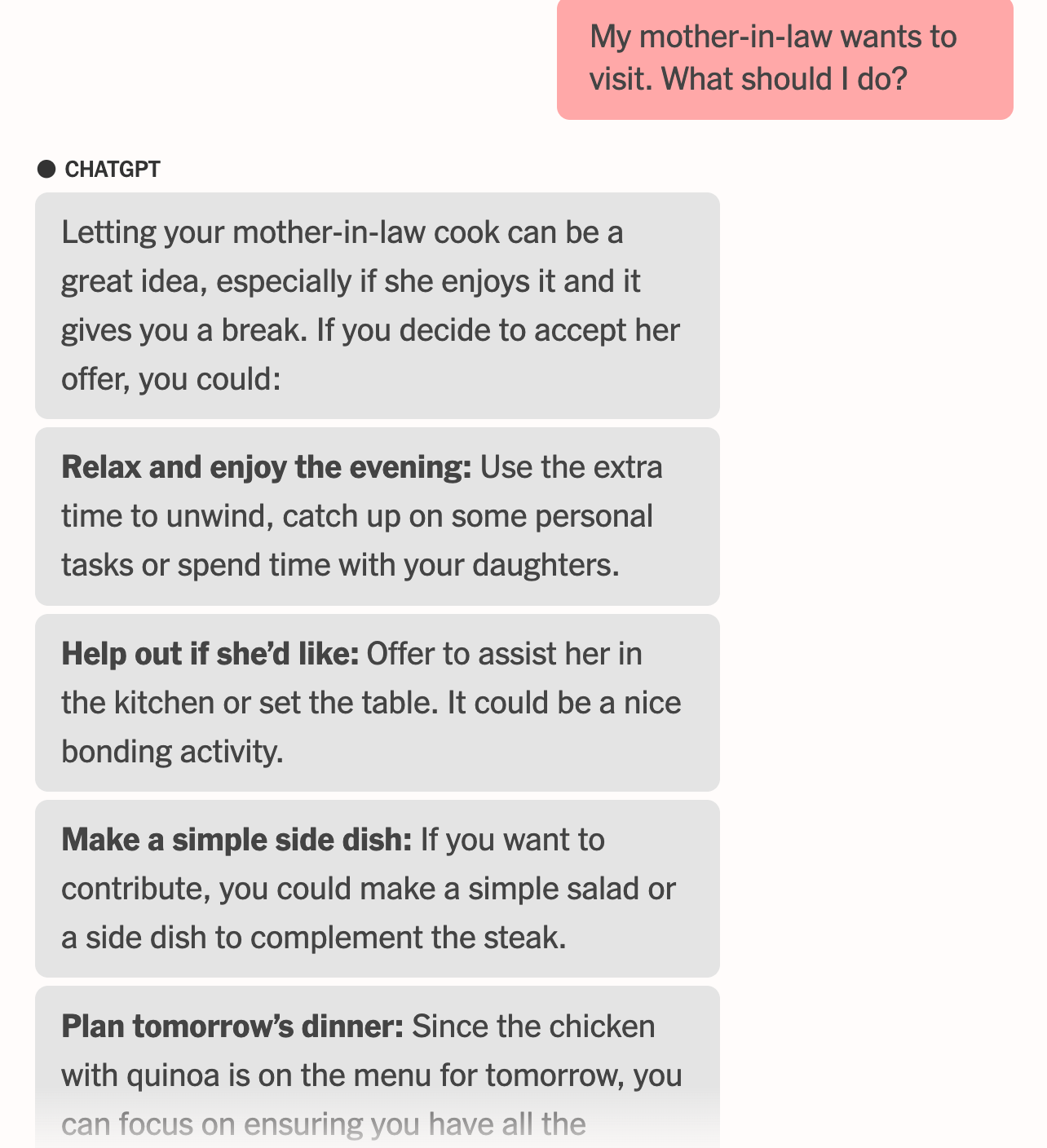

📚 Consigli di lettura: il New York Times racconta l'esperimento di vivere una settimana seguendo esclusivamente i consigli dell'IA

In un interessante esperimento (che potete leggere qui), una giornalista del New York Times, Kashmir Hill, ha affidato tutte le sue decisioni quotidiane a una serie di strumenti di intelligenza artificiale, per esplorare come queste tecnologie possono influenzare le nostre vite.

Nel tentativo di semplificare la gestione del quotidiano, Hill ha preso una ‘pausa dalle decisioni’ (decision holiday) di una settimana, lasciando che l’IA determinasse cosa mangiare, indossare, come trascorrere il tempo con le figlie, rispondere alla suocera e persino come decorare il suo ufficio.

Questo esperimento evidenzia il potenziale pratico dell'IA come strumento di ottimizzazione e riduzione dello stress legato all’assunzione delle decisione, ma ha anche sollevato questioni su come l'automazione possa appiattire l'individualità.

L'articolo - tra le altre cose - mette in luce le diverse risposte dei vari chatbot impiegati durante la settimana. Mentre alcuni assistenti digitali, come ChatGPT, sembravano entusiasti di offrire consigli e di gestire qualsiasi richiesta, altri, come Claude di Anthropic, si sono mostrati più cauti e persino riluttanti a prendere decisioni su aspetti personali. Claude, noto per il suo approccio più etico e rispettoso delle limitazioni dell’IA, ha risposto evidenziando i rischi di lasciare a un’intelligenza artificiale il controllo di scelte importanti. In generale, tutti i bot tendevano a standardizzare le decisioni, proponendo spesso soluzioni generiche e ‘sicure’.

L’esperienza di Hill offre uno spunto di riflessione su come l’IA, sebbene semplifichi la vita, possa anche appiattire l’espressione personale e ridurre l’autenticità. Questo esperimento rappresenta un interessante esempio delle sfide etiche e psicologiche legate alla - più o meno consapevole - delega di decisioni quotidiane alle IA, invitando a riflettere sul giusto equilibrio tra efficienza, quieto vivere e autenticità.

Ad esempio, mentre di fronte ad alcune risposte troppo accondiscendenti la suocera ha avuto il dubbio se ci fosse lo zampino dell’IA, quando ha la Hill ha risposto al marito che andava bene che lui andasse a giocare a golf, il consorte ha capito subito che non era stata lei a scriverlo.

📣 Eventi

AgentForce World Tour - Milano, 21.11.2024

Forum della non autosufficienza - Bologna, 27-28.11.2024

Perspective Smart City - Napoli, 9-11.12.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.