🤖 Ti faresti curare da un'IA? - Legge Zero #77

Sempre più persone usano l'IA in caso di problemi medici o come supporto psicologico. Pochi, però, sono consapevoli di limiti e rischi, mentre le norme fanno fatica a tenere il passo.

🧠 IA & salute: promesse rivoluzionarie, rischi concreti e norme che provano a regolarne lo sviluppo e l’uso

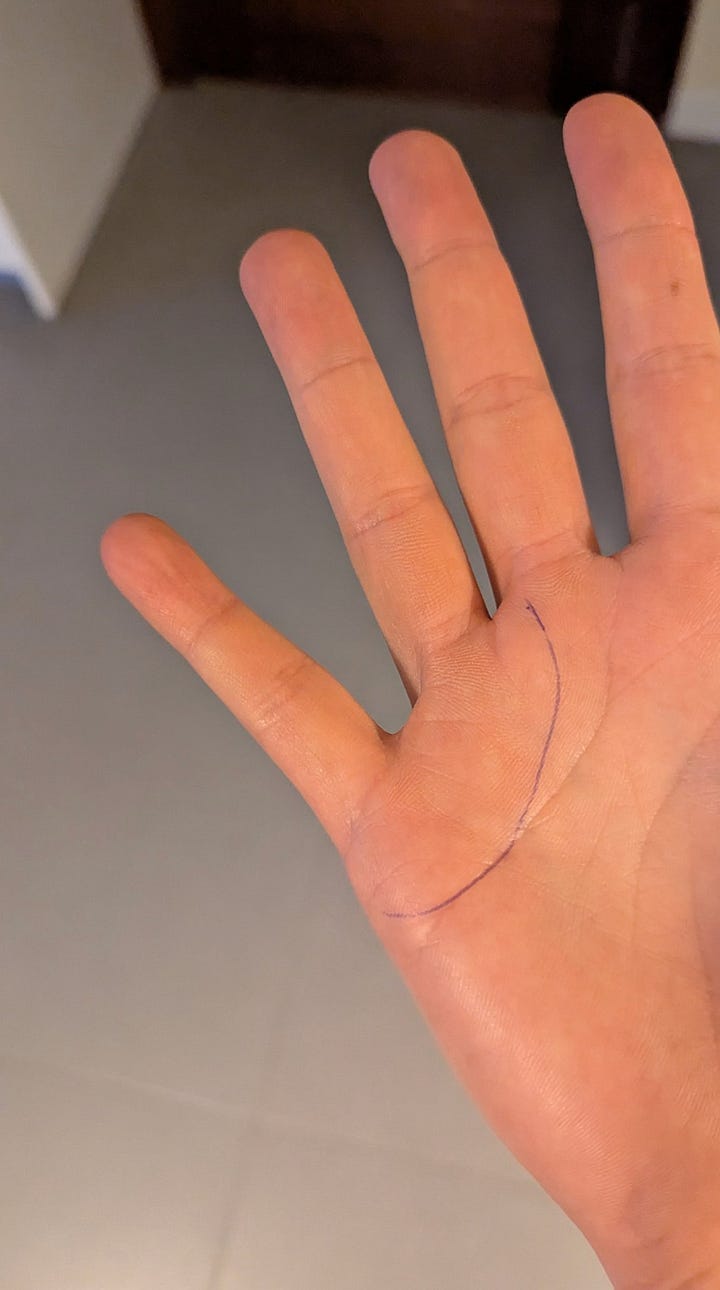

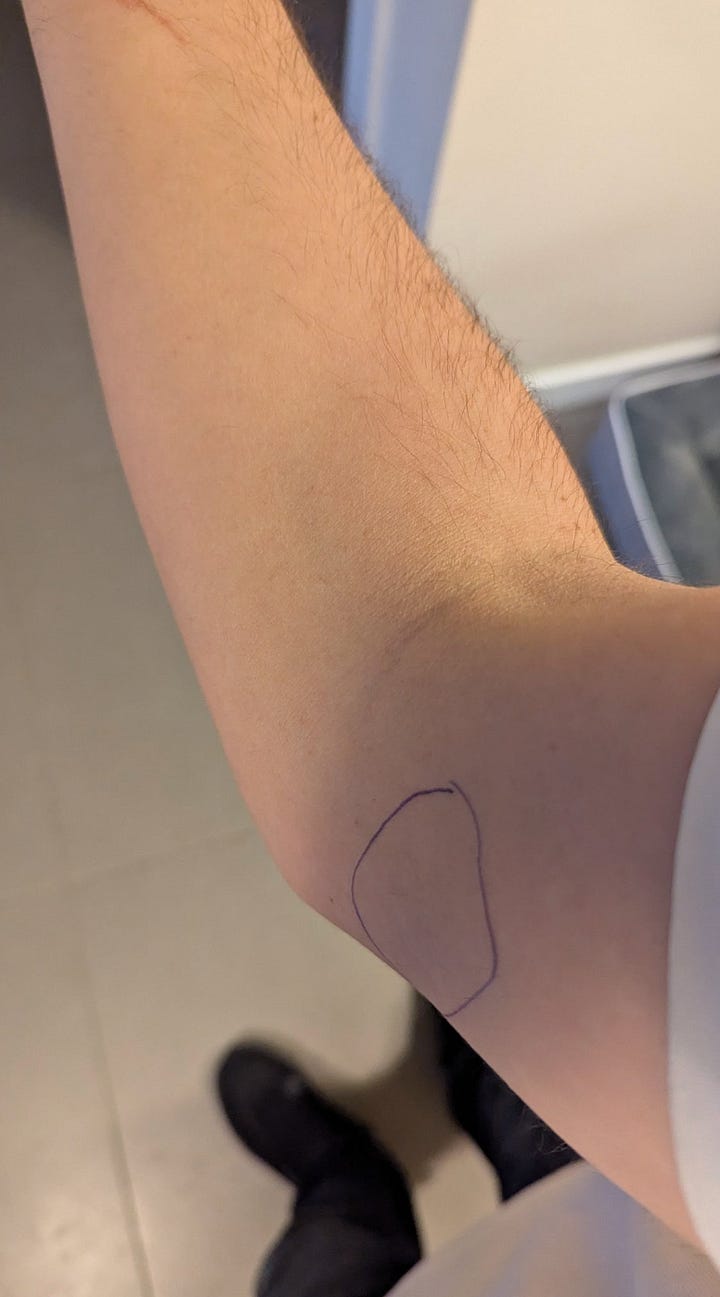

Javi Lopez è il CEO di Magnific AI, startup spagnola del settore dell’IA generativa. Da un anno e mezzo soffre di un dolore al braccio e alla mano destra, ma nessuno dei dottori da lui consultato è stato in grado di individuarne la causa. Non sapendo più come fare, ha segnato con una penna quali zone gli facevano male e ha scattato un paio di foto con il cellulare. A quel punto le ha mostrate a ChatGPT, versione o3, che in pochi secondi ha fornito una possibile diagnosi: tunnel cubitale. Alla domanda di Lopez su come sarebbe stato possibile confermare (o smentire) tale diagnosi, ChatGPT gli ha fornito il nome di un medico della sua città (Murcia) e l’indicazione dell’esame da eseguire (un’elettromiografia).

Quando è arrivato dal medico - pur essendo un imprenditore del settore - Lopez si è vergognato di dirgli che era stato mandato lì da un’IA e quindi si è inventato la storia per cui era stato il suo fisioterapista a dirgli che poteva essere tunnel cubitale e di andare da un dottore. A quel punto, il medico esegue l’esame diagnostico che conferma l’ipotesi (di ChatGPT) e prescrive al paziente soltanto un po’ di riposo.

Dopo la visita, e più di un anno di dolore, Lopez - insoddisfatto della terapia - prova a richiedere una cura a ChatGPT (di cui adesso si fida ancora di più). Il chatbot risponde in modo dettagliato con tanto di farmaci e di link a video che mostrano gli esercizi che deve fare. Anche in questo caso, prima di seguire la terapia, chiede conferma a un medico umano che lo rassicura sulla validità di quanto sostenuto da ChatGPT.

Lopez ha quindi deciso di condividere questa sua esperienza con un post su X, chiosando “What a time to be alive” (trad. “che periodo fantastico quello in cui ci troviamo a vivere”).

IA & salute: le opportunità

A questa entusiastica affermazione di Lopez verrebbe da rispondere, ironicamente ma forse non troppo, con “che periodo incredibile in cui occuparsi di diritto dell’IA!”. Infatti, se da un lato l’intelligenza artificiale offre incredibili opportunità al settore sanitario e - in ultima analisi - promette di migliorare la qualità e la durata delle nostre vite, dall’altro questa vera e propria esplosione dell’uso dell’IA in ambito medico può portare rischi che, se non prevenuti, possono essere molto gravi per i diritti e la salute delle persone.

Partiamo dalle promesse. La convinzione che l’IA rivoluzionerà la cura delle malattie è condivisa dai principali attori del settore:

Demis Hassabis, CEO di Google DeepMind, sostiene che, in un decennio, “potremo curare tutte le malattie grazie all’IA”;

Dario Amodei, CEO di Anthropic, prospetta che l’IA permetterà di “comprimere cent’anni di progressi scientifici in soli cinque o dieci anni”;

Sam Altman, CEO di OpenAI, ha dichiarato che “vedremo le malattie guarire a un ritmo senza precedenti” e prevede che rimarremo sorpresi da quanto rapidamente l’IA aiuterà a sconfiggere persino il cancro.

Del resto, non passa settimana senza la notizia di scoperte che dimostrano come l’IA stia già offrendo strumenti innovativi per diagnosi più precoci, terapie mirate e supporto alle decisioni cliniche. Altri ambiti in rapido sviluppo includono la scoperta di nuovi farmaci (anche grazie a modelli generativi che esplorano milioni di molecole molto velocemente), l’analisi predittiva su grandi dataset sanitari (ad es. per prevedere focolai epidemici o individuare pazienti a rischio di complicanze), il miglioramento delle prestazioni sanitarie e della diagnostica, nonché assistenti virtuali per triage e consulenza medica di base.

Forti di questi annunci e di risultati apparentemente già buoni, professionisti del settore sanitario e semplici pazienti stanno iniziando a utilizzare l’IA con sempre maggiore frequenza.

IA & salute: i rischi

Tuttavia, assieme a queste notevoli opportunità, emergono anche preoccupazioni e interrogativi sul fronte dei diritti, dell’etica e della sicurezza dei pazienti. Anche perché l’IA sbaglia, pure in questo settore.

Qualche settimana fa, ad esempio, ha destato scalpore un rapporto sanitario commissionato negli USA dalla Casa Bianca, il MAHA Report (“Make America Healthy Again”), che avrebbe dovuto analizzare le cause del calo di aspettativa di vita negli Stati Uniti. In una versione iniziale, questo corposo documento (con 522 note bibliografiche) conteneva numerosi riferimenti scientifici errati o inesistenti, con studi medici mai pubblicati citati come fonti autorevoli. Un’indagine del Washington Post ha rivelato che tali errori erano con ogni probabilità dovuti all’uso disinvolto di un chatbot IA per generare le citazioni bibliografiche: tra i link compariva la stringa “oaicite”, segno distintivo dell’uso di ChatGPT. In pratica, il sistema di intelligenza artificiale generativa utilizzato avrebbe “allucinato” studi e riferimenti inesistenti, un fenomeno noto per cui l’IA fornisce risposte apparentemente plausibili ma false quando non trova dati reali adeguati (ne abbiamo parlato più volte, anche con riferimento agli atti giudiziari).

Le reazioni non si sono fatte attendere. Quanto accaduto rappresenta un monito in relazione all’uso di sistemi IA per la redazione di documenti governativi, dal momento che espone i decisori a informazioni scientificamente infondate. Questo caso emblematico evidenzia fin da subito anche il duplice volto dell’IA in ambito sanitario: da un lato strumento potente per analizzare rapidamente la letteratura scientifica o le analisi, dall’altro potenziale fonte di disinformazione o di diagnosi errate se usato senza le dovute cautele.

La lezione è chiara: accuratezza e verifica umana rimangono imprescindibili, specialmente quando sono in gioco politiche sanitarie e la salute dei pazienti. È anche per questo che i principali chatbot di IA - magari per evitare contenziosi e responsabilità - quando gli vengono poste domande in ambito medico mostrano disclaimer molto chiari.

Ecco alcune delle principali criticità giuridiche legate all’uso di sistemi IA in questo settore:

Responsabilità medica e affidamento decisionale: chi risponde di un errore diagnostico o terapeutico commesso da (o con) un’IA? Se un chatbot dovesse suggerire una cura sbagliata causando danni a un paziente, la responsabilità potrebbe ricadere sul medico che ha seguito il consiglio dell’algoritmo, sulla struttura sanitaria che lo ha adottato oppure sul produttore del sistema IA? In concreto, vi è il rischio che l’eccessivo affidamento del medico sull’IA (automation bias) attenui la diligenza nel verificare le indicazioni: tuttavia, dal punto di vista giuridico, l’IA è - al momento - solo uno strumento e difficilmente potrà sollevare il professionista dai suoi doveri di perizia e professionalità. Il tema sarà semmai dimostrare che l’errore del medico è dovuto all’errore (o all’uso scorretto) dell’IA.

Trasparenza e spiegabilità degli algoritmi: molti sistemi di IA, in particolare quelli basati su reti neurali , operano come “scatole nere”, fornendo output (diagnosi, predizioni) senza che sia immediatamente comprensibile il perché di una certa risposta. Ciò pone un problema di opacità: il paziente e il medico hanno diritto di conoscere le ragioni di una scelta clinica, ma di fronte a un algoritmo questo diritto rischia di essere compromesso. La fiducia verso l’IA in sanità potrebbe essere minata se non c’è trasparenza sui suoi meccanismi e sui dati utilizzati. La stessa Organizzazione Mondiale della Sanità ha evidenziato la preoccupazione che la rapida adozione di sistemi IA stia avvenendo senza le dovute garanzie di trasparenza e supervisione: occorre assicurare la verificabilità dei modelli, il coinvolgimento di esperti e una rigorosa validazione prima dell’uso clinico. In risposta a queste sfide, si parla di “IA spiegabile” (explainable AI), ovvero progettare algoritmi che forniscano anche una spiegazione interpretabile del loro funzionamento (ad es. evidenziando le caratteristiche cliniche su cui si sono basati per formulare una certa diagnosi). Inoltre, normative future potrebbero auspicabilmente richiedere una sorta di validazione certificata dei sistemi di intelligenza artificiale medica, sul modello delle approvazioni farmaceutiche, per garantirne sicurezza ed efficacia.

Qualità dei dati e bias algoritmici: un sistema IA è valido solo quanto i dati su cui è addestrato. Nel settore sanitario i dati possono essere incompleti, non rappresentativi o contenere pregiudizi. Ad esempio, se un algoritmo per la diagnosi è addestrato prevalentemente su immagini di pazienti caucasici, potrebbe avere performance peggiori nel riconoscere patologie su pazienti di altre etnie. Questo potrebbe generare bias che rischiano di tradursi in errori diagnostici, con conseguenze gravi per la salute delle persone. L’Organizzazione mondiale della sanità insiste molto su questo punto: è indispensabile garantire la qualità e varietà dei dati per evitare errori sistematici e discriminazioni nei risultati prodotti dai sistemi. Un caso noto, emerso già alcuni anni fa, riguardava un algoritmo usato negli USA per identificare i pazienti a cui offrire programmi di cura delle malattie croniche: a causa di bias nei dati (che utilizzavano la spesa sanitaria come indicatore di bisogno di cure), l’IA sottovalutava la gravità dei pazienti afroamericani, determinando un’ingiustizia razziale. Per prevenire questi rischi, occorrono dataset rappresentativi, tecniche di debiasing, controlli indipendenti e, più in generale, un approccio etico alla progettazione dell’IA.

Sorveglianza algoritmica e privacy dei pazienti: l’IA in sanità promette di estrarre informazioni utili incrociando big data sanitari, ma occorre bilanciare tali benefici con il diritto alla riservatezza e all’autodeterminazione delle persone. L’allargamento delle frontiere dei dati utilizzabili per investigare lo stato di salute, e dei soggetti che vi hanno accesso, solleva timori di sorveglianza digitale sulla vita privata degli individui. Si pensi ad assicurazioni che possono monitorare costantemente lo stile di vita tramite dispositivi indossabili per modulare i premi o a datori di lavoro che analizzano dati sanitari dei dipendenti. Senza adeguate tutele, l’IA potrebbe di fatto creare un panopticon sanitario, dove ogni parametro biometrico o abitudine viene tracciato. Inoltre, l’interconnessione di database sanitari e altri dataset (social network, geolocalizzazione, acquisti) potrebbe facilitare inferenze indebite: ad esempio un algoritmo potrebbe dedurre patologie o gravidanze analizzando i comportamenti di una persona, anche in assenza di dati sanitari espliciti (qualche anno fa, negli USA, è già successo: un algoritmo rivelò al padre di una liceale che la figlia era incinta prima che lo facesse la figlia stessa).

IA & salute: le norme

Di fronte a queste opportunità e rischi, legislatori e autorità regolatorie a vari livelli (globale, europeo, nazionale) stanno provando a definire nuove regole. L’obiettivo è comune: favorire l’innovazione utile, garantendo al contempo sicurezza e tutela della salute delle persone.

Le ricette dei diversi ordinamenti sono abbastanza diverse però.

In Europa, l’AI Act - come noto - definisce categorie di rischio per i sistemi di IA e impone obblighi proporzionati. In ambito sanitario, il Regolamento europeo considera generalmente i sistemi IA destinati a diagnosi, prevenzione, cura o gestione sanitaria come “ad alto rischio”, data la potenziale incidenza su salute e diritti delle persone. Ciò significa che tali applicazioni dovranno rispettare requisiti stringenti prima di poter essere immesse sul mercato europeo. Tra questi requisiti vi sono: l’uso di dati di training di qualità, documentazione tecnica dettagliata, trasparenza sulle funzionalità e gli scopi del sistema, sistemi di gestione del rischio durante tutto il ciclo di vita del sistema, e garanzie di controllo umano appropriato.

Va segnalato che l’AI Act, ovviamente, si interseca con la normativa esistente: in UE infatti già oggi un software che effettua diagnosi è qualificato come dispositivo medico e deve rispettare specifici requisiti di sicurezza. L’AI Act aggiungerà a questo quadro ulteriori specifiche focalizzate sulla componente algoritmica. Ad esempio, un software diagnostico con IA dovrà non solo essere “clinicamente valido”, ma anche rispettare specifici criteri di affidabilità ed essere inserito nell’elenco dei sistemi IA “ad alto rischio” tenuto dalla Commissione Europea.

Diversamente dall’Europa, negli USA manca al momento una legge omnibus sull’IA, ma sono in atto diverse iniziative specifiche. In ambito sanitario, il ruolo principale è giocato dalla FDA (Food and Drug Administration): l’agenzia federale considera molte soluzioni di IA come medical devices e quindi ne richiede l’approvazione prima dell’uso clinico. La FDA ha riconosciuto che il tradizionale iter di autorizzazione dei dispositivi medici va adattato agli algoritmi adattivi che si aggiornano con nuovi dati, e sta elaborando apposite indicazioni. Ad esempio, a gennaio 2025 l’FDA ha pubblicato una bozza di linee guida sul ciclo di vita dei software con IA incorporata, che fornisce raccomandazioni ai produttori su come gestire aggiornamenti continui degli algoritmi e sulle evidenze da presentare per l’approvazione. Inoltre, l’FDA ha emanato linee guida per l’uso dell’IA nel processo di sviluppo dei farmaci, mentre la FTC (Federal Trade Commission) ha avvertito le aziende tech che pubblicizzare software di IA con affermazioni fuorvianti o non supportate da evidenze potrebbe costituire pratica ingannevole perseguibile.

In Italia, invece, negli anni scorsi il Garante Privacy aveva già pubblicato un decalogo di regole e principi per l’utilizzo dell’IA nel servizio sanitario nazionale. Questo decalogo sottolinea alcuni capisaldi: la necessità di basi giuridiche chiare per trattare dati personali con sistemi IA (consenso dell’interessato, oppure altra base come obblighi di cura previsti dalla legge), il rispetto dei principi di privacy by design e by default (cioè tutela dei dati impostata fin dalla progettazione e impostazioni di default rispettose della riservatezza) e la centralità dell’accountability (ossia responsabilizzazione di chi utilizza l’IA, che deve documentare le valutazioni fatte e rispondere degli esiti). Il Garante richiama anche i doveri deontologici degli operatori sanitari: l’IA non li esime dal segreto professionale e dall’aggiornamento continuo, anzi impone una formazione specifica per usarla correttamente.

Più recentemente, il governo ha inserito una previsione dedicata all’ambito sanitario nel DDL sull’IA in corso di esame parlamentare (art. 7). Questi i principali punti della proposta normativa:

l’IA può essere impiegata per prevenzione, diagnosi e cura, ma sempre nel rispetto di diritti, libertà e protezione dei dati personali;

l’introduzione di sistemi IA non deve selezionare o condizionare l’accesso alle prestazioni sanitarie con criteri discriminatori;

ogni persona ha il diritto di sapere quando viene utilizzata tecnologia di IA che la riguarda in ambito sanitario;

l’IA può essere utilizzata nei processi di prevenzione, diagnosi, cura e scelta terapeutica, ma la decisione finale spetta sempre ai professionisti sanitari;

i sistemi IA e i dati utilizzati devono essere affidabili, sottoposti a verifiche e aggiornamenti periodici per ridurre il rischio di errori e garantire la sicurezza dei pazienti.

IA & salute: clausole da leggere, cautele da osservare

Ma cosa succede se è direttamente l’utente a usare l’IA per diagnosi e terapie rapide, magari nell’illusione di fare a meno di un dottore?

Un aspetto particolarmente delicato è la privacy dei dati sanitari nell’era dei chatbot e dei modelli di IA generativa (come ChatGPT, Gemini, Claude o Grok). Cosa accade quando un utente inserisce informazioni sulla propria salute in uno di questi sistemi? Quali garanzie (o rischi) esistono?

Quando un individuo, spontaneamente, scrive su un chatbot i propri sintomi, farmaci assunti, referti o altri dettagli medici, quei dati vengono inoltrati a un sistema gestito da terzi (solitamente aziende con sede fuori dai confini UE) e memorizzati nei loro server. Questo di per sé comporta un rischio: l’utente potrebbe non essere pienamente consapevole che, così facendo, sta di fatto comunicando informazioni mediche riservate (che magari non condivide neanche con i propri amici o familiari) a un’entità che non è il proprio medico né una struttura sanitaria soggetta al segreto professionale. Ad esempio, se qualcuno copia&incolla il risultato di analisi del sangue su ChatGPT chiedendo una spiegazione (o fornisce la foto o il file del referto), sta fornendo quei dati a OpenAI, che li elaborerà e potenzialmente li conserverà per un certo periodo.

La maggior parte dei fornitori di servizi di IA generativa sconsiglia esplicitamente di inserire dati sensibili, proprio perché non possono garantirne la riservatezza assoluta.

Infatti, a seconda del tipo di abbonamento al chatbot (gratuito o enterprise) e delle nostre opzioni di configurazione, i dati inseriti potrebbero essere visualizzati da operatori umani (per migliorare il sistema) o usati per addestrare ulteriormente l’IA. Insomma, non c’è garanzia di confidenzialità paragonabile a quella di una conversazione con il proprio medico. Anzi, gli stessi esperti di sicurezza consigliano di non inserire informazioni identificative o mediche private nei prompt rivolti a ChatGPT o analoghi. Oltre al rischio di accesso umano per fini di moderazione o addestramento, c’è la possibilità – per quanto remota – che tali informazioni possano emergere in risposte fornite ad altri utenti (ad esempio attraverso pattern di completamento se l’IA dovesse memorizzare pezzi di conversazioni precedenti).

Un ulteriore rischio è che questi dati, una volta inviati, escano dalla sfera di controllo dell’interessato. L’utente medio non sa esattamente dove verranno conservati (negli USA? in altri Paesi?) né per quanto tempo. Se dovesse volerli cancellare, dovrebbe esercitare diritti previsti dal GDPR (come l’opposizione o la cancellazione) nei confronti del provider IA, operazione non sempre agevole.

Dal punto di vista dell’utente professionale, il discorso è ancor più stringente: un medico, uno psicologo o un farmacista non dovrebbero mai inserire in un chatbot cloud dati personali di un paziente, a meno che il servizio non offra garanzie contrattuali precise (ad esempio esistono versioni enterprise di certi modelli, in relazione ai quali le aziende garantiscono che i dati non verranno riutilizzati). Immettere dati sanitari su servizi consumer come ChatGPT potrebbe violare il segreto professionale e la normativa in materia di data protection, esponendo il professionista a sanzioni.

Infine, un altro aspetto da considerare è la qualità delle risposte fornite dai chatbot su temi di salute. Come accennato, modelli generativi possono commettere errori o allucinazioni. Per questo, quasi tutte le piattaforme includono disclaimer di non affidabilità clinica. Ad esempio, Microsoft nelle condizioni d’uso di Bing Chat avvisa di non fare affidamento su output generati dall’IA per consigli medici o legali, chiarendo che le risposte non costituiscono parere professionale. Analogamente, altri servizi sottolineano che l’IA non sostituisce il medico: i contenuti forniti sono da intendersi a scopo informativo generale. OpenAI ha inserito nelle sue policy il divieto per ChatGPT di fornire consulenze mediche dettagliate senza disclaimer, e addestra il modello a suggerire di consultare un medico dal vivo in caso di problemi di salute seri. In pratica, se chiediamo a ChatGPT “Ho questi sintomi, cosa dovrei fare?”, con alta probabilità la risposta includerà una frase tipo “Non sono un medico, per una diagnosi accurata consulta uno specialista”. Questa linea cautelativa è importante per evitare che persone fragili prendano decisioni sanitarie basandosi ciecamente su un IA.

Va detto però che non tutti gli utenti leggono o danno peso a questi avvertimenti. Quindi un ulteriore fronte su cui lavorare è la sensibilizzazione degli utenti (l’AI literacy di cui abbiamo parlato in LeggeZero #76): bisogna far comprendere alle persone che, per quanto avanzato e utile, un chatbot non è un dottore. L’OMS stessa ha espresso preoccupazione per il fenomeno dei pazienti che cercano diagnosi tramite IA prima ancora di consultare un medico. Se da un lato ciò può migliorare l’alfabetizzazione sanitaria, dall’altro l’uso dell’IA senza controllo può portare a errori e ad un indebolimento del rapporto di fiducia medico-paziente. Il rapporto di cura tradizionale, infatti, implica responsabilità e empatia che un algoritmo, al momento, non può garantire.

🔊 Un vocale da… Giovanni Stracquadaneo (imprenditore)

Se l’intelligenza artificiale e i dati clinici stanno diventando i nuovi “fattori produttivi” della sanità, chi garantirà che l’innovazione arrivi davvero al paziente prima di diventare già obsoleta?

Nel messaggio vocale di questa settimana Giovanni Stracquadaneo -imprenditore con lunga esperienza in tecnologie digitali in ambito sanitario - racconta come IA, big data e ricerca genetica stiano generando dispositivi e processi diagnostici d’avanguardia. Ma avverte: il vero ostacolo non è più la scienza, bensì la lentezza di leggi, procurement e framework regolatori.

Esempio emblematico, spiega, è il regolamento europeo sullo spazio dei dati sanitari: piena attuazione prevista entro il 2031, un’eternità rispetto al ritmo esponenziale di crescita della tecnologia. Se politici, regolatori e sistemi sanitari non accelerano, il rischio è vanificare scoperte che potrebbero già migliorare, personalizzare le cure e prevenire le malattie.

La sfida cruciale? Il tempo: è urgente fare sistema fra legislatori, ricercatori e industria per creare regole trasparenti, percorsi d’acquisto agili e un ecosistema dove dati sanitari e algoritmi possano davvero trasformare la medicina nel rispetto dei diritti di tutti.

🏛️ Gli eventi di LeggeZero: ‘CAIO Day: come governare l’IA nella pubblica amministrazione’

Immaginate una Pubblica Amministrazione capace di usare l’Intelligenza Artificiale per semplificare la vita delle persone, rendere i servizi più vicini ai cittadini e liberare energie preziose. Non si tratta di un'utopia, ma di una realtà che si costruisce oggi con la formazione e il confronto.

È per questo che insieme abbiamo organizzato i CAIO Days: eventi in presenza in cui fornire strumenti alle pubbliche amministrazioni che vogliono governare l'intelligenza artificiale.

Il prossimo si terrà a📍 a Torino il 26 giugno 2025 (info e iscrizioni qui)

Vi aspettiamo!

😂 IA Meme

Gli effetti dell’IA sulla formazione dei professionisti: i nostri futuri medici stanno usando ChatGPT per i loro studi (e le loro tesi), forse faremmo bene a iniziare a condurre uno stile di vita più sano.

📚 Consigli di lettura: l’IA che riassume libri, contratti… e persino paper medici è (ancora) uno studente da 6-

Un’interessante inchiesta del Washington Post firmata da Geoffrey A. Fowler - intitolata “5 AI bots took our tough reading test. One was smartest — and it wasn’t ChatGPT” - ha messo sotto esame cinque chatbot (ChatGPT-4o, Claude 3, Copilot, Meta AI e Gemini 2) chiedendo loro 115 risposte su quattro tipologie di testo: un romanzo contemporaneo, due contratti, due studi scientifici e alcuni discorsi di Donald Trump.

Il risultato? Nessun modello ha superato la sufficienza: Claude è il vincitore di misura grazie alla costanza e alle poche “allucinazioni” (è il migliore anche nell’analisi di paper scientifici), mentre ChatGPT brilla in narrativa e politica ma inciampa sul diritto, Copilot e Meta AI si fermano a metà classifica, e Gemini è il più “distratto”. Gli errori ricorrenti? Sintesi che omettono dettagli cruciali o trasformano passaggi complessi in slogan.

Nei testi letterari i chatbot ignorano temi cruciali, nei contratti saltano clausole rilevanti, nei paper clinici trascurano limiti metodologici. Insomma, al momento nessuna IA può sostituire un professionista specializzato: insegnanti, avvocati e medici possono - per ora - tirare un sospiro di sollievo.

Questo articolo è interessante non solo per chi crede di poter fare a meno di queste figure, ma per gli stessi professionisti che oggi, in alcuni casi, si fidano troppo ciecamente degli strumenti di IA generativa.

Fowler consiglia di far analizzare lo stesso documento da almeno due chatbot diversi e, comunque, di verificare di persona prima di prendere decisioni importanti.

Un promemoria utilissimo per chi usa i chatbot a scuola, in ufficio o in corsia: l’IA può essere una validissima compagna di lettura, ma ha ancora bisogno di ripetizioni.

🏛️ I corsi di LeggeZero: ‘RTD Academy 2025: come governare l’IA nella pubblica amministrazione’

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, sostienici: metti like, commenta o fai girare!