🤖 Fuori controllo – Legge Zero #29

I grandi della Terra si sono riuniti in Italia per parlare di intelligenza artificiale ma non sembrano aver chiaro come fronteggiarne i rischi e garantire un effettivo 'controllo umano' sull'IA.

🧠 Chi controlla il controllore?

Di fronte ai prodigi delle macchine, che sembrano saper scegliere in maniera indipendente, dobbiamo aver ben chiaro che all’essere umano deve sempre rimanere la decisione, anche con i toni drammatici e urgenti con cui a volte questa si presenta nella nostra vita. Condanneremmo l’umanità a un futuro senza speranza, se sottraessimo alle persone la capacità di decidere su loro stesse e sulla loro vita condannandole a dipendere dalle scelte delle macchine. Abbiamo bisogno di garantire e tutelare uno spazio di controllo significativo dell’essere umano sul processo di scelta dei programmi di intelligenza artificiale: ne va della stessa dignità umana.

Sono alcune delle parole del lungo discorso sull’IA che Papa Francesco ha tenuto all’incontro del G7 che si è tenuto in Puglia nei giorni scorsi (la versione integrale la trovate qui). Il messaggio è stato chiaro: bisogna rifuggire ogni determinismo tecnologico e rivendicare la centralità dell’essere umano e del suo controllo nella progettazione e nell’uso dei sistemi di intelligenza artificiale.

Meno chiaro, anzi deludente, il documento finale del Summit. Nelle poco più di due pagine dedicate all’IA si trovano solo generiche petizioni di principio legate alla volontà di collaborare per un’intelligenza artificiale sicura e affidabile, proseguendo l’impegno comune in diversi settori, dalla governance alla definizione di standard per il settore pubblico (per esempio nel settore della giustizia). In proposito, infatti il documento sottolinea che l'uso dei sistemi IA non deve interferire con il potere decisionale dei giudici né con l'indipendenza giudiziaria. Sul come affrontare questi problemi, però, il documento non contiene risposte (potete scaricarlo qui sotto).

Insomma, la sensazione è che - nonostante siano d’accordo sull’urgenza delle questioni poste dall’IA - i decisori facciano molta fatica a stare al passo dell’evoluzione delle tecnologie e a trovare soluzioni ai problemi posti da questa. E non mancano esempi lampanti della difficoltà di governare l’IA a fronte di una sua sempre più capillare diffusione nelle nostre vite.

Ad esempio, nei giorni scorsi, prima di aver finalizzato la sua legge sull’IA, il Brasile ha ufficializzato un accordo con OpenAI per introdurre tecnologie di IA a supporto della locale Avvocatura dello Stato nella gestione del contenzioso (per aumentare l’efficienza degli uffici e ridurre i costi associati alle liti). Nelle dichiarazioni ufficiali, si precisa che la tecnologia non sostituirà i lavoratori (‘li supporterà’), e che tutte le attività saranno supervisionate da esseri umani. Del resto, quello della ‘sorveglianza umana’ è anche uno dei principi cardine dell’AI Act, concepito come metodo per prevenire o ridurre al minimo i rischi per le libertà e i diritti delle persone.

Il controllo umano è un concetto rassicurante, ma forse non realmente efficace. Secondo questo articolo pubblicato su una rivista del MIT, l'aumento del ruolo dell'intelligenza artificiale nei sistemi automatizzati e nei processi decisionali riduce il senso di responsabilità degli utenti. Insomma, più l’IA diventa complessa, più ci fidiamo, più si riduce il nostro senso di responsabilità e meno controlliamo. Lo dimostrano alcune ricerche condotte in campi differenti: dalla guida autonoma all’amministrazione della giustizia.

Quello del controllo umano rischia quindi di diventare un rimedio fittizio, se non si avvia la formazione dei controllori su caratteristiche e limiti dei sistemi di IA, stimolando il loro senso critico e una nuova cultura della responsabilità.

È questa la strada da intraprendere - in tutte le scuole, le amministrazioni, le aziende - per evitare di condannare l’umanità a un futuro senza controllo e ‘senza speranza’ (cit. Papa Francesco). In attesa del prossimo Summit.

🔊 Un vocale da… Donata Columbro: Meta ci ha ripensato. Nei giorni scorsi il Garante Privacy irlandese ha comunicato che la società ha deciso di sospendere il progetto di addestramento della sua IA con i dati degli utenti di Facebook e Instagram (ne avevamo parlato in LeggeZero #27 e LeggeZero #28). Ma, se capiterà di nuovo, cosa dobbiamo chiederci prima di accettare o opporci all’addestramento di un’IA con i nostri dati? Nel vocale di questa settimana, l’autrice di ‘ Quando i dati discriminano’ ce lo spiega, parlandoci del viaggio del dato.

📰 In USA 🇺🇸 e UK 🇬🇧 arrivano i candidati ‘controllati dall’IA’

Nel precedente numero di LeggeZero abbiamo riportato la notizia della prima IA candidata a Sindaco nello Stato USA del Wyoming.

Questa settimana, invece, parliamo di due candidati in carne e ossa che hanno deciso di dare voce ai contenuti generati dall’IA.

Negli USA, Donald Trump - candidato alle elezioni presidenziali - nel corso di un’intervista, ha ammesso di aver già utilizzato un discorso ‘riscritto’ da un’IA e di ritenere che in futuro potrà fare a meno di chi gli scrive gli interventi (a partire dal minuto 50’).

Ancora più distopico quanto sta accadendo in UK dove un candidato, Steve Endacott, ha creato il suo gemello digitale, AI Steve. Il programma elettorale è stato scritto dall’IA, il dialogo con gli elettori è completamente affidato a un chatbot (che può gestire fino a 10mila conversazioni simultanee) e - in caso di elezione - le decisioni sulle votazioni saranno prese dall’IA. Endacott, che è convinto che questa possa essere una soluzione ai problemi della democrazia, si è impegnato a non essere autonomo nelle decisioni che assumerà se sarà eletto. Eseguirà quanto gli dirà il suo gemello digitale sulla base delle conversazioni con i cittadini. Insomma, passeremo dalla ‘democrazia diretta’ alla democrazia manipolata da - o attraverso - l’IA?

📰 In Kenya 🇰🇪 protestano i lavoratori del settore IA

In Kenya, un gruppo di lavoratori tech - che operano per conto di ScaleAI, Meta e OpenAI - ha inviato una lettera aperta al Presidente Biden, chiedendo un intervento contro le pratiche di sfruttamento di cui sono vittime (la lettera completa è disponibile qui).

Questi lavoratori, impiegati nell’addestramento dei sistemi di intelligenza artificiale, denunciano condizioni di lavoro precarie, stipendi inadeguati (meno di 2 dollari l’ora), scarsa attenzione per la loro salute mentale.

Invece che preoccuparci del lavoro che (forse) perderemo, dovremmo occuparci di più della dignità del lavoro di tutti coloro che stanno dietro ai mirabolanti progressi della tecnologia.

⚖️ Dal Garante Privacy francese (CNIL) 🇫🇷 arrivano le raccomandazioni per assicurare la conformità dei sistemi di IA al GDPR

La CNIL, l’Autorità francese per la protezione dei dati, ha pubblicato due importanti documenti in cui chiarisce i suoi orientamenti per assicurare la conformità dei sistemi di IA alla normativa europea in materia di protezione dei dati personali.

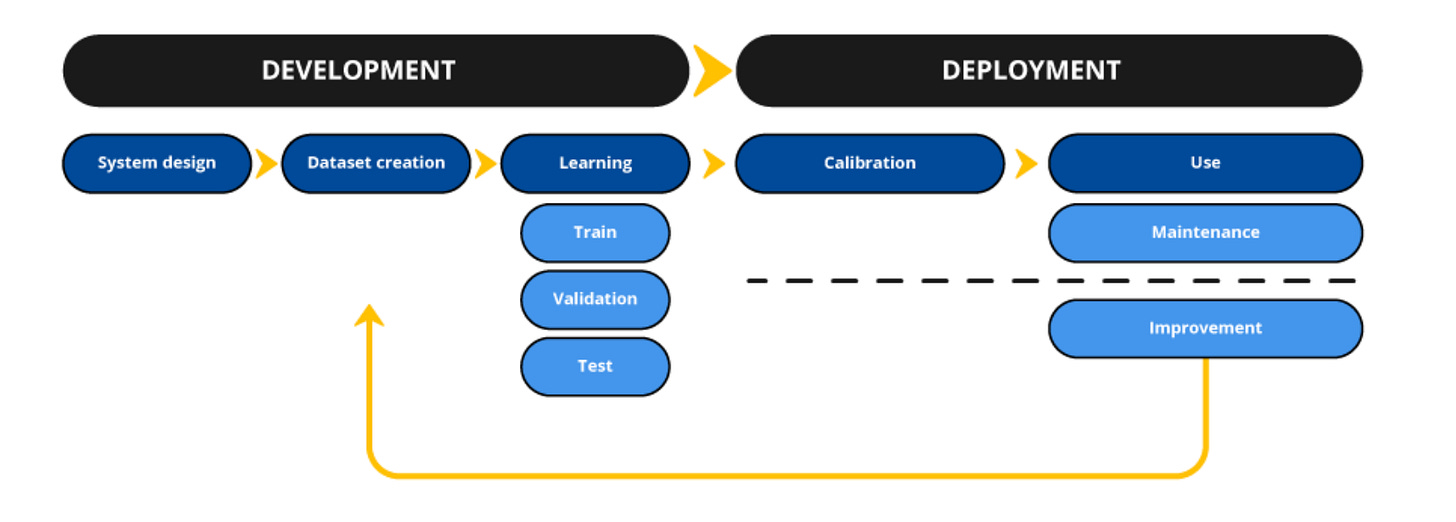

Nel primo documento, la CNIL definisce i sette passaggi che raccomanda di seguire nel ciclo di vita di un sistema di IA:

Step 1: Definire lo scopo del sistema di IA

Step 2: Determinare le responsabilità

Step 3: Definire la "base giuridica" che consente di trattare i dati personali

Step 4: Verificare se è possibile utilizzare i dati personali

Step 5: Minimizzare i dati personali utilizzati

Step 6: Stabilire un periodo di conservazione

Step 7: Effettuare una Valutazione d'Impatto sulla Protezione dei Dati (DPIA)

Il secondo documento, invece contiene le linee guida per determinare le basi giuridiche per il trattamento dei dati nell'addestramento di modelli di IA. Si tratta di uno dei temi più ‘caldi’ sul fronte del diritto dell’IA, come abbiamo scritto in LeggeZero #26: anche il Garante francese sembra aprire alla possibilità di ricorrere al legittimo interesse (tesi caldeggiata dai provider di IA).

⚖️ Per il Tribunale di Tokyo 🇯🇵 un'IA non può essere riconosciuta come ‘inventore’.

Il Tribunale Distrettuale di Tokyo ha emesso un’importante decisione sulla possibilità di riconoscere i sistemi di IA come inventori, ai sensi della Legge sui Brevetti giapponese (cd. Japan Patent Act, n. 121 del 1959).

La Corte ha deciso che, in base alla normativa attuale, solo le persone fisiche possono rivendicare la paternità di un'invenzione, escludendo così le IA da tale riconoscimento. Questo verdetto si allinea con il più ampio orientamento internazionale: numerose giurisdizioni hanno, infatti, adottato posizioni analoghe, consolidando l'idea che, nonostante il rapido avanzamento delle tecnologie generative, l'ingegno umano - per ora - rimane insostituibile nel contesto delle leggi sul diritto d’autore e dei brevetti (ne abbiamo scritto nel nostro Report sulle sentenze e decisioni del 2023 in materia di IA).

😂 IA Meme

Apple ha finalmente presentato ‘Apple Intelligence’, la sua IA. Tra le novità che arriveranno nei prossimi mesi, anche l’integrazione con ChatGPT. Elon Musk non l’ha presa benissimo, paventando rischi per la privacy degli utenti, annunciando che vieterà ai propri dipendenti di usare dispositivi Apple e diffondendo il meme che potete vedere qui sotto.

Eppure, stando a quello che ha dichiarato Apple:

Saranno gli utenti, di volta in volta, a decidere se interrogare ChatGPT. In questo caso, i loro indirizzi IP saranno oscurati, e OpenAI non conserverà le richieste.

📚 Consigli di lettura: “Human vulnerability in the EU Artificial Intelligence Act” di Gianclaudio Malgieri

La legge dell'Unione Europea sull'intelligenza artificiale (AI Act) - che sarà pubblicata nelle prossime settimane sulla Gazzetta Ufficiale dell’Unione - rappresenta un'importante tappa normativa per la regolamentazione dell'IA, ponendo una particolare attenzione alla vulnerabilità umana e sui rischi associati.

Nell'articolo ‘Human vulnerability in the EU Artificial Intelligence Act’ pubblicato sul blog di Oxford University Press, il prof. Gianclaudio Malgieri esamina come il nuovo regolamento affronti le problematiche legate alla vulnerabilità umana, evidenziando i punti critici e le potenziali lacune.

Spoiler: sebbene il regolamento sia un passo avanti significativo, permangono preoccupazioni riguardo alla sua capacità di proteggere efficacemente gli individui più vulnerabili.

📚 Consigli di visione : “Humanity’s Hegelian Golden Braid” di Reid Hoffman

I dibattiti sulla tecnologia sono sempre più ridotti a nette dicotomie. L’intelligenza artificiale dovrebbe essere limitata o accelerata: tesi e antitesi, ma nessuna sintesi. Piuttosto che scegliere da che parte stare, dovremmo prendere in considerazione slogan alternativi che pongano l’attenzione dove è giusto che sia: sull’umanità.

Comincia così il discorso che Reid Hoffman - uno dei pionieri dell’IA e co-fondatore di LinkedIn - ha pronunciato in occasione della cerimonia con cui l’Università di Perugia gli ha conferito il dottorato di ricerca honoris causa in Scienze umane.

Hoffman usa sei massime celebri (da Annibale a Antoine de Saint-Exupéry) per farci riflettere e superare le semplificazioni del dibattito sull’IA, insistendo sulla necessità di vedere l'IA non come un sostituto, ma come un ampliamento delle nostre capacità.

Potete leggere il discorso qui oppure potete ascoltarlo pronunciato - in italiano - da Reid AI, il suo gemello digitale. Ne vale la pena.

📣 Eventi

Privacy Tour 2024: la protezione dei dati personali nell’era dell’IA generativa - Napoli, 18.06.2024

Salesforce World Tour - Milano, 18.06.2024

StartupItalia Opensummit Summer - Roma, 20.06.2024

Tech Tour 2024 - Firenze, 21.06.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.

Pensare di controllare l'AI tramite le leggi (umane) è come pensare di controllare il vento con le mani ...