🤖 Diario di bordo – Legge Zero #51

Per celebrare il primo compleanno di LeggeZero - in una settimana piena di annunci e notizie importanti - abbiamo pubblicato un ebook con tutti i principali contributi degli ultimi dodici mesi.

🧠 Ogni maledetta domenica

È trascorsa un’altra settimana nel mondo (dell’intelligenza artificiale), a quasi due anni dal 30 novembre 2022, data storica del lancio di ChatGPT che ha segnato il momento in cui tutti hanno scoperto l’intelligenza artificiale, in particolar modo quella generativa.

È trascorsa un’altra settimana ordinaria, piena di annunci, indiscrezioni su nuove funzionalità dei sistemi di IA che usiamo quotidianamente e di notizie che evidenziano i rischi e le opportunità di queste nuove tecnologie in tutti i campi del vivere sociale. Nel settore medico, ad esempio, un recente studio ha dimostrato che ChatGPT-4 supera i medici nella capacità diagnostica, raggiungendo una precisione del 90% contro il 76% dei medici che lo usano come supporto e il 74% di quelli che non lo usano affatto. Si tratta di dati tutt’altro che critici: questi numeri dimostrano che l’IA può diventare uno strumento utilissimo nelle mani di professionisti adeguatamente formati (qui un commento sul sito del New York Times). Nella stessa settimana, uno dei più importanti siti d’informazione tecnologica USA, TechCrunch, ha pubblicato un articolo per invitare gli utenti a non condividere le proprie radiografie e referti con sistemi di IA. Nei giorni scorsi, infatti, Elon Musk aveva invitato gli utenti di X a usare il suo chatbot (Grok) con dati sanitari, in modo da addestrarlo più velocemente. Efficace la chiosa dell’articolo:

È bene ricordare che ciò che finisce su Internet non va più via da Internet.

Quando nel novembre 2023 abbiamo iniziato le pubblicazioni di Legge Zero, eravamo mossi più dall'urgenza di raccontare proprio questa rivoluzione in corso che da un progetto editoriale già definito nei minimi dettagli. L'intelligenza artificiale stava entrando prepotentemente nelle nostre vite – dalle aule dei tribunali alle scuole, dagli uffici pubblici agli studi professionali – e sentivamo il bisogno di creare uno spazio in cui analizzare, settimana dopo settimana, come le regole e il diritto stavano provando a tenere il passo di questa trasformazione tecnologica senza precedenti.

Da allora - da LeggeZero #0 - è già passato un anno. Un anno in cui, con curiosità e passione, abbiamo seguito l'evoluzione delle norme sull'IA in tutto il mondo: dall'approvazione dell'AI Act europeo alle leggi della California passando per il progetto del governo italiano, dalle prime sentenze che hanno dovuto fare i conti con ChatGPT fino alle policies aziendali sull'uso dell'intelligenza artificiale. Settimana dopo settimana, abbiamo raccontato come l'IA sta cambiando il modo in cui lavoriamo, studiamo, ci informiamo, ci divertiamo. Ma soprattutto abbiamo provato a capire quali regole siano necessarie per questa tecnologia, nel tentativo di assicurare la tutela dei diritti degli esseri umani e, al tempo stesso, un ambiente propizio per crescita economica e innovazione.

Lo abbiamo fatto – da avvocati – cercando di evitare sia l'entusiasmo critico dei tecno-ottimisti sia il catastrofismo dei tecno-pessimisti. Abbiamo provato a mantenere uno sguardo equilibrato, consapevoli che l'IA porta con sé opportunità straordinarie ma anche rischi che non possiamo permetterci di ignorare. Non è stato sempre facile, ma ci ha aiutato il confronto costante con i lettori che, numero dopo numero, ci hanno aiutato a migliorare con le loro reazioni e i loro suggerimenti. Per ripercorrere quanto accaduto nel corso di questo intensissimo anno, ordinario e straordinario allo stesso tempo, abbiamo raccolto tutti gli editoriali di LeggeZero in un ebook che potete scaricare qui.

Ciò che emerge rileggendo tutto d’un fiato è che a legislatori e giuristi è richiesto un approccio tanto innovativo e veloce quanto la tecnologia che si vuole regolare. Quella della velocità è una partita molto difficile: gli investimenti degli ultimi anni consentono agli operatori - specialmente statunitensi - di annunciare continue evoluzioni dei loro sistemi e di prevedere addirittura che la svolta dell’intelligenza artificiale generale (AGI) arriverà in uno o due anni al massimo.

Si tratta di un tempo assai breve, se solo teniamo conto che - se queste tempistiche saranno rispettate - la AGI arriverà prima che diventi pienamente applicabile l’AI Act, il Regolamento europeo sull’intelligenza artificiale il cui iter di adozione è iniziato nell’aprile del 2021. Del resto, il fatto che i tempi dei regolatori siano (troppo?) lenti è dimostrato dal fatto che - nonostante l’AI Act sia vigente già da agosto 2024, circa 20 Stati Membri su 27 non hanno ancora designato le autorità nazionali che saranno competenti per l’attuazione delle regole europee (qui un prospetto completo).

Questa relazione complicata tra innovazione e regole è dimostrata dalla pubblicazione - avvenuta sempre in questa ordinaria settimana - del rapporto Global Vibrancy Tool 2024 dell’HAI Institute dell’Università di Stanford.

I dati del rapporto sono scontati, ma fanno riflettere: nessun Paese UE tra i primi cinque più all’avanguardia nel settore dell’IA, l’Italia - nonostante le strategie e il G7 - è 22sima su 36 Paesi (trovate qui tutti i numeri).

Dopo la pubblicazione di questo report preparatevi a un riaccendersi del dibattito su ‘le regole UE sono un ostacolo alla competitività delle imprese europee?’

Noi continueremo a darvene conto, domenica dopo domenica. Nel frattempo, grazie per continuare a seguirci - sempre più numerosi - e a scriverci per darci i vostri feedback e riflessioni!

🔊 Un vocale da… Giorgio Tugnoli (Maggioli)

La nostra newsletter compie un anno, oltre 50 numeri ricchi di spunti, segnalazioni, meme e… vocali. Questa settimana pubblichiamo il messaggio del Direttore di Maggioli Editore che racconta ‘perché’ è nato il progetto LeggeZero. Non si tratta di un atto autocelebrativo, ma di un modo di spiegare il nostro approccio a quello che sta accadendo nel mondo (dell’IA), presentandoci ai tanti nuovi iscritti che sono arrivati nelle ultime settimane.

📰 Welfare e IA negli USA 🇺🇸: un nuovo rapporto denuncia discriminazioni sistematiche e mancanza di trasparenza

L’organizzazione non governativa USA TechTonic Justice ha pubblicato un interessante rapporto intitolato ‘Inescapable AI’ (letteralmente ‘IA inevitabile’), 198 pagine che offrono un'analisi approfondita sull'uso dell'intelligenza artificiale nei programmi di welfare statunitensi, mettendo in luce i gravi danni che sta già causando. Lo studio stima che circa 92 milioni di persone siano già esposte all'IA in ambiti essenziali della vita quotidiana, tra cui accesso ai benefici pubblici come alloggio, lavoro, educazione e assistenza sanitaria.

Criticità principali rilevate

Errori: Sistemi automatizzati, utilizzati per determinare l'idoneità dei cittadini all’ottenimento dei benefici, spesso basano le loro decisioni su dati obsoleti o inesatti. Questi errori hanno causato la perdita di assistenza per milioni di persone, in molti casi anche per l’assenza di una verifica umana preventiva.

Disparità nell'accesso ai servizi: i sistemi di IA spesso penalizzano coloro che appartengono a minoranze, discriminandoli nella selezione per l’accesso ai programmi governativi.

Mancanza di trasparenza: molti sistemi IA sono "scatole nere", rendendo difficile contestare decisioni errate. Le notifiche di diniego spesso mancano di spiegazioni chiare o arrivano troppo tardi.

Alcuni numeri

73 milioni di persone rischiano di perdere la copertura sanitaria per errori di questi sistemi.

32,4 milioni di lavoratori a basso reddito sono già soggetti a decisioni prese da IA.

Raccomandazioni

Il rapporto invita le istituzioni federali a regolare l'uso dell'IA attraverso normative che garantiscano trasparenza e accountability (secondo il modello europeo), sottolineando che - nel prossimo futuro - sarà sempre più cruciale il ruolo di chi supporta legalmente i soggetti emarginati contro le decisioni errate dell’IA.

‘Inescapable AI’ contiene un monito: senza un intervento legislativo e sociale deciso, l'uso non regolamentato dell'IA rischia di amplificare le disuguaglianze esistenti, trasformando strumenti di efficienza amministrativa in ‘armi di oppressione burocratica’. Eppure, la recente vittoria di Trump (e di Musk) sembra fare strada a un ancora maggiore utilizzo di sistemi IA, sempre meno sorvegliati (in nome della semplificazione e della spending review).

Potete leggere il report (in inglese) scaricandolo qui.

📰 Consentireste di addestrare l’IA sul vostro libro per 2.500 dollari?

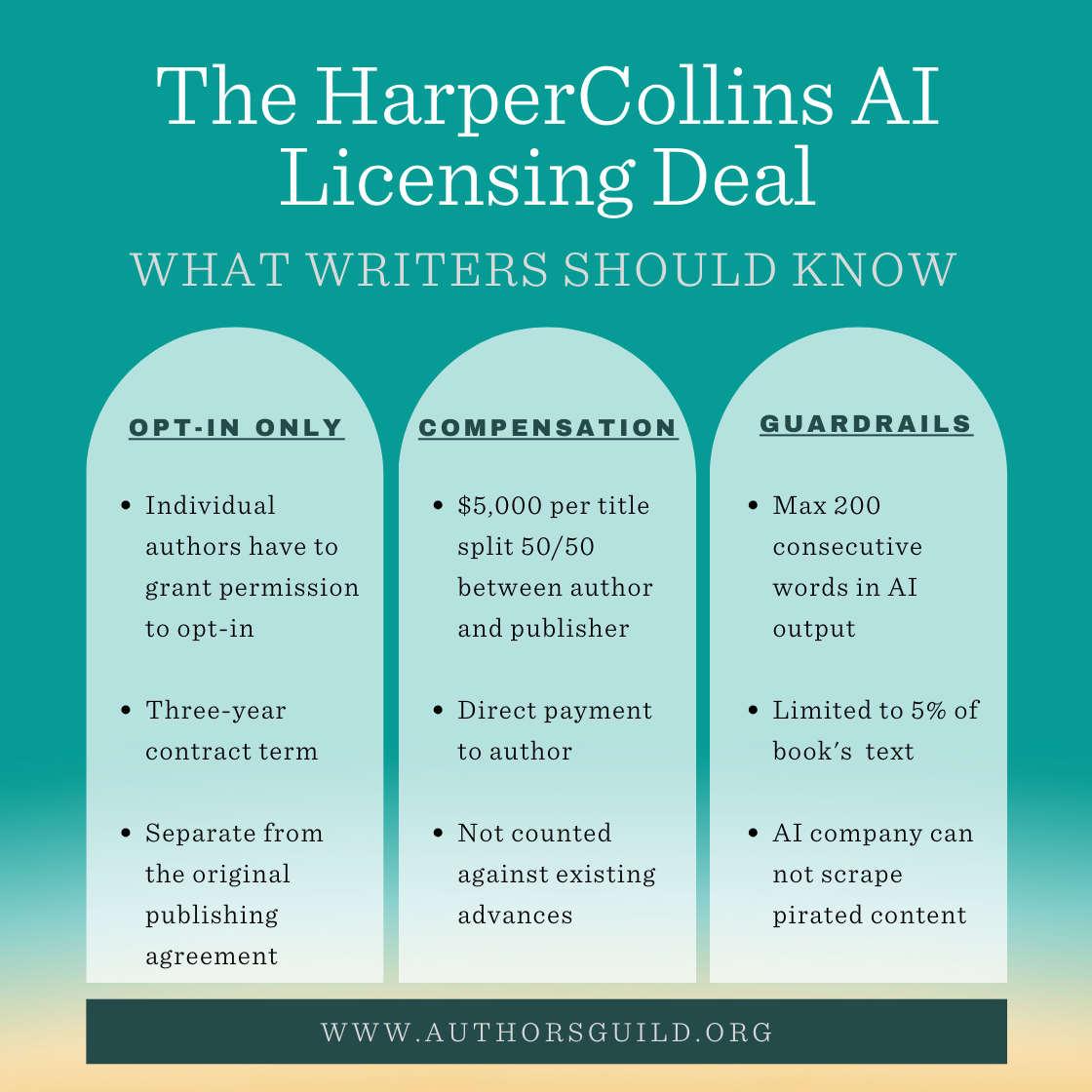

HarperCollins ha stretto un accordo con provider di IA (non meglio precisato) per permettere l’utilizzo di alcuni titoli di saggistica per l’addestramento di modelli di intelligenza artificiale, previa autorizzazione degli autori. Questo accordo prevede un compenso di 5.000 dollari per titolo, da dividere equamente tra l'autore e l'editore, con l'autore che riceve 2.500 dollari.

L'Authors Guild - la più antica e grande organizzazione professionale USA che rappresenta gli autori - ha accolto con favore il principio del consenso esplicito degli autori (non applicato spesso nemmeno da quegli editori che pure hanno raggiunto accordi simili con i provider di IA). L’associazione ha però criticato la divisione 50-50 dei compensi tra autori ed editori, ritenendola inadeguata, dato che i diritti delle opere appartengono principalmente agli scrittori. L'organizzazione, ovviamente, ha anche sottolineato l'importanza di affermare la prassi di un uso dei libri sulla base di una licenza, abbandonando il web scraping selvaggio e, quindi, lo sfruttamento indiscriminato delle opere.

Secondo quanto riportato dal Guardian, centinaia di autori avrebbero già accettato la proposta di concedere una licenza triennale per l’addestramento dell’IA con alcuni limiti (ad. esempio relativi al numero di parole consecutive che possono essere riprodotte nella risposta del chatbot). Non mancano i critici, come Daniel Kibblesmith - autore del libro per ragazzi ‘Il marito di Babbo Natale’ - che ha reso nota la sua decisione di non aderire all’accordo (con un post su Bluesky).

⚖️ Pubblicata la nuova direttiva UE 🇪🇺 sulla responsabilità per danno da prodotti difettosi (che si applica anche all’IA)

Nei giorni scorsi (il 18 novembre) è stata pubblicata sulla Gazzetta Ufficiale dell’Unione Europea la Direttiva (UE) 2024/2853 in materia di responsabilità per i danni causati da prodotti difettosi.

Perché è importante?

L’obiettivo della Direttiva è modernizzare e armonizzare le norme applicabili nell’UE, tenendo conto delle evoluzioni tecnologiche, inclusa l'intelligenza artificiale, e dei nuovi modelli di business, al fine di garantire un elevato livello di protezione dei consumatori e delle altre persone fisiche.

Punti chiave della Direttiva

Estensione del concetto di ‘prodotto’: include tutti i beni mobili, compresi i software, anche quando integrati in altri beni mobili o installati in beni immobili.

Ampliamento della responsabilità: tutti gli operatori economici nella catena di produzione possono essere ritenuti responsabili per i danni causati da prodotti difettosi, non limitandosi quindi solo al produttore.

Riconoscimento dei danni ai dati: la distruzione o corruzione dei dati è ora considerata un danno risarcibile, estendendo la responsabilità oltre i danni fisici.

Presunzione di difettosità e onere della prova: una delle norme più importanti è l’art. 10 della Direttiva. In determinate condizioni, come la mancata conformità del prodotto ai requisiti di sicurezza obbligatori (es. AI Act), si presume la difettosità del prodotto e il nesso causale con il danno subito, facilitando l'onere della prova per il danneggiato.

Gli Stati membri dell'UE hanno tempo fino al 9 dicembre 2026 per recepire questa direttiva nelle rispettive legislazioni nazionali. Le nuove disposizioni si applicheranno ai prodotti immessi sul mercato o messi in servizio dopo tale data.

Qui sotto potete scaricare il testo della Direttiva (in italiano).

PS C’è chi sostiene che si tratti di regole troppo gravose per le imprese (qui un approfondito post di

). Tenete conto che nei prossimi mesi l’UE dovrebbe adottare un’altra Direttiva specifica sulla responsabilità per i danni dell’IA su cui si sta ancora lavorando (ne abbiamo parlato in LeggeZero #45)⚖️ Gema Vs. OpenAI: in Germania 🇩🇪 la prima causa in Europa in materia di diritto d’autore sulle opere musicali

Se da un lato i Beatles, grazie all’AI, tornano a concorrere per il Grammy 2025 (se non lo sapevi, trovi tutto in LeggeZero #50), le collecting europee iniziano ad attivarsi per riscuotere i diritti per l’uso delle opere musicali tutelate nell’ambito dell’addestramento dei sistemi di IA.

Nei giorni scorsi, la società tedesca per i diritti musicali GEMA ha intentato una causa contro OpenAI, presso il tribunale regionale di Monaco di Baviera chiedendo che il Tribunale chiarisca ‘gli obblighi di remunerazione dei fornitori di IA in Europa’ rispetto agli editori ed autori musicali che la stessa rappresenta.

L'oggetto della causa è la riproduzione non autorizzata dei testi delle canzoni da parte di ChatGPT che, a fronte di semplici prompt, riproduce i testi delle canzoni originali degli artisti rappresentati da GEMA, con cui il sistema è stato addestrato. La collecting sostiene che OpenAI faccia sistematicamente uso dei contenuti protetti, violando deliberatamente i diritti d'autore. ‘Le canzoni dei nostri membri non sono materia prima gratuita per i modelli di business dei fornitori di sistemi di intelligenza artificiale generativa’, ha dichiarato Tobias Holzmüller CEO di GEMA. ‘Chiunque voglia utilizzare queste canzoni deve acquisire una licenza e remunerare gli autori in modo equo’.

Mentre negli Stati Uniti il contenzioso in materia di IA e diritti musicali ha raggiunto numeri a due cifre (ne abbiamo parlato in LeggeZero #32), senza aver ancora prodotto un risultato definitivo, in Europa si tratta di uno dei primi casi di azione giudiziaria in questo settore.

In attesa della sentenza (che non arriverà a breve), qui trovate la pagina del sito di GEMA contenente un dossier sul contenzioso (ci sono anche alcune utili FAQ).

💊 IA in pillole

OpenAI ha cancellato - accidentalmente - alcune prove raccolte nell’ambito dell’istruttoria della causa promossa dal New York Times sull’addestramento di ChatGPT (ne abbiamo parlato in LeggeZero #6). E no, non c’era un backup.

Il Senato del Michigan (USA) ha vietato a senatori, dipendenti e stagisti di utilizzare sistemi di IA generativa (inclusi ChatGPT, Gemini, Claude e Perplexity). La decisione è motivata da preoccupazioni legate alla sicurezza e alla privacy, soprattutto riguardo alla potenziale condivisione di informazioni sui cittadini o bozze di atti non ancora pubbliche.

Alexander Klöpping, un giornalista olandese, nel corso di un servizio trasmesso in TV ha mostrato quanto sia semplice (e inquietante) la tecnologia di riconoscimento facciale, specialmente se combinata con smart glasses. Sono bastati pochi secondi di video durante una conversazione sull'uso dei trasporti pubblici per identificare nome, datore di lavoro e altri dettagli personali dell'interlocutore. Da mostrare a chi crede che non ci siano rischi per la privacy.

L’arrivo dello spot natalizio di Coca Cola sancisce l’inizio della stagione delle feste. Segno dei tempi: per la prima volta, lo spot è stato realizzato con l’IA consentendo di risparmiare tempo e risorse. Le reazioni non sono state entusiastiche però.

😂 IA meme

Dopo la pubblicazione della nuova Direttiva UE sulla responsabilità per i prodotti difettosi, l’IA rischia di diventare un facile capro espiatorio?

😂 IA meme… che non lo erano

Parliamo sempre più con chatbot IA, condividendo dati e informazioni su di noi, sul nostro lavoro, sulle nostre vite. Ma quanto siamo consapevoli del fatto che gli strumenti che utilizziamo quotidianamente ricordano quanto diciamo loro? Nei giorni scorsi, ad esempio, Google ha introdotto una funzionalità di Gemini che consente al sistema di ricordare le informazioni dell’utente per fornire risposte più precise e accurate. È qualcosa di simile a quanto ChatGPT fa già. Proprio utilizzando questa funzione, ho chiesto al chatbot di realizzare un’immagine basandosi sulle informazioni che ho scelto di condividere. Il risultato potete vederlo qui sotto, un esperimento che in tanti hanno già provato a ripetere per capire cosa l’IA avesse imparato di loro.

📚 Consigli di lettura: una settimana con un robot domestico (che sembra un peluche)

Può un robot rimpiazzare un gatto o un cane? È questa la domanda esplorata da Justin McCurry in un articolo per The Guardian, approfondimento in cui racconta la sua esperienza con Moflin, un robot da compagnia (pet robot) dotato di intelligenza artificiale e sviluppato da Casio prevalentemente per le donne tra i 30 e i 40 anni.

Moflin - che costa circa 300 sterline - promette di sviluppare una personalità unica e di costruire un legame emotivo con il suo proprietario attraverso suoni e movimenti che riflettono stati d’animo, come calma o ansia. Durante la sua settimana con Hammy, questo il nome del suo Moflin, McCurry ha esplorato le potenzialità e i limiti di questa tecnologia. Tra risate e momenti di riflessione, emergono i benefici del contatto con un robot: una presenza confortante e interattiva, pensata per affrontare solitudine e ansia, ma senza la complessità di un animale vero.

Il racconto solleva questioni importanti sull’interazione uomo-robot: un’IA può davvero sostituire l’affetto genuino di un animale? McCurry conclude che, sebbene affascinante e utile in determinati contesti – come quello delle case di cura in Giappone – Moflin resta un surrogato, incapace di replicare completamente la spontaneità e la connessione degli animali reali.

Un’esperienza che invita a riflettere su quanto siamo pronti ad accettare queste tecnologie nel nostro quotidiano e su quali possano essere i loro limiti e opportunità nel futuro.

💬 Il dibattito sull’IA

L'artigianato è sapere come iniziare, l'arte è sapere quando fermarsi.

Lo ha detto recentemente l’attore e registra Ben Affleck nel corso di un evento CNBC in cui ha parlato dell’impatto dell’intelligenza artificiale (paragonata a un artigiano) sul suo settore. Affleck - le cui affermazioni hanno avuto vasta eco negli USA - si è detto convinto che il prossimo James Bond non sarà realizzato dall’IA (che, secondo lui, è capace solo di imitare). L’attore è invece meno ottimista per gli operatori degli effetti speciali (‘sono spacciati’ ha detto con poco tatto parlando del lavoro di quel settore).

📣 Eventi

Forum della non autosufficienza - Bologna, 27-28.11.2024

Perspective Smart City - Napoli, 9-11.12.2024

Global AI Show - Dubai, 12-13.12.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.