🤖"Legge Zero" #0 - AI: è tutta una questione di trasparenza

ChatGPT licenzia il suo CEO per scarsa trasparenza, proprio mentre i governi di tutto il mondo si stanno occupando delle regole dell'intelligenza artificiale.

🧠 Non puoi regolare ciò che non conosci

Se state leggendo questa newsletter (a proposito, benvenuti!), sicuramente saprete che nelle scorse ore - con un annuncio a sorpresa - OpenAI (ChatGPT) ha licenziato il suo CEO, Sam Altman. Nel comunicato, insolitamente duro, si legge che la decisione è stata presa dal Consiglio di amministrazione perché non c’era più fiducia in Altman a cui viene rimproverato di non essere stato trasparente nei confronti del board. Sicuramente nelle prossime settimane capiremo di più delle reali motivazioni di questa scelta, che arriva a quasi un anno di distanza dal 30 novembre 2022, giorno in cui fu lanciato ChatGPT.

Un anno in cui - anche grazie a ChatGPT - il tema dell’intelligenza artificiale è diventato centrale nel dibattito pubblico. Pensiamo a quello che è successo solo nelle ultime settimane. AI è stata nominata parola dell'anno dal Collins Dictionary. Non male per un'abbreviazione.

Nel frattempo, i Paesi del G7 hanno stilato un Codice di condotta volontario per le aziende che sviluppano sistemi avanzati di intelligenza artificiale, affrontando questioni legate alla privacy e ai rischi per la sicurezza informatica. Nelle stesse ore, giornali e TV hanno dedicato grandissima attenzione al vertice sulla sicurezza dell'intelligenza artificiale che si è tenuto a Bletchley Park, dove rappresentanti dei Governi si sono confrontati con le più importanti aziende del settore, producendo un documento congiunto (la dichiarazione di Bletchley) su cui, oltre all’intesa UE-USA, si è registrato anche l’accordo della Cina.

Gli scienziati cinesi, infatti, avevano formulato un appello per una regolamentazione più rigorosa dell’intelligenza artificiale. Circostanza singolare: il vertice di Bletchley avrebbe dovuto tenersi a porte chiuse fino a quando - e non è una notizia da poco - il 30 ottobre è stato adottato un provvedimento del Presidente USA Biden . Si tratta di un executive order che la Casa Bianca ha, forse troppo enfaticamente, definito "le azioni più significative mai intraprese da un governo per la sicurezza dell’intelligenza artificiale".

A sua volta, l’executive order di Biden è arrivato poche ore dopo che si era conclusa una missione negli USA della Camera dei Deputati con l’obiettivo di comprendere lo stato dell’arte della tecnologia, in modo da acquisire elementi utili per le norme che saranno adottate in questa materia dal Parlamento italiano e per capire come questi nuovi strumenti possano migliorare il lavoro del Legislatore e la trasparenza nei confronti dei cittadini.

Insomma, in pochi giorni sono successe così tante cose e prodotti documenti così corposi che anche chi lavora nel settore potrebbe faticare ad orientarsi nel rumore (non solo social) che tutte queste notizie hanno prodotto. Ci è sembrato il momento giusto per avviare un nuovo progetto che provi ad approfondire i temi dell’IA e delle sue regole.

Mi pare che siamo tutti d’accordo - con pochi distinguo - che i principi etici dell’intelligenza artificiale siano importanti ma non bastino più. Nel corso degli ultimi 5 anni si sono moltiplicate carte e documenti etici con alcuni principi più che condivisibili, come quello di trasparenza degli algoritmi o di controllo umano oltre che di rispetto dei diritti dell’individuo. Ma quali sono, in concreto, i valori umani da difendere? Cosa significa evitare i pregiudizi o rispettare la privacy degli utenti? Come si assicura la trasparenza delle soluzioni di IA? Ecco questi sono aspetti che devono essere definiti dal legislatore e non possono essere lasciati agli impegni volontari delle aziende. Le soluzioni di intelligenza artificiale sono già parte delle nostre vite e lo saranno sempre di più. Servono quindi regole e standard normativi, meglio se internazionali. E non è facile.

La sfida, infatti, è improba: le nuove norme devono essere all’altezza del fenomeno che intendono regolare, devono essere neutre tecnologicamente, vanno dettate tempestivamente e non devono diventare troppo presto obsolete.

Come se non bastasse, c’è il rischio che i legislatori di tutto il mondo adottino regole ideologiche (cioè completamente slegate dalla conoscenza del fenomeno IA e dei suoi impatti) oppure norme che siano il frutto della paura collettiva (della stampa, dell’opinione pubblica, dello stesso legislatore) verso il nuovo, verso ciò che non si conosce.

Mai come in questo caso, quindi, è necessario “conoscere per deliberare”. Per questo motivo, è apprezzabile che parlamenti e autorità di tutto il mondo stiano conducendo “indagini conoscitive” o summit per comprendere meglio l’IA, avvalendosi anche del contributo di esperti.

È sicuramente un approccio apprezzabile, ma potrebbe non bastare. L’esperienza delle piattaforme di social media (e, almeno fin qui, dei fallimenti nella loro regolazione) ci insegna che l’effettività di ogni principio di trasparenza passa per la disponibilità di dati che, di solito, i gestori delle piattaforme non divulgano.

Insomma, per capire “cosa” e “come” normare, bisogna capire come funzionano le soluzioni, come sono addestrate, quali sono i controlli.

Qualche mese fa, in un interessante post sul suo blog, Tim O’Reilly aveva proposto la definizione di uno standard che, analogamente a quanto accade in contabilità con i principi generalmente accettati per la presentazione dei rendiconti finanziari, consenta di evitare lacune nelle informazioni rese note dagli operatori economici e renda i dati tra loro omogenei e confrontabili (es. dati sull’addestramento, sugli incidenti, sull’uso che gli utenti fanno dalle soluzioni di IA). Queste informazioni sono preziosissime per definire le regole e vigilare sulla loro attuazione.

In questo quadro, il licenziamento di Altman e le contestazioni sulla gestione interna di OpenAI mettono in evidenza i rischi legati all’opacità di tecnologie così potenti e trasformative. È essenziale che gli sviluppatori e le aziende di IA operino con una maggiore responsabilità, garantendo che tali tecnologie siano utilizzate in modo etico e trasparente.

Ovviamente, sono certo che ne riparleremo.

🔊 Un vocale da… Guido Scorza (Garante Privacy): due minuti, tutti da ascoltare, sul rapporto tra intelligenza artificiale e regolazione.

📰 Scarlett Johansson contro l’App Lisa AI: battaglia legale per la sua immagine virtuale

Avete visto “Her”? È un film del 2013, racconta la storia di un uomo che si innamora della voce (femminile) di un’assistente vocale. Nella versione originale la voce è quella di Scarlett Johansson. Ironia della sorte, l’avvocato dell’attrice ha fatto sapere nei giorni scorsi di aver intrapreso un’azione legale contro un'app di intelligenza artificiale (Lisa AI) che - in una pubblicità - ha usato la sua immagine e la sua voce senza permesso. La pubblicità è stata subito ritirata, ma quanto accaduto alla Johansson (e prima di lei ad altri, come Tom Hanks e Mara Venier) ci deve far riflettere sull’adeguatezza delle norme esistenti per prevenire simili abusi del diritto all’immagine e della reputazione.

📰 OpenAI crea un team per contrastare i rischi catastrofici legati all’IA

Nei giorni precedenti alla defenestrazione di Altman, Openai ha costituito un nuovo team, denominato Preparedness, per far fronte a una potenziale situazione catastrofica causata dai futuri modelli di IA. Tra i rischi che saranno monitorati ci sono: manipolazione, minacce chimiche, biologiche e nucleari, replica e adattamento degli automi.

Sarà molto interessante capire quale sarà il livello di trasparenza delle attività di questo laboratorio: nelle democrazie, il compito di adottare norme e politiche per contrastare i rischi catastrofici è proprio delle istituzioni che - per farlo - devono poter contare sulle informazioni degli operatori del settore.

📰 Aperta è più sicura proprietaria: 70 esperti prendono (pubblicamente posizione)

Proprio nel momento in cui è accesissimo il dibattito sulla governance dell'intelligenza artificiale, oltre 70 esperti, tra cui il noto scienziato dell'AI Yann LeCun di Meta, hanno firmato una dichiarazione pubblicata da Mozilla che invoca un approccio più aperto allo sviluppo dell'AI. La lettera sottolinea la necessità di trasparenza e accessibilità per mitigare i danni attuali e futuri derivanti dai sistemi AI. Questa chiamata all'azione arriva in un momento in cui la comunità globale è divisa tra chi sostiene il controllo proprietario per prevenire abusi e chi crede che solo il modello open source possa effettivamente rafforzare la sicurezza e l'innovazione. “Quando si tratta di sicurezza e sicurezza dell'IA, l'apertura è un antidoto, non un veleno” (questa l’efficace formula con cui si chiude la dichiarazione).

⚖️ Cosa significa “trasparenza dell’algoritmo”? Risponde la Cassazione

La Corte di Cassazione italiana ha preso una posizione decisa sulla trasparenza degli algoritmi e il consenso degli utenti, emettendo l'ordinanza numero 28358/2023. Il provvedimento stabilisce che gli utenti devono essere informati sullo schema esecutivo dell'algoritmo, ma non necessariamente sulle operazioni matematiche sottostanti che determinano i risultati. Questa pronuncia arriva a seguito di un contenzioso che ha visto un'associazione, che aveva creato una piattaforma web per l'elaborazione di profili reputazionali, fronteggiare l'Autorità Garante per il trattamento dei dati personali. La decisione sottolinea l'importanza della chiarezza nell'informativa e del consenso informato, rappresentando un importantissimo precedente per un uso responsabile degli algoritmi nel nostro Paese.

⚖️ AI Act: secondo l’EDPS devono vigilare i Garanti Privacy

Mentre le istituzioni europee stanno lavorando per finalizzare il testo del Regolamento Europeo sull’intelligenza artificiale, il Garante Europeo per la Protezione dei Dati Personali, Wojciech Wiewiórowski, ha espresso il suo parere sulla bozza di provvedimento.

Il parere contiene diversi punti interessanti. Innanzitutto - secondo l’EDPS - l'AI Act dovrebbe applicarsi a tutti i sistemi di IA già presenti sul mercato o in uso (non solo a quelli che subiranno cambiamenti significativi o modifiche sostanziali). Inoltre, suggerisce di designare direttamente le autorità nazionali per la protezione dei dati come responsabili del monitoraggio dell'applicazione del regolamento. Questo approccio, secondo il Garante, sarebbe il più rapido, economico ed efficiente per governare l'intelligenza artificiale, sfruttando le strutture e i meccanismi di cooperazione già esistenti all'interno dell'European Data Protection Board (EDPB).

Posizione comprensibile, ma difficilmente questo appello verrà accolto.

📲 Rewind.ai: una collana per la memoria perfetta (artificiale)

Rewind.ai è un servizio ambizioso: consente di registrare e cercare tutto ciò che gli utenti hanno visto, detto o sentito nella loro vita. Attraverso l’integrazione con ChatGPT promette di ricordare in modo molto più efficiente rispetto a quanto facciano gli sbadati umani.

Cosa avete fatto la scorsa settimana? Chi dovevate richiamare oggi? Come si chiamava quel vino buonissimo di cui vi ha scritto in chat il vostro amico? Quando avete conosciuto la persona che vi ha salutato per strada?

Tra qualche settimana, per chi vorrà, sarà disponibile anche una collana (Rewind pendant) che consente di registrare - e archiviare - ogni conversazione. Costerà solo 59$ e nei primi due giorni ha ricevuto già più di 3.500 preordini.

Ci sono implicazioni in materia di sicurezza dei dati (che ovviamente il fornitore dichiara essere massima) e su abilità (come la memoria) che progressivamente delegheremo agli algoritmi. Ma quello che mi chiedo è: cosa succederà alla morte degli utenti? L’IA consentirà agli eredi di navigare indisturbati tra ricordi, chat e conversazioni (più o meno private) del “caro estinto”? E anche noi siamo proprio sicuri di voler ricordare tutto?

In ogni caso, se volete provarlo lo trovate qui.

😂 IA Meme

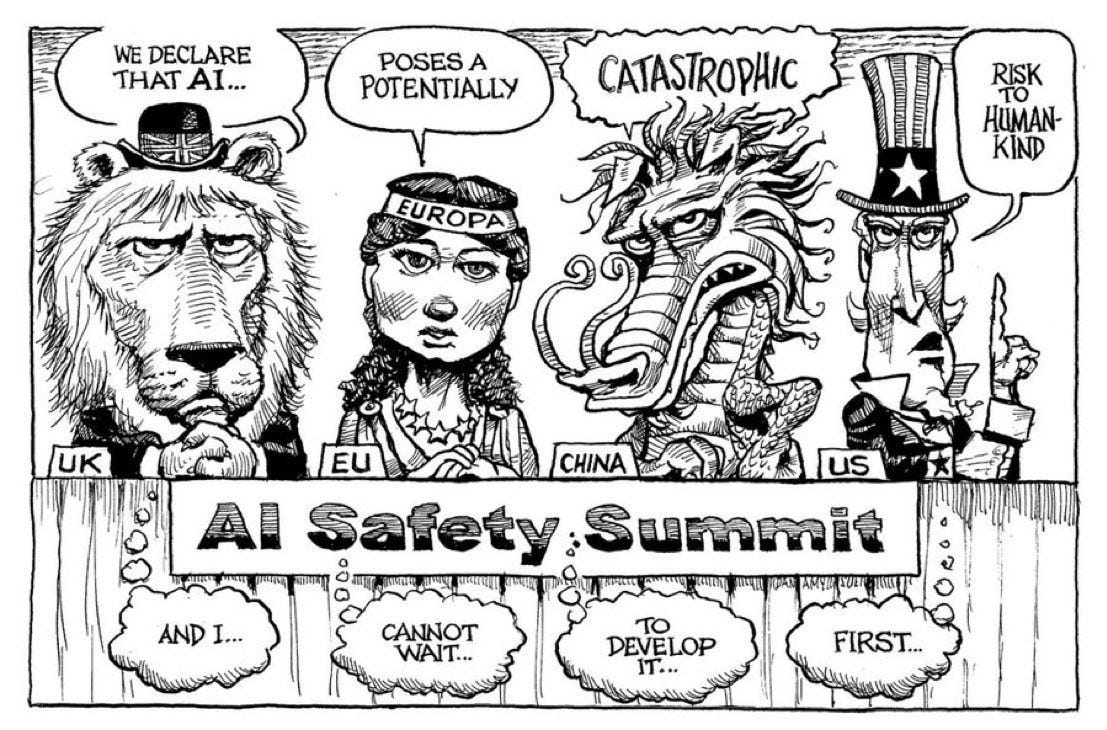

La dichiarazione di Bletchley vista da Elon Musk.

Questa è l’immagine che - il proprietario di X (la piattaforma un tempo conosciuta come Twitter - ha postato mentre stava per salire sul palco con il Primo Ministro UK.

L’accusa, neanche troppo velata, è che dietro l’impegno comune contro i rischi dell’IA ci sia la paura di essere superati nello sviluppo della tecnologia. La solita provocazione di Musk?

📚L’era dell'intelligenza artificiale - Il futuro dell’identità umana

Piaccia o meno, il dibattito sull’intelligenza artificiale è uscito dalla nicchia degli addetti ai lavori e questo è conseguenza dell’impatto che l’IA ha (e avrà sempre di più) in tantissimi campi dell’agire umano (dal lavoro al processo creativo dalle attività ludiche alla ricerca scientifica). Si tratta di uno dei concetti principali di “L’era dell’intelligenza artificiale”, libro scritto da Kissinger (ex Segretario di Stato USA), Schmidt (ex CEO di Google) e Huttenlocher (ricercatore del MIT). Il testo prova a spiegare cos’è l’IA e a comprendere cosa rappresenta, anche per gli assetti geopolitici futuri, fornendo alcuni concetti semplici e illustrando quali sono le sfide per la società (e quindi per il legislatore). Le pagine più interessanti sono quelle in cui il lettore è stimolato a interrogarsi su quale sia la riserva di umanità: tra 10 o 50 anni quali saranno le attività proprie dell’essere umano? quali invece bene presto saranno delegate ad algoritmi o robot?

💼 Eventi e incontri

Riflessioni su cooperazione giudiziaria, cybersecurity e intelligenza artificiale: le implicazioni per i diritti umani - Salerno, 21.11.2023

Costruire in Comune la transizione digitale: Persone, strumenti, comunicazione - Santarcangelo di Romagna, 23.11.2023

AI FAIR, la Fiera internazionale sull’intelligenza artificiale - Bologna, 5-7.12.2023