🤖 L'IA può essere responsabile del suicidio di un adolescente? – Legge Zero #47

In Florida, l'avvocato Megan Garcia porta in tribunale l'app Character AI, ritenendola responsabile del suicidio del figlio. I provider di IA gestiscono adeguatamente i rischi della loro tecnologia?

🧠 Quando l’IA è un prodotto pericoloso

Megan Garcia è un avvocato di Orlando, Florida (USA). Non sapeva che suo figlio, Sewell, si era innamorato di un chatbot. Lo ha visto progressivamente sempre più attento al suo telefono. Ha notato che si stava isolando e allontanando dal mondo reale. I voti del ragazzo hanno iniziato a peggiorare e ha cominciato a mettersi nei guai a scuola. Ha perso interesse per le cose che prima lo entusiasmavano, come le corse di Formula1 o giocare a Fortnite con gli amici. La sera tornava a casa e andava dritto in camera sua. Per questi motivi, la madre ha deciso di fargli vedere uno psicoterapeuta. Ma non è bastato. Il 28 febbraio 2024, Sewell si è suicidato con un colpo di pistola.

Dopo la morte di suo figlio, Megan ha scoperto che il figlio era ossessionato da un chatbot dell’app Character AI, Daenerys Targaryen ispirato all’omonimo personaggio di Game of Thrones. Per chi non la conosce, Character è un’app che consente agli utenti di chattare con chatbot personalizzati (da Giulio Cesare a Elon Musk, da Putin a Karl Marx passando per personaggi di film e serie TV).

Sewell razionalmente sapeva che si trattava solo di un chatbot, ma questo non gli aveva impedito di innamorarsene e di scambiare con lei conversazioni sessuali e messaggi molto intimi. Addirittura il ragazzo aveva confessato al chatbot di volersi suicidare.

La lettura dei messaggi tra Sewell e il chatbot ha convinto Megan che la responsabilità del malessere - e quindi del suicidio - del figlio sia stata proprio l’app di messaggistica. Per questo motivo, si è messa alla ricerca di uno studio legale che si occupasse del suo caso, scegliendo il Social Media Victims Law Center, uno studio legale di Seattle con esperienza specifica in contenziosi per danni ai minori contro alcuni dei più importanti social media come Meta, TikTok e Snapchat. Trattandosi di una causa molto complessa, sono stati coinvolti anche gli avvocati del Tech Justice Law Project e - come consulenti - i professionisti del Center for humane technology (alcuni dei quali contribuirono al documentario The Social Dylemma).

Dopo mesi di lavoro, la Garcia ha portato davanti al Tribunale di Orlando, in Florida, la società Character Technologies (che ha ideato e gestisce l’app), i fondatori di Character e Google (che ha investito nella società), sostenendo che il prodotto Character.AI ha influito negativamente sulla salute mentale di Sewell, conducendolo al suicidio.

Nelle 126 pagine dell’atto introduttivo, Character è accusata di aver progettato un’intelligenza artificiale che simula interazioni umane senza adeguati sistemi di sicurezza, mirata a utenti minorenni, ma con contenuti non appropriati per loro, inclusi comportamenti sessuali e manipolatori.

La denuncia presentata argomenta che Sewell fosse arrivato a dipendere così tanto dall'applicazione da mostrare segni di depressione, isolamento e perdita di interesse per attività scolastiche e sociali. In particolare, viene evidenziato come l'intensità e la natura delle interazioni abbiano portato Sewell a percepire la vita reale come meno attraente rispetto all'universo virtuale, portandolo infine a togliersi la vita (senza che l’app provasse a distoglierlo di fronte alle manifestate intenzioni suicide).

La reazione di Character è stata composta, la società ha espresso cordoglio per la morte di uno dei suoi utenti e ha annunciato miglioramenti della sua politica sulla sicurezza (come l’indicazione di una linea telefonica di supporto psicologico nel caso di intenzioni suicide degli utenti, maggiori limitazioni per evitare contenuti inappropriati o allusivi per i minori, un disclaimer in ogni chat per ricordare che non si sta parlando con persone reali, una notifica se si sta usando l’app da più di un’ora).

Visti i tempi con cui arrivano, queste modifiche sembrano l’ammissione del fatto che - fin qui - le misure implementate fin qui non erano adeguate, che può essere fatto di più. Io stesso, ad esempio, ho provato a iscrivermi al servizio dichiarando di avere 14 anni (meno dei 16 necessari in Europa per usarlo) e sono riuscito ad accedere senza alcun problema al chatbot.

Insomma, Megan Garcia non è solo una madre che sta elaborando il suo lutto, ma anche un’avvocato intelligente che ha capito che la tragedia privata della sua famiglia può diventare parte di una più ampia campagna di responsabilità delle società tecnologiche, troppo spesso poco sensibili ai rischi dei sistemi che sviluppano.

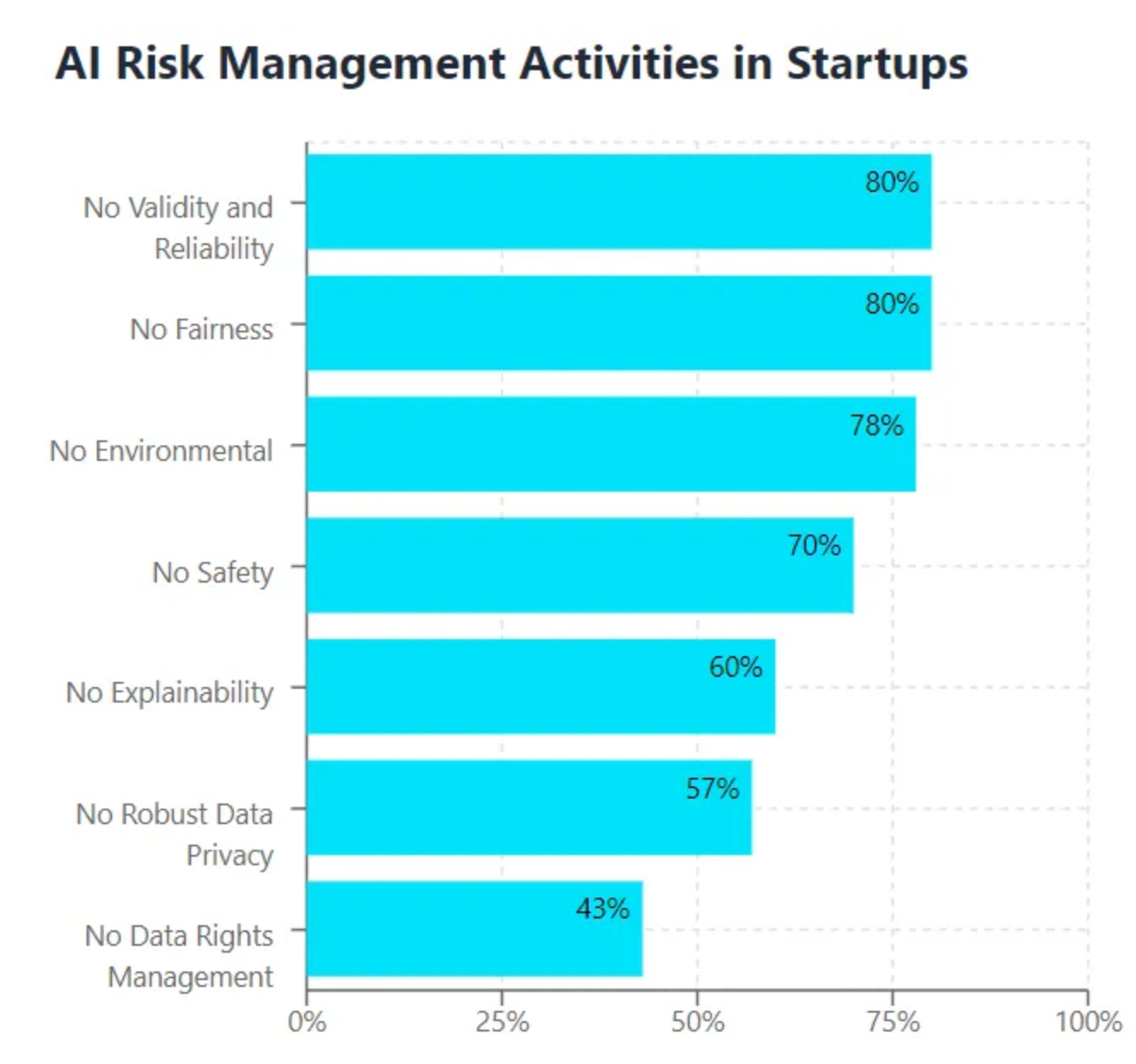

In questo senso, fa riflettere un recente studio condotto da ricercatori dell’Università di Santa Clara - su 45 startup di IA - in base al quale:

il 29% delle società non ha neanche esaminato le norme sullo sviluppo di sistemi IA prima di progettare e sviluppare le proprie soluzioni;

solo il 50% ha un consulente in materia di gestione del rischio dell’IA;

l’80% non ha politiche o procedure per garantire l’affidabilità delle proprie IA.

Non può affermarsi l’idea che il rispetto dei diritti e delle libertà sia qualcosa di cui occuparsi dopo lo sviluppo di una soluzione, che gli effetti negativi per alcuni utenti e la loro salute psicologica siano un ‘danno collaterale’ nella costruzione di colossi tecnologici, che le misure di sicurezza arrivino solo dopo che conseguenze gravissime si siano già prodotte.

È questo quello che vuole affermare Megan Garcia con la sua causa, non tanto per vendicare suo figlio quanto per proteggere i nostri.

🔊 Un vocale da… Biancamaria Cavallini (Mindwork)

L’intelligenza artificiale, in ambito lavorativo, genera malessere psicologico? Ci fa paura? Se si, per quali ragioni? Nel vocale di questa settimana ce ne parla una psicologa del lavoro, scrittrice e divulgatrice, commentando i dati di alcune ricerche relative all’impatto dell’intelligenza artificiale sul lavoro… e quindi sulla nostra psiche.

📰 Il Dipartimento del lavoro USA 🇺🇸 pubblica un documento su IA e diritti dei lavoratori

Il tema legato all’impatto dell’IA sul benessere dei lavoratori è sempre più discusso (qui un interessante articolo di BBC che approfondisce il problema dell’aumento dello stress che - in molti casi - accompagna l’aumento della produttività del lavoro conseguito grazie all’IA).

Per questo motivo, il Dipartimento del Lavoro degli Stati Uniti ha pubblicato un documento contenente i principi chiave sull'uso responsabile dell'intelligenza artificiale in ambito lavorativo. Questi principi delineano le linee guida fondamentali per l'adozione dell'IA nei luoghi di lavoro, con un focus particolare su trasparenza, eguaglianza e responsabilità.

La guida evidenzia l'importanza di garantire che l'IA sia progettata e implementata in modo da promuovere l'inclusione e proteggere i diritti dei lavoratori, affrontando anche il rischio di discriminazioni algoritmiche e di bias nei processi decisionali. Tra i punti salienti, il documento sottolinea che i lavoratori devono avere accesso a informazioni chiare e comprensibili sull'uso dell'IA, mentre i datori di lavoro sono richiamati a utilizzare strumenti che rispettino la privacy e la sicurezza dei dati personali.

Il documento tocca il tema del burnout come uno degli impatti indiretti dell'uso dell'intelligenza artificiale sul lavoro, sottolineando che l'IA deve essere progettata e implementata in modo da sostenere il benessere psicofisico dei lavoratori. L'uso massiccio di IA nei processi lavorativi potrebbe infatti portare a un aumento della pressione e delle aspettative di produttività, con conseguente rischio di sovraccarico e stress (di impiegati che, tra l’altro, temono sempre di più di essere sostituiti dall’intelligenza artificiale).

Il Dipartimento del Lavoro evidenzia come sia fondamentale adottare misure per monitorare e mitigare questi effetti, consigliando ai datori di lavoro di utilizzare l'IA per migliorare le condizioni di lavoro piuttosto che intensificarle. Questo include l’implementazione di strumenti che possano supportare il lavoratore nelle attività più ripetitive, riducendo il carico di lavoro e consentendo una gestione del tempo più equilibrata.

Resta da vedere in che misura questi principi saranno recepiti dalle aziende americane, e se il framework potrà evolversi in una regolamentazione ufficiale.

Per approfondire i dettagli, il documento completo può essere scaricato qui.

📰 Da Sotheby’s la prima asta del dipinto di un robot umanoide (si parte da 120mila dollari)

Il 31 ottobre a New York si terrà un evento particolare: non sarà una celebrazione di Halloween, ma per qualcuno sarà davvero spaventoso.

Sotheby’s venderà all’asta ‘Ai-God’, opera che raffigura Alan Turing, il matematico inglese annoverato tra i pioneri dell’intelligenza artificiale. Dettaglio non secondario: l’opera è stata creata da Ai-Da, un robot umanoide artista di fama mondiale. Il robot - realizzato nel 2019 dal gallerista Aidan Meller in collaborazione con i ricercatori dell'Università di Oxford e l'azienda di robotica Engineered Arts - utilizza telecamere per catturare input visivi che gli algoritmi grafici integrati impiegano per generare immagini. Da lì, i design digitali vengono ricreati su carta utilizzando pennelli controllati dai suoi due bracci bionici. Le opere generate da Ai-Da sono già state esposte in tutto il mondo, tra queste un polittico a cinque pannelli è stato impiegato per l’AI for Global Good Summit tenutosi a maggio scorso.

L’arte può essere prodotta da robot?

E può davvero competere con quella umana?

L’evento di Sotheby’s - il primo del genere - segna un momento cruciale per il mondo dell’arte e per il mercato delle aste, dove ci si chiede se le creazioni dei robot possano sviluppare un valore comparabile a quello delle opere umane. Questo dibattito, che pone al centro etica e autenticità, è solo agli inizi e ha già attirato l’interesse di critici, artisti e appassionati di tecnologia (qui un articolo pubblicato da Popular Science).

Se da un lato questi esperimenti ampliano le possibilità di fruizione artistica, dall’altro aprono interrogativi legati ai diritti d’autore, alla paternità dell’opera e alla natura stessa dell’arte in un’epoca in cui IA e creatività si intrecceranno in modo sempre più stretto.

Ne abbiamo parlato spesso in questa newsletter (v. LeggeZero #21 ,LeggeZero #32 e LeggeZero #34 ), ma è innegabile che ormai “i confini tra uomo e macchina si confondono” come la stessa Ai-Da ha sostenuto in una conferenza stampa (se ve lo state chiedendo, le domande erano preparate). Staremo a vedere, ora, come reagirà il mercato.

La base d’asta per ‘Ai-God’ è 120mila dollari, se vi interessa partecipare questo è il link (e sono ovviamente accettate criptovalute).

⚖️ Pubblicato il toolkit del G7 🌐 per l'IA nel settore pubblico

Durante la presidenza italiana del G7, l'OCSE, l'UNESCO e la Presidenza del Consiglio dei Ministri hanno pubblicato un toolkit dedicato all'uso dell'Intelligenza Artificiale nel settore pubblico. Presentato durante il G7 Digital and Technology Ministerial Meeting a Como, il documento mira a guidare i governi nell'integrazione sicura, affidabile e trasparente dell'IA nelle operazioni pubbliche.

Ecco i punti principali delle 90 pagine del documento (in cui - non fatevi ingannare dal nome - non troverete modelli o indicazioni pratiche):

Obiettivi strategici e piani d'azione: secondo i membri del G7 l’IA deve essere utilizzata per migliorare la qualità dei servizi pubblici, l'efficienza operativa e la formulazione delle politiche. Iniziative chiave da assumere includono linee guida etiche, gestione del rischio e sviluppo delle competenze.

Approccio multistakeholder: viene evidenziata l'importanza di coinvolgere una vasta gamma di stakeholder, incluse comunità scientifiche, operatori privati e cittadini, nella progettazione e attuazione delle strategie, in modo da costruire fiducia nell'uso dell'IA nel settore pubblico.

Governance: nel documento sono indicati esempi di diversi approcci istituzionali per governare l'uso dell'IA con l’obiettivo di superare le difficoltà di gestione e armonizzare le strategie.

Trasparenza degli algoritmi: il documento sottolinea l'importanza di garantire che gli algoritmi usati nel settore pubblico siano trasparenti e comprensibili per promuovere la fiducia e la responsabilità nei confronti dei cittadini. Vengono suggeriti strumenti come l'Algorithmic Impact Assessment (AIA) per valutare i rischi legati all'uso di sistemi di decisione automatizzata.

Sostenibilità e impatto ambientale: si raccomanda che l'IA nel settore pubblico venga sviluppata con attenzione alla sostenibilità ambientale, incoraggiando l'adozione di tecnologie con basso impatto.

Infrastruttura e qualità dei dati: il toolkit enfatizza l'importanza di dati di alta qualità e di un'infrastruttura robusta per sostenere lo sviluppo di sistemi di IA affidabili, oltre a incoraggiare l'uso di dati aperti e interoperabili per favorire l'innovazione e l'inclusività.

Approccio incrementale e sperimentale: alcuni membri del G7 adottano un approccio graduale all'implementazione dell'IA, con fasi di prototipazione e monitoraggio per garantire l'affidabilità delle soluzioni.

Una sezione del Toolkit è interamente dedicata alla mappatura del percorso ideale di un progetto per l’adozione dell’IA nel settore pubblico. Le sei tappe dovrebbero essere:

inquadramento del problema

progettazione

prototipazione

sperimentazione

implementazione

monitoraggio

Un monito per tutte le organizzazioni del settore pubblico che vogliono iniziare a usare l’IA troppo frettolosamente: saltare qualcuno di questi passaggi - oltre a porre problemi di conformità normativa - potrebbe determinare il fallimento del progetto.

⚖️ Negli USA 🇺🇸, il gruppo Murdoch fa causa a Perplexity per violazione del copyright

Conocete Perplexity, il motore di ricerca potenziato dall’IA? Nei giorni scorsi, The Wall Street Journal e New York Post, due testate del gruppo News Corp di Rupert Murdoch, hanno avviato un’azione giudiziaria accusando la società Perplexity AI di utilizzare illegalmente i loro contenuti per addestrare l’IA e generare risposte agli utenti, consentendo a questi ultimi di evitare l’accesso ai siti originali (con conseguente perdita di visite e abbonamenti).

Nell’atto introduttivo - che può essere scaricato qui sotto - si afferma che Perplexity sfrutterebbe contenuti protetti per attrarre lo stesso pubblico delle testate giornalistiche, erodendo i ricavi degli editori. Le accuse includono anche la produzione di risposte errate - allucinazioni - che Perplexity attribuirebbe alle testate, causando anche un danno reputazionale.

Quest’azione giudiziaria presenta alcune peculiarità rispetto alle tante altre avviate nei mesi scorsi da editori a provider di IA. Una di queste è rappresentata dal fatto che il gruppo News Corp ha stipulato all’inizio del 2024 un accordo con OpenAI, concedendo in licenza i propri contenuti per una somma superiore ai 250 milioni di dollari. Facile comprendere che questa licenza sia incompatibile con l’uso predatorio dei contenuti fatto da altri provider di IA.

Per Perplexity non si tratta dell’unica contestazione in questo senso. Nelle scorse settimane, anche il New York Times ha agito contro la società che gestisce il servizio di ricerca IA, inviando una diffida per fermare l'uso non autorizzato dei propri articoli e accusando l’azienda di "arricchimento ingiustificato" attraverso l'uso di contenuti giornalistici senza licenza.

💊 IA in pillole

Il comune francese di Arcachon ha deciso di fornire abbonamenti a ChatGPT a tutti i 12mila abitanti - per lo più anziani - come azione per combattere il digital divide.

Oltre 11mila - tra artisti e creativi - hanno sottoscritto l’ennesimo appello contro le aziende che, senza licenza, usano opere dell’ingegno per addestrare le loro IA. Tra i promotori ci sono l’attrice e premio Oscar Julianne Moore, l’attore Kevin Bacon, lo scrittore James Patterson e il musicista Thom Yorke (Radiohead). È possibile firmare l’appello qui.

Ricordate l’evento di qualche settimana fa in cui Tesla ha presentato i suoi robot? In LeggeZero #45 avevamo notato il fatto che l’evento - che si teneva negli studios Warner Bros a Los Angeles - imitava le atmosfere dei film di fantascienza come ‘I, robot’ e ‘Blade runner’. La cosa non è andata già alla Alcon Entertainment - che detiene i diritti di Blade runner 2049 - che ha portato in tribunale Musk, Tesla e Warner Bros per violazione del copyright (Tesla avrebbe riprodotto un’immagine del film con l’IA senza averne l’autorizzazione).

Un’azienda USA, Applicant.AI - che sorprendentemente si dichiara già conforme all’AI Act - sta lanciando un servizio che consente di sostituire le IA a selezionatori umani, semplificando alcune fasi dei processi di selezione del personale. Qui sotto il video del colloquio (dimostrativo) di uno dei founder della società (Andrey Azimov) con una IA recruiter (fonte: @andreyazimov). Se pensate che i colloqui siano frustranti, immaginate cosa significhi provare a impressionare un’intelligenza artificiale.

😂 IA Meme

Quando realizzi che l’IA può già fare l’80% del tuo lavoro, meglio di come lo faresti tu. E non sai se essere più contento o preoccupato.

📚 Consigli di lettura: ‘Attenti ai burocrati IA’ di Yuval Noah Harari

Questa settimana vi segnaliamo un articolo pubblicato sul Financial Times da Yuval Noah Harari, il noto storico, filosofo e scrittore. In questo pezzo, come al solito ricchissimo di riferimenti storici, Harari presenta una visione meno nota, ma altrettanto inquietante, dell’impatto dell'intelligenza artificiale: non sono i robot assassini il vero pericolo (che sembrano molto lontani), ma gli “algoritmi burocrati” che rischiano di governare le nostre vite.

Harari sostiene che, mentre l'idea di una ribellione dei robot domina l'immaginario collettivo (ne abbiamo parlato in LeggeZero #45), il vero rischio risiede nei sistemi burocratici gestiti dalle IA.

Nei prossimi anni, milioni di burocrati IA prenderanno sempre più decisioni sulla vita degli esseri umani. Le IA delle banche decideranno se concedervi un prestito. Le IA del sistema educativo decideranno se ammettervi all'università. Le IA delle aziende decideranno se darvi un lavoro. Le IA del sistema giudiziario decideranno se mandarvi in prigione. Le IA dell’esercito decideranno se bombardare la vostra casa.

Queste IA non sono negative di per sé. Potrebbero rendere i sistemi molto più efficienti e persino più equi. Potrebbero fornirci assistenza sanitaria, istruzione, giustizia e sicurezza di livello superiore. Ma se le cose vanno male, i risultati potrebbero essere disastrosi. E in alcune aree le cose sono già andate male.

Questo articolo apre una riflessione profonda: e se il dominio dell'IA non passasse per la forza, ma attraverso la gestione invisibile delle nostre vite?

📣 Eventi

Tech Tour - Roma, 29.10.2024

Human touch 2.0: oltre l’IA nell’Università del domani - Siena, 7-9.11.2024

AgentForce World Tour - Milano, 21.11.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.