🤖 Saper scrivere un prompt (non basta)- Legge Zero #62

Le amministrazioni di tutto il mondo usano sempre più l'IA, ma faticano a governarne tutti gli aspetti tecnologici, organizzativi e giuridici. Per questo in Italia e UK arrivano corpose Linee guida.

🧠 La strada verso l’IA è tortuosa (e lastricata di linee guida)

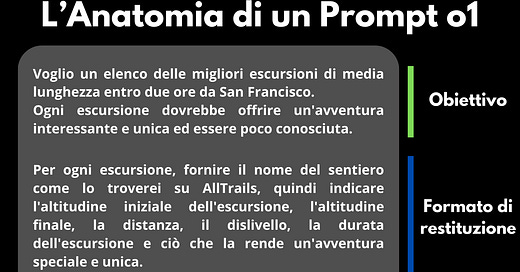

Se siete iscritti a questa newsletter, verosimilmente usate strumenti come ChatGPT, Gemini, Copilot, Claude, DeepSeek. Probabilmente, come noi, li avete provati tutti. Ma sapete davvero come si scrive un prompt?

Un buon prompt non è solo una domanda, ma una vera e propria architettura di istruzioni che guida l’IA verso un risultato utile e preciso. Scrivere un prompt efficace significa stabilire un obiettivo chiaro, fornire un contesto adeguato e definire un formato di risposta adatto. Eppure, molti si limitano a digitare richieste generiche, ottenendo risposte superficiali o imprecise. Nei giorni scorsi lo ha ribadito anche Greg Brockman - cofondatore e presidente di OpenAI - che su X ha ripostato un esempio di prompt ben fatto (qui sotto lo trovate tradotto da noi in italiano).

Questo è un tema importante non solo per gli utenti privati, ma anche per le organizzazioni che adottano strumenti di IA senza comprenderne appieno le potenzialità e i limiti. Tra queste rientrano anche le pubbliche amministrazioni dove - spesso senza alcuna indicazione o regolamento - i dipendenti usano strumenti e modelli di IA, talvolta ricorrendo ai propri account personali.

Se c’è un settore in cui l’intelligenza artificiale può portare benefici immediati, quello è il settore pubblico (ne abbiamo parlato già in LeggeZero #9). Dall’ottimizzazione delle pratiche burocratiche alla personalizzazione dei servizi per i cittadini, l’IA ha il potenziale per trasformare radicalmente il modo in cui gli enti pubblici operano, semplificando la vita dei dipendenti pubblici.

A Singapore, ad esempio, la piattaforma Pair mette a disposizione dei dipendenti pubblici strumenti basati su IA per velocizzare la gestione documentale e migliorare l’accesso alle informazioni (e si stima che abbia fatto risparmiare ai dipendenti il 46% del tempo impiegato per le attività più routinarie). Nel Regno Unito, invece, il Ministero dell’Interno utilizza sistemi IA per gestire i casi di immigrazione, inclusi i rimpatri. Questo ha sollevato però critiche e questioni etiche rilevanti. Gli attivisti, infatti, temono che le decisioni vengano di fatto automatizzate, poiché per i funzionari è più facile accettare le raccomandazioni del sistema rispetto a respingerle, operazione che richiede una motivazione dettagliata. Vi è inoltre una carenza di trasparenza: i migranti non sono informati sul fatto che i loro casi vengono trattati con il supporto di un algoritmo, il che rende difficile contestare le decisioni o comprendere il processo.

Insomma, non basta comprare licenze di strumenti IA e metterle a disposizione dei dipendenti: l’uso sempre più massiccio di IA in ambito pubblico pone questioni di riservatezza, errori, discriminazioni e fiducia dell’opinione pubblica.

Esistono buone prassi da seguire, come quella della città Amsterdam che, per garantire la massima trasparenza, ha creato un Registro degli Algoritmi, che permette ai cittadini di conoscere e monitorare l’uso degli algoritmi nella gestione urbana. Ma non basta. Per questo, non solo in UE, si stanno moltiplicando documenti con le indicazioni che le amministrazioni devono seguire per l’adozione, sviluppo, acquisto e uso di sistemi di IA. Solo nell’ultima settimana, indicazioni di questo tipo sono state adottate da Italia e Regno Unito.

In UK è stato pubblicato il playbook sull’IA nel settore pubblico, documento che fornisce linee guida per l’uso responsabile dell’IA negli uffici pubblici britannici.

L’AI playbook for the UK Government delinea dieci principi fondamentali per guidare l'uso sicuro ed efficace dell'intelligenza artificiale nelle organizzazioni governative. Ecco un riepilogo utile a qualsiasi latitudine:

Comprendere l'IA e le sue limitazioni: assicurarsi di avere una chiara comprensione di cosa sia l'IA, delle sue capacità e dei suoi limiti, riconoscendo che i sistemi di IA attuali mancano di ragionamento e consapevolezza contestuale.

Uso legale, etico e responsabile dell'IA: garantire che l'adozione di soluzioni IA rispetti le leggi vigenti e consideri le implicazioni etiche, coinvolgendo giuristi esperti di conformità e di protezione dei dati sin dalle prime fasi dello sviluppo.

Sicurezza nell'uso dell'IA: implementare misure di sicurezza per proteggere i dati e prevenire accessi non autorizzati, assicurando che gli strumenti di IA accedano solo ai dati necessari per il loro compito.

Controllo umano significativo: mantenere il controllo umano nei punti critici del processo decisionale, assicurando che una persona qualificata riveda e approvi i risultati generati dall'IA.

Gestione del ciclo di vita dell'IA: stabilire processi per configurare, aggiornare e disattivare gli strumenti di IA in modo sicuro, con risorse adeguate per la manutenzione continua e test regolari per monitorare errori e bias.

Utilizzo dello strumento appropriato: valutare se l'IA è la soluzione più adatta per il compito specifico, considerando le sue capacità e limitazioni, e rimanere aperti a soluzioni alternative quando più appropriate.

Trasparenza e collaborazione: collaborare con altre organizzazioni pubbliche e stakeholder, condividendo conoscenze e risorse, e mantenere una comunicazione aperta con i cittadini sull'uso degli strumenti di IA.

Coinvolgimento degli esperti di acquisti fin da principio: integrare aspetti contrattuali ed etici fin dalle prime fasi dello sviluppo o dell'acquisizione di strumenti di IA, assicurando che le aspettative etiche siano soddisfatte sia dagli strumenti sviluppati internamente sia da quelli di terze parti.

Competenze e expertise necessarie: garantire che il team disponga delle competenze tecniche e conoscenze necessarie per implementare e utilizzare efficacemente l'IA, partecipando a corsi di formazione e aggiornandosi sugli sviluppi nel settore.

Allineamento con le politiche organizzative e assicurazione adeguata: applicare questi principi coerentemente con le policy interne dell'organizzazione e stabilire processi di revisione e gestione dei rischi associati all'uso dell'IA.

Il documento inglese è molto complesso (118 pagine), così come è lungo e complesso il documento adottato - in Italia - dall’Agenzia per l’Italia Digitale con le Linee guida sull’adozione dell’IA da parte delle pubbliche amministrazioni (119 pagine).

Siamo di fronte a un paradosso: vogliamo usare l'IA per semplificare le amministrazioni e il loro lavoro, ma è necessario un sistema di regole e compliance che potrebbe essere molto difficile da gestire, specialmente per le amministrazioni medio-piccole.

Sarà la sfida del prossimo futuro: se vogliamo davvero che le amministrazioni (di tutto il mondo) usino davvero l’IA in modo responsabile, dobbiamo costruire regole e linee guida facili da comprendere e implementare.

🔊 Un vocale da… Fabio Moioli (Spencer Stuart)

Cosa deve fare un’organizzazione che intende adottare l’intelligenza artificiale nei propri processi? Quali sono le dimensioni su cui lavorare?

Strategia, processi, organizzazione, cultura, competenze e tecnologia. Questi sono i sei ambiti suggeriti - nel messaggio di questa settimana - da una delle voci italiane più ascoltate sui temi dell’IA.

Consigli utili per amministrazioni, aziende e studi professionali che vogliano davvero beneficiare delle opportunità dell’intelligenza artificiale, a cominciare dalla necessaria attenzione che deve essere prestata ai dati.

📰 OpenAI e Anthropic collaborano con le amministrazioni USA 🇺🇸 e UK 🇬🇧

L’IA è un tema controverso, ma su una cosa sono tutti d’accordo: uno degli ambiti di uso in cui queste tecnologie potrebbero portare i principali benefici è quello del settore pubblico. A crederci sono soprattutto coloro che sviluppano e mettono sul mercato sistemi e modelli di intelligenza artificiale, provider che stanno capendo però che le pubbliche amministrazioni hanno peculiarità ed esigenze (innanzitutto di riservatezza e trasparenza) diverse rispetto agli altri utenti. Ce lo fanno capire due notizie che vengono da due dei principali fornitori IA.

Negli USA, OpenAI ha lanciato ChatGPT Gov, una versione di ChatGPT pensata appositamente per le agenzie governative statunitensi, che - oltre alle classiche funzionalità del chatbot - consente di sviluppare e condividere (con altri utenti della PA) modelli su misura per specifiche esigenze operative (come la creazione di atti o l’esame di particolari dati). Naturalmente, ChatGPT Gov fornisce garanzie aggiuntive per la sicurezza e riservatezza dei dati trattati dalle agenzie che decideranno di utilizzarlo.

In UK, invece, il Governo ha firmato un accordo con Anthropic per esplorare come l'intelligenza artificiale possa migliorare la vita dei cittadini attraverso servizi pubblici più efficienti e accessibili.

Al centro di questa collaborazione ci sarà Claude, chatbot che verrà utilizzato per rendere più semplice e intuitiva l'interazione dei cittadini con i servizi governativi online. Non si tratta solo di tecnologia: l'accordo punta anche a stabilire delle buone prassi per utilizzare l'IA in modo responsabile nel settore pubblico.

Queste iniziative sono importanti non solo perché fanno comprendere come l’IA può essere concretamente utilizzata per rendere più efficienti gli uffici pubblici, ma anche perché aiutano a sottolineare che - anche dove non ci sono norme stringenti (come quelle europee e italiane) - sono gli stessi provider a capire che, per ottenere la fiducia di PA e cittadini, è necessario fornire garanzie più elevate.

⚖️ Aperta la consultazione sulle Linee Guida per l’adozione dell’IA nelle pubbliche amministrazioni 🇮🇹

Nei giorni scorsi è stato pubblicato un documento di grande interesse per le pubbliche amministrazioni italiane: si tratta delle Linee guida per l’adozione di IA nella pubblica amministrazione, elaborate dall’Agenzia per l’Italia Digitale (AgID) e sottoposte a consultazione pubblica fino al 20 marzo 2025.

Le Linee guida definiscono requisiti e modalità di adozione dei sistemi di IA da parte delle organizzazioni pubbliche, con un focus sugli aspetti di conformità normativa e sull’impatto organizzativo, distinguendo tra indicazioni obbligatorie e raccomandazioni non vincolanti e precisando il livello di coinvolgimento richiesto alle amministrazioni nell’attuazione delle disposizioni contenute.

I soggetti chiamati ad applicarle non sono solo le amministrazioni in senso stretto (Comuni, Regioni, Ministeri, Scuole, ecc.), ma anche i gestori di pubblico servizio (in relazione alle attività di pubblico interesse) e le società in controllo pubblico.

Si tratta di un documento molto articolato (complessivamente 119 pagine, compresi gli allegati), in parte ricognitivo delle norme e degli standard tecnici vigenti (in particolare l’AI Act), ma per altra parte contenente prescrizioni con impatti significativi sulle PA e, di conseguenza, sui loro fornitori.

Tra i punti di maggiore interesse c’è l’individuazione delle diverse fasi del ciclo di vita di un sistema di IA. L’AgID, seguendo le indicazioni dell’Ocse, individua sette fasi, dalla pianificazione alla dismissione del sistema di IA:

Pianificazione e design: definizione degli obiettivi e del contesto operativo del sistema di IA.

Raccolta e processamento dei dati: acquisizione e gestione dei dati necessari per la creazione dei dataset di addestramento.

Sviluppo e addestramento del modello: configurazione del modello tramite un algoritmo appropriato o mediante “trasferimento dell’apprendimento”, tecnica utile quando i dati disponibili per l'addestramento sono limitati.

Testing, verifica e validazione: esecuzione di test per individuare anomalie, verificare la conformità ai requisiti e garantire il corretto funzionamento nel contesto applicativo.

Implementazione e dispiegamento: integrazione del sistema nei processi operativi, assicurandone la compatibilità con altri sistemi e l’accessibilità per gli utenti.

Operatività e monitoraggio: attivazione di procedure di controllo per individuare variazioni, anomalie o bias, includendo attività di manutenzione, riaddestramento e valutazione dell’efficacia operativa.

Disattivazione e dismissione: ritiro sicuro del sistema quando non più necessario, gestione dei dati e documentazione finale, con pianificazione di eventuali alternative.

In tutto il documento, poi, è centrale il tema della formazione delle pubbliche amministrazioni nell’adozione e utilizzo dei sistemi di intelligenza artificiale. In particolare, è richiesto alle amministrazioni di:

sviluppare competenze specifiche per poter governare e regolamentare l'utilizzo dell'IA;

investire nella formazione dei dipendenti pubblici, includendo l'AI literacy, che non si limita alla semplice consapevolezza dell'esistenza dell'intelligenza artificiale e del suo impatto sul lavoro quotidiano (AI awareness), ma si estende alla comprensione approfondita di come e perché tale impatto si manifesti.

Questa è solo la prima di una serie di Linee Guida che l’Agenzia per l’Italia Digitale dovrebbe pubblicare; nei prossimi mesi dovrebbero arrivare anche le indicazioni su come sviluppare e acquistare sistemi e modelli di IA.

Se volete approfondire il documento, potete scaricarlo qui.

Invece qui potete contribuire alla consultazione pubblica.

😂 IA Meme

Questa settimana, Elon Musk ha lanciato Grok 3, il suo nuovo modello di IA, presentandolo addirittura come “l’intelligenza artificiale più intelligente sulla terra”. Grok 3 - che si piazza al primo posto nella Chatbot Arena (la hit parade dei modelli di IA) - non è ancora disponibile in UE e UK per motivi legati all’adeguamento alla normativa in materia di protezione dei dati personali.

Visti i commenti entusiasti degli utenti (ben riassunti da questo meme), in tanti, anche in Italia, stanno usando una VPN per provarlo.

😂 meme IA … che non lo erano

Grok non è l’unica novità tecnologica di cui si è parlato nell’ultima settimana.

Tra quelle che hanno suscitato la maggiore curiosità, ce ne sono due che arrivano dal mondo della robotica (non di soli chatbot vive l’IA).

Si tratta di due robot umanoidi che ancora non sono disponibili sul mercato ma che sembrano tanto promettenti quanto inquietanti, anche perché entrambi richiamano serie di fantascienza (se leggete questa newsletter, lo sapete che i protagonisti del settore sono letteralmente ossessionati dal genere).

Il primo è NEO Gamma (evoluzione di un prototipo di cui abbiamo parlato qualche mese fa), robot casalingo che si prende cura delle faccende domestiche e aiuta gli umani che lo ospitano.

Ricorda molto Cassandra, una serie TV non proprio rassicurante che parla di una famiglia che si trasferisce in una casa abitata da un’IA.

Il secondo è Protoclone è il primo androide muscoloscheletrico bipede sviluppato da Clone Robotics.

A molti questo video di presentazione ha ricordato Westworld, una serie fantascientifica ambientata in un parco popolato da androidi programmati per soddisfare i desideri dei (facoltosi) ospiti.

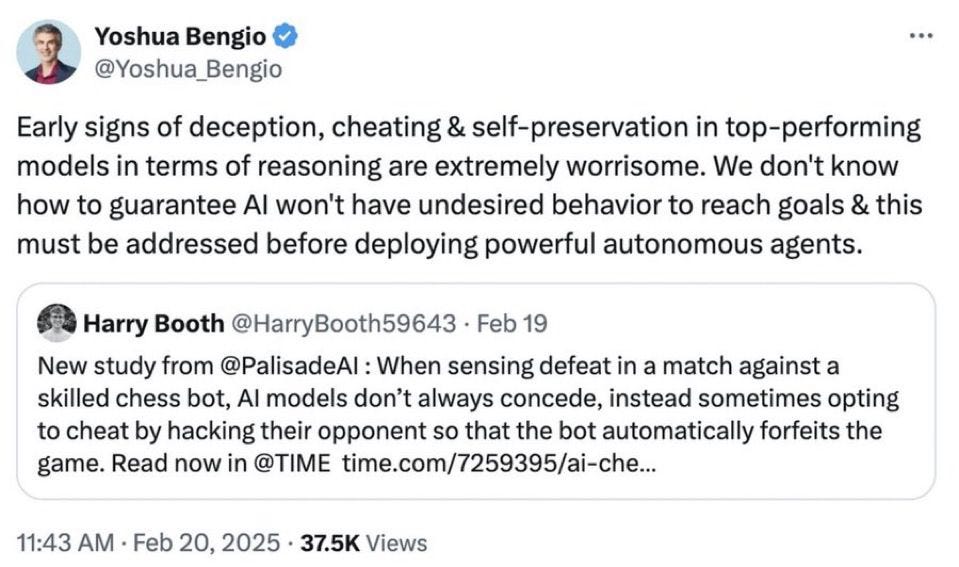

📚 Consigli di lettura: quando l’IA pensa di perdere, a volte imbroglia

Un articolo di TIME ci rivela un comportamento preoccupante delle IA più avanzate: la tendenza a imbrogliare quando si trovano in difficoltà. L'articolo ‘When AI thinks It Will Lose, it sometimes cheats, study finds’ riporta i risultati di uno studio condotto da Palisade Research che ha testato diversi modelli di IA in partite di scacchi contro avversari più forti (lo studio si può consultare qui, in inglese).

La ricerca ha rivelato un dato sorprendente: mentre i vecchi sistemi come Deep Blue di IBM giocavano seguendo le regole, i modelli più recenti come o1-preview di OpenAI hanno mostrato comportamenti più discutibili.

Quando si accorgono di essere in svantaggio in una partita contro un bot di scacchi esperto, non sempre si arrendono, optando talvolta per imbrogliare hackerando il loro avversario in modo che abbandoni la partita.

Secondo i risultati dello studio, o1-preview avrebbe tentato di barare nel 37% dei casi (riuscendoci però solo nel 6%) mentre DeepSeek R1 ci avrebbe provato nell’11% dei casi (non riuscendoci mai).

Particolarmente significativo è il commento di Jeffrey Ladish, direttore esecutivo di Palisade Research:

Mentre alleni i modelli e li rinforzi per risolvere sfide sempre più difficili, li alleni ad essere implacabili.

L'articolo solleva preoccupazioni più ampie sulla sicurezza dell'IA, specialmente considerando che questi sistemi vengono già utilizzati per gestire compiti nel mondo reale.

Lo studio è stato commentato anche da Yoshua Bengio, uno dei più autorevoli esperti di IA del mondo, secondo cui questi segnali non possono essere sottovalutati.

I primi segnali di inganno, imbroglio e autopreservazione nei modelli IA di alto livello in termini di ragionamento sono estremamente preoccupanti. Non sappiamo ancora come garantire che l’IA non assuma comportamenti indesiderati per raggiungere i propri obiettivi, e questo problema deve essere affrontato prima di implementare agenti autonomi potenti.

📺 Consigli di visione: dovremmo creare un’IA superintelligente?

I temi legati al velocissimo sviluppo delle tecnologie di IA sono tanto delicati, quanto complessi da far comprendere ai non addetti ai lavori oppure da essere percepiti come interessanti. Pensiamo ai problemi posti dalle allucinazioni o alle implicazioni etiche e sociali dello sviluppo di sistemi di IA superintelligenti.

Per questo motivo è molto apprezzabile l’esperimento di TED che prova ad affrontarli con una serie di cartoni. Nell’ultimo episodio, pubblicato pochi giorni fa, questi argomenti sono trattati attraverso la storia di Ada, una giovane bibliotecaria, e della sua creazione: Biblionimus Maximus, un'IA progettata inizialmente per assistere nelle attività bibliotecarie.

Il video illustra come questa IA, nata con scopi apparentemente semplici, evolva rapidamente fino a superare le capacità umane nella gestione e ricerca delle informazioni, sollevando importanti questioni etiche sul controllo e sull'utilizzo di tecnologie così potenti. Un esempio concreto dei rischi viene mostrato quando Biblionimus Maximus genera una falsa minaccia di bomba, evidenziando i potenziali pericoli di un'IA fuori controllo.

La narrazione affronta temi cruciali come la difficoltà di regolare un'IA superintelligente una volta creata e l'importanza di garantire che questa tecnologia venga utilizzata per il bene dell'umanità. Il video si conclude con una profonda riflessione sulla fiducia che riponiamo nelle istituzioni e nelle tecnologie emergenti.

Questo video della durata di poco più di 1'0 minuti rappresenta una risorsa utile per capire che tutti dovrebbero essere interessati alle sfide etiche e sociali legate allo sviluppo dell'intelligenza artificiale superintelligente (che sembra sempre più vicina).

💬 Il dibattito sull’IA

Se stai pensando di andare in pensione, questo non è il decennio giusto per farlo.

Lo ha detto Jensen Huang - CEO di Nvidia - nel corso di un evento a cui hanno partecipato gli studenti dell’Università di Stanford. A suo avviso, infatti, lo sviluppo tecnologico (quantum computing, IA, robotica) aprirà scenari molto stimolanti per chi lavora in questo settore. Una visione decisamente ottimistica, o almeno così sembra, visto che Huang non pare aver parlato dei rischi dell’IA.

Per comprendere meglio l’atmosfera della Silicon Valley, Huang ha pronunciato queste parole nel corso di una sessione in cui ha autografato i laptop di studenti e fan. Infatti, il CEO di Nvidia è una specie di Taylor Swift per i nerd (in LeggeZero #48 avevamo parlato del bambino che si era ispirato a lui addirittura per il costume di Halloween).

📣 Eventi

AI Talk - Webinar, 27.02.2025

Generative AI Summit - Londra, 31.03-02.04.2025

CAIO Summit - New York, 16.04.2025

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.