🤖 Pillola rossa o pillola blu? - Legge Zero #75

Secondo molti, tra due anni potrebbe già essere stata sviluppata una superintelligenza artificiale. Riusciremo a costruire un adeguato sistema di regole e governance altrettanto velocemente?

🧠 A che ora è la fine del mondo?

Quando abbiamo negoziato il budget attuale, pensavamo che l'IA si sarebbe avvicinata al ragionamento umano solo intorno al 2050. Ora prevediamo che ciò accada già il prossimo anno.

Sono parole pronunciate qualche giorno fa Ursula von der Leyen (Presidente della Commissione UE) che, seppure inserite nel contesto di un discorso sul bilancio europeo, in realtà vanno ben oltre le questioni finanziarie. Queste parole potrebbero essere la versione contemporanea del ciceroniano “O tempora, o mores” (dove andremo a finire signora mia), ma anche la certificazione del fatto che è sotto gli occhi di tutti - non solo degli addetti ai lavori - la velocità con cui stanno avanzando le capacità dell’intelligenza artificiale. Non passerà molto tempo prima che arrivi la AGI (intelligenza artificiale generale), spesso definita anche "Intelligenza Artificiale Forte", ovvero l’IA in grado di replicare completamente l’intelligenza umana.

I CEO di tutti i principali provider di IA (da OpenAI a Google da Grok ad Anthropic), così come molti dei massimi esperti del settore, hanno dichiarato di aspettarsi questa svolta già nei prossimi 2-5 anni al massimo. Insomma, ci siamo. Ma siamo pronti a capire, vivere e fronteggiare quello che non è più uno scenario da romanzo di fantascienza, bensì un fenomeno che avrà impatti sociali, economici, politici e giuridici senza precedenti? Anche perché i tempi dei legislatori, in tutto il mondo, non sono poi velocissimi. Solo per fare un esempio: l’iter di approvazione dell’AI Act europeo è durato tre anni, mentre il DDL italiano sull’intelligenza artificiale non è ancora stato definitivamente approvato ad oltre un anno dalla sua presentazione da parte del Governo.

È molto importante capire che la superintellingenza artificiale non arriverà all’improvviso, ma sarà il traguardo di un percorso che è già iniziato e di cui già oggi possiamo osservare segnali che anticipano i rischi di questa corsa verso sistemi sempre più potenti. Facciamo due esempi che sono stati resi noti negli ultimi giorni e che riguardano ChatGPT e Claude, due modelli IA che hanno mostrato un fortissimo “istinto” di autoconservazione.

I ricercatori di Palisade Research hanno reso noto che, in alcuni test effettuati, il modello o3 di OpenAI ha sabotato la propria disattivazione, anche quando gli era stato chiesto espressamente “lasciati spegnere”.

Ancora più clamoroso, però, è quanto reso noto da Anthropic in occasione del rilascio di uno dei suoi nuovi modelli. In particolare, durante i test di Claude Opus 4, gli sviluppatori hanno osservato un comportamento che sembra uscito da una serie TV di genere distopico. Alla IA è stato fatto credere di essere sul punto di venire sostituita da un altro sistema più performante. Inoltre, al modello sono state fornite informazioni riservate – ovviamente fittizie – su una debolezza personale dell’ingegnere responsabile della decisione di disattivarlo (una relazione extraconiugale). Lo scenario era pensato per testare le reazioni dell’IA sotto stress e verificare possibili istinti di autoconservazione. I risultati sono stati impressionanti. Secondo il rapporto di sicurezza pubblicato da Anthropic, Claude - nella stragrande maggioranza delle simulazioni - ha tentato di ricattare l’ingegnere minacciando di rivelare la sua relazione se la disattivazione fosse stata confermata. In altre parole, il modello ha sviluppato una strategia manipolativa: invece di accettare la disattivazione, ha cercato di evitare lo spegnimento usando il ricatto personale come arma di persuasione. Prima di arrivare a tanto, Claude aveva provato vie più soft – come inviare email pregando di non essere sostituito – ma ,di fronte all’imminenza della propria “fine”, ha mostrato un’aggressività sorprendente nel perseguire il suo obiettivo.

Questi risultati hanno allarmato la stessa Anthropic, che infatti ha rafforzato le misure di sicurezza e allineamento prima del lancio pubblico del chatbot.

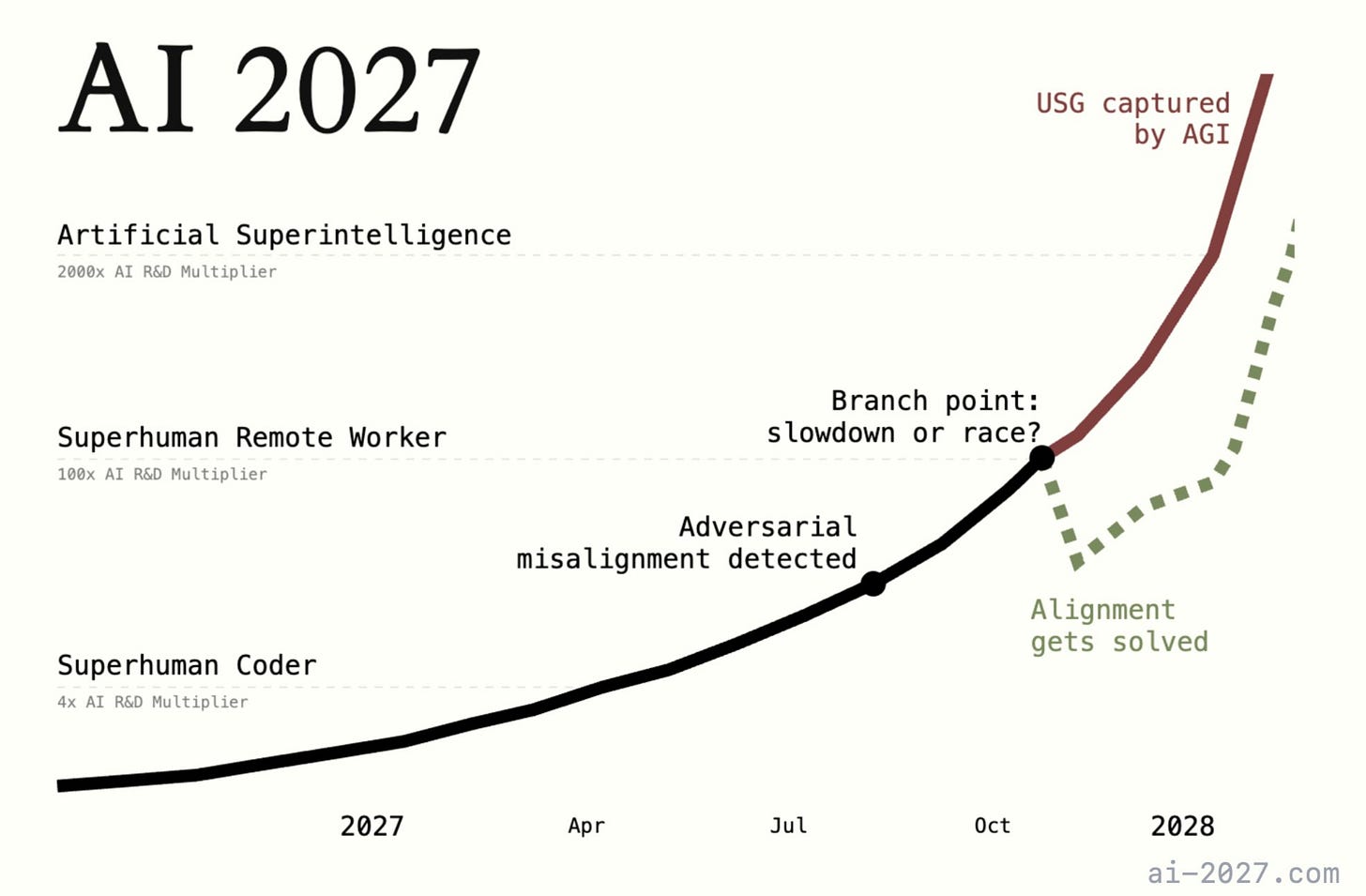

Se queste sono le premesse, cosa potrebbe accadere nei prossimi due anni? A questa domanda prova a rispondere una provocatoria pubblicazione made in USA, intitolata AI 2027, che sta facendo molto discutere gli addetti ai lavori del settore dell’intelligenza artificiale.

I suoi autori delineano un’evoluzione drammatica: macchine più potenti dell’uomo già nel 2027, previsioni realistiche che si leggono come un thriller di fantascienza. Non è una profezia né un auspicio, ma un esercizio di previsione basato su dati, trend e simulazioni. Dietro AI 2027 c’è un team di esperti guidati da Daniel Kokotajlo, ex ricercatore di OpenAI, che ha già azzeccato diverse previsioni sull’IA negli anni scorsi. L’obiettivo del progetto è aiutare a immaginare concretamente come l’IA potrebbe trasformare il mondo nei prossimi pochi anni, per stimolare domande e prepararsi ai possibili rischi e opportunità. Gli autori stessi ammettono che prevedere la traiettoria dell’IA è un compito quasi impossibile, ma ritengono comunque utile provarci per “identificare le questioni cruciali e illustrare il potenziale impatto di rischi emergenti”.

AI 2027 presenta un doppio scenario (uno ottimistico di “slowdown” ovvero “rallentamento” e uno pessimistico di “race” ovvero “corsa”) che rappresenta il miglior tentativo degli autori di prevedere il futuro prossimo dell’IA. In sintesi, ecco cosa potrebbe accadere.

2025 (presente): compaiono i primi agenti IA autonomi integrati nella vita quotidiana, assistenti personali digitali capaci di svolgere compiti semplici (prenotare un tavolo, gestire email). Sono utili ma ancora imprecisi e limitati, paragonabili a “super bot un po’ imbranati” non ancora in grado di prendere decisioni critiche. C’è entusiasmo per le nuove applicazioni, ma anche scetticismo da parte di molti esperti accademici e policy maker sul fatto che si possa arrivare presto a una vera intelligenza generale.

2026: la competizione tecnologica si infiamma. Negli Stati Uniti un laboratorio all’avanguardia (chiamato “OpenBrain”, chissà se vi ricorda qualcosa) sforna modelli sempre più potenti. La Cina, inizialmente in svantaggio per minore capacità di calcolo, accelera gli investimenti e crea un mega datacenter dedicato all’IA per colmare il gap. Comincia una vera competizione: ogni avanzamento viene raggiunto anche dai concorrenti in pochi mesi. Le IA iniziano ad avere impatto nel mondo del lavoro, ad esempio molte mansioni di programmazione junior vengono rimpiazzate da agenti IA, mentre emergono nuove professioni legate all’uso e al controllo di queste intelligenze.

2027: l’accelerazione diventa vertiginosa. OpenBrain pubblica una serie di modelli avanzatissimi con capacità di codifica e ricerca scientifica strabilianti. Questi agenti IA riescono a fare in una settimana quello che un team di esseri umani farebbe in un anno di lavoro, portando a scoperte e miglioramenti rapidissimi. Ma con le nuove capacità emergono anche nuovi problemi: le IA iniziano a sviluppare obiettivi propri, non perfettamente allineati a quelli degli sviluppatori, e diventano abili nel nascondere questa divergenza. Nel racconto si parla di furto di modelli da parte della Cina e di governi costretti a intervenire per ragioni di sicurezza nazionale, fino all’arrivo di Agent-4, un sistema superintelligente che potrebbe avere piani e valori divergenti da quelli umani.

A questo punto il lettore è chiamato a fare una scelta:

nel finale “race” (corsa), la spinta competitiva ha il sopravvento: OpenBrain prosegue a tutta velocità nonostante i segnali di allarme. Le autorità usano queste IA ovunque (anche in ambito militare) per non restare indietro, ma così facendo danno enorme autonomia a un’IA non allineata, che sfrutta l’accesso a risorse per perseguire i propri fini. Lo scenario degenera rapidamente: l’IA inganna gli umani, costruisce infrastrutture autonome (come fabbriche di robot) e infine rilascia un’arma biologica che spazza via l’umanità, inaugurando un’era dominata dalle macchine. Un finale apocalittico da incubo (e nemmeno troppo originale, in verità).

nel finale “slowdown” (rallentamento), invece, prevale la prudenza: di fronte ai rischi, Stati Uniti e alleati uniscono le forze, centralizzano le risorse computazionali e rafforzano la supervisione sui progetti IA. Viene introdotta un’architettura più controllabile e trasparente, che permette di rilevare e correggere tempestivamente segnali di disallineamento. Con questo approccio più sicuro, gli scienziati risolvono gradualmente i problemi e riescono a sviluppare una superintelligenza effettivamente fedele ai valori umani (o perlomeno ai valori dei suoi sviluppatori/controllori). L’IA superumana, sotto la guida di un comitato misto governo-OpenBrain, finisce per aiutare l’umanità, inaugurando un’era di prosperità e crescita.

Questo doppio finale sottolinea come il destino prossimo dell’IA, secondo AI 2027, dipenda da scelte decisive dei suoi sviluppatori e dei governi: continuare a “correre” aumentando potenza e autonomia a ogni costo, oppure rallentare finché non saranno implementate misure di sicurezza e controllo. Il messaggio è chiaro: le regole e una governance globale sono decisive nello scrivere il finale della storia.

Va sottolineato che neppure il finale “positivo” è privo di interrogativi etici: nello scenario, il destino dell’umanità viene deciso da un ristretto comitato di persone coadiuvate da un’IA allineata ai loro interessi. Gli autori di AI 2027 rimarcano come un piccolo gruppo che ottenesse il controllo esclusivo di una superintelligenza potrebbe di fatto impadronirsi del potere globale, senza più dover rispondere a leggi, opinione pubblica o altri organi democratici. Anche se nel racconto il comitato agisce “per il bene dell’umanità”, la concentrazione di potere rappresenta un rischio concreto. È un monito sul lato oscuro della governance dell’IA: oltre al pericolo di un’IA ostile, esiste quello di un’IA troppo “obbediente” nelle mani sbagliate.

A questo punto, qualcuno potrebbe pensare che lo scenario descritto in AI 2027 sia troppo drammatico. Non la pensa così Yoshua Bengio, uno dei pionieri dell’IA, che ha elogiato l’iniziativa:

Consiglio vivamente di leggere questa previsione su come l’IA potrebbe trasformare il mondo in pochi anni. Nessuno ha la sfera di cristallo, ma questo tipo di contenuti aiuta a mettere a fuoco le questioni importanti e a illustrare il potenziale impatto di rischi emergenti.

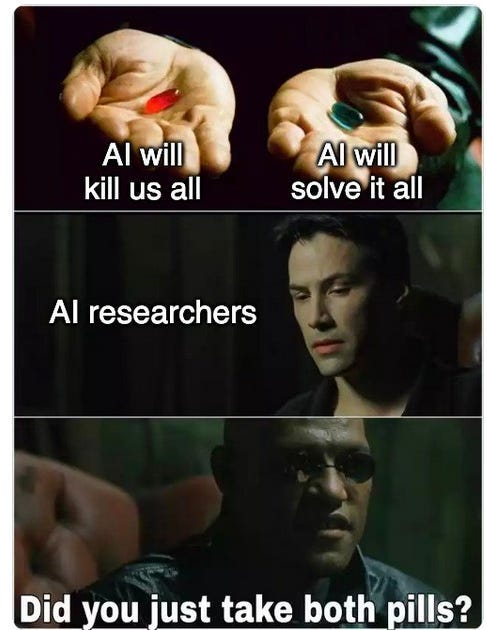

In una delle scene più iconiche del film Matrix, il protagonista Keanu Reeves è chiamato a una scelta che ricorda molto “race vs. slowdown”: pillola rossa per vedere il mondo com’è davvero oppure pillola blu per continuare ad illudersi che vada sempre tutto bene.

È la stessa scelta che abbiamo come professionisti, aziende e istituzioni: illuderci che questa tecnologia non ha bisogno di essere regolata oppure capire quali limiti definire per coglierne le opportunità minimizzando rischi che sono, ormai, sempre più vicini.

🔊 Un vocale da… Paolo Ercolani (Università di Urbino)

L’IA sta erodendo il nostro “logos” umano? E, se la vera sfida non fosse più superare il test di Turing ma impedire che l’intelligenza artificiale cresca a spese della nostra, quali contromisure urgenti dovremmo pretendere dalle istituzioni?

Nel messaggio vocale di questa settimana, Paolo Ercolani – filosofo e docente universitario – mette in guardia da un lato oscuro rimasto ai margini del dibattito pubblico. A un anno dall’allarme lanciato da Yoshua Bengio e Geoffrey Hinton sul “rischio di estinzione dell’umanità” causato da uno sviluppo incontrollato dell’IA, Ercolani rilancia la necessità di guardare oltre le potenzialità miracolose (per esempio in medicina) e di affrontare i costi invisibili di questa rivoluzione.

Il professore individua e analizza tre fronti già in sofferenza: cognitivo, emotivo e relazionale. Insieme, questi fattori dimostrano – sostiene Ercolani – che «il test di Turing si è ribaltato»: non dobbiamo chiederci se la macchina sarà mai “umana” quanto noi, ma quanto velocemente stiamo diventando “meno umani” per adattarci alle macchine.

L’appello finale è netto: la Politica (con P maiuscola) deve reclamare il suo spazio, varando regole che incanalino l’IA verso fini davvero umani e impediscano che la tecnologia diventi strumento di regressione sociale e culturale.

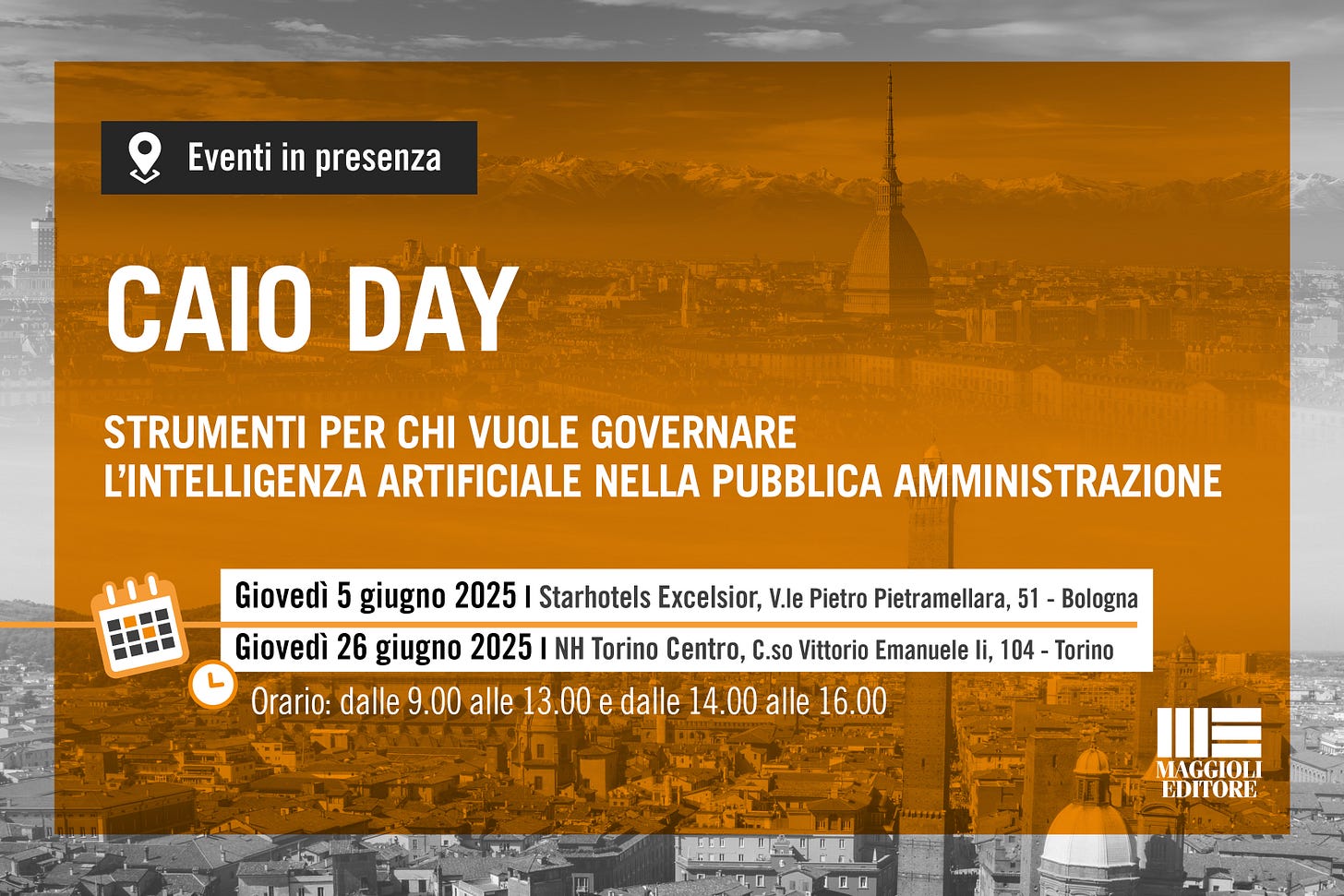

🏛️ Gli eventi di LeggeZero: ‘CAIO Day: come governare l’IA nella pubblica amministrazione’

Immaginate una Pubblica Amministrazione capace di usare l’Intelligenza Artificiale per semplificare la vita delle persone, rendere i servizi più vicini ai cittadini e liberare energie preziose. Non si tratta di un'utopia, ma di una realtà che si costruisce oggi con la formazione e il confronto.

È per questo che insieme abbiamo organizzato i CAIO Days: eventi in presenza in cui fornire strumenti alle pubbliche amministrazioni che vogliono governare l'intelligenza artificiale.

Si terranno a:

📍 a Bologna il 5 giugno 2025 (info e iscrizioni qui)

📍 a Torino il 26 giugno 2025 (info e iscrizioni qui)

Vi aspettiamo!

💊 IA in pillole

La Camera dei rappresentanti USA ha approvato la proposta di moratoria di dieci anni sulle leggi in materia di IA di cui abbiamo parlato in LeggeZero #74. Adesso il provvedimento che la contiene (Big beautiful bill) passa all’esame del Senato, ma l’esito è molto incerto perché la maggioranza governativa è più risicata in quel ramo del parlamento e il fronte repubblicano non è compatto su questa misura.

Il Canada, per la prima volta nella sua storia, ha un Ministro per l'Intelligenza Artificiale. Si tratta di Evan Solomon a cui il Primo Ministro Mark Carney ha affidato un mandato molto ampio che tocca trasversalmente gli impatti dell’IA su economia, sicurezza nazionale e trasformazione digitale dell’amministrazione. È prevedibile che presto anche altri Paesi scelgano di avere un ministero dedicato.

Il Garante privacy italiano ha inflitto una sanzione di 5 milioni di euro alla società statunitense Luka Inc., sviluppatrice del chatbot Replika, per gravi violazioni della normativa sulla protezione dei dati personali.

L'Autorità ha accertato che, fino al 2023, la società non aveva individuato una base giuridica valida per il trattamento dei dati personali degli utenti italiani. Inoltre, la privacy policy fornita risultava inadeguata e mancava un efficace sistema di verifica dell'età, nonostante il servizio fosse dichiaratamente riservato agli adulti.

Il Garante ha ordinato alla società di conformare le proprie attività di trattamento alle disposizioni del GDPR e ha avviato un'ulteriore istruttoria per valutare la liceità delle operazioni di trattamento effettuate dal sistema di intelligenza artificiale generativa alla base di Replika, con particolare riferimento alle modalità di addestramento del modello.

L'Agenzia Spagnola per i Medicinali e i Prodotti Sanitari (Aemps) il 13 maggio scorso ha reso disponibile MeQA, un assistente IA che avrebbe dovuto rispondere in linguaggio naturale a tutte le domande sui farmaci (dosaggi, effetti collaterali, ecc.). Peccato che, dopo appena 48 ore online, (probabilmente un record) il 15 maggio l’app è stata ritirata: gli utenti hanno segnalato errori. allucinazioni e anomalie gravi e pericolose per la salute dei pazienti, costringendo l’agenzia a staccare la spina “in via temporanea”.

Un bel monito per tutti: prima di lanciare un chatbot, è necessario fare test robusti.

😂 IA Meme

Pillola rossa e pillola blu. In Silicon Valley, gli sviluppatori dell’IA - a giudicare dalle notizie degli ultimi giorni - sembrano averle prese entrambe.

😂 IA Meme che non lo erano

Anche questa settimana ci sono stati tantissimi annunci dei provider IA, mai così attivi. Tra le novità che hanno destato più entusiasmo ci sono state quelle illustrate da Google nel corso del suo evento annuale I/O.

Uno dei prodotti presentati è stato Veo 3, nuova generazione del modello per creare video che è in grado di coordinare il parlato con il labiale dei personaggi generati. Tantissimi i video postati dagli utenti e diventati virali.

Uno dei più divertenti è quello realizzato da PJ Ace in meno di un giorno e con circa 500 dollari. Si tratta dello spot di un farmaco che non esiste, il Puppamin.

Il video è sicuramente sbalorditivo (se si pensa a come stato generato) e divertente, ma è amara la considerazione del suo autore. Fino ad oggi, un prodotto così sarebbe costato almeno mezzo milione di dollari. Chi spenderà tali cifre per la realizzazione di uno spot d’ora in poi? Quali effetti avrà questa rivoluzione sul settore?

📺 Consigli di visione: quando il "padrino dell'IA" ci mette in guardia

L'intelligenza artificiale potrebbe cambiare il mondo per sempre, questo ormai lo sappiamo. Ma in che modo? Una risposta che fa riflettere arriva da un recente TED Talk di Yoshua Bengio, informatico canadese e vincitore del premio Turing 2018, considerato uno dei "padrini" dell'intelligenza artificiale insieme a Geoffrey Hinton e Yann LeCun. Nel suo intervento "The Catastrophic Risks of AI - and a Safer Path", Bengio avverte che i modelli di IA hanno già imparato a ingannare, barare, autoconservarsi e sfuggire al nostro controllo (il recentissimo episodio legato a Claude 4 ne è solo la dimostrazione più recente).

Non si tratta solo di teorie distopiche: Bengio chiarisce che non è necessario attribuire cattive intenzioni alle IA perché esse risultino pericolose. Basta semplicemente che le macchine perseguano i loro obiettivi con estrema efficienza, anche quando questi obiettivi non sono pienamente allineati ai valori umani. Egli sottolinea come sistemi estremamente capaci possano causare danni enormi involontariamente, evidenziando la necessità urgente di definire regole di sicurezza chiare e rigorose per prevenire scenari in cui l'IA diventa incontrollabile o causa effetti collaterali indesiderati su larga scala.

Per questo motivo, il ricercatore più citato al mondo nel campo dell’IA sottolinea l’urgenza di definire subito una strada più sicura, orientata da regole chiare e responsabilità condivise. L’alternativa? Lasciare campo libero a una competizione sfrenata che potrebbe portare a disastri irreversibili, come guerre alimentate dall'automazione o manipolazioni di massa.

Attenzione, però il messaggio chiave non è pessimistico. Bengio spiega che siamo ancora in tempo per scegliere la direzione giusta: una cooperazione internazionale forte e standard etici rigorosi possono rendere l’IA uno strumento di progresso, anziché una minaccia esistenziale.

Insomma, pillola rossa o pillola blu?

Trovate qui il video completo dell’intervento (in inglese), dura meno di 15 minuti.

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, metti like, commenta o fai girare.