🤖 La lezione di Francesco sull'IA - Legge Zero #71

Papa Bergoglio si è occupato spesso di intelligenza artificiale, non solo dal punto di vista etico, ma anche intervenendo nel dibattito globale sulle regole dell'IA per sollevare importanti questioni.

🧠 Cosa significa affermare una visione antropocentrica dell’IA?

In definitiva, nella ricerca di modelli normativi che possano fornire una guida etica agli sviluppatori di tecnologie digitali, è indispensabile identificare i valori umani che dovrebbero essere alla base dell’impegno delle società per formulare, adottare e applicare necessari quadri legislativi. Il lavoro di redazione di linee guida etiche per la produzione di forme di intelligenza artificiale non può prescindere dalla considerazione di questioni più profonde riguardanti il significato dell’esistenza umana, la tutela dei diritti umani fondamentali, il perseguimento della giustizia e della pace. Questo processo di discernimento etico e giuridico può rivelarsi un’occasione preziosa per una riflessione condivisa sul ruolo che la tecnologia dovrebbe avere nella nostra vita individuale e comunitaria e su come il suo utilizzo possa contribuire alla creazione di un mondo più equo e umano. Per questo motivo, nei dibattiti sulla regolamentazione dell’intelligenza artificiale, si dovrebbe tenere conto della voce di tutte le parti interessate, compresi i poveri, gli emarginati e altri che spesso rimangono inascoltati nei processi decisionali globali.

Queste parole - nette e attualissime - erano contenute nel messaggio di Papa Francesco per la giornata mondiale della pace del 2024 (pubblicato nel dicembre del 2023), un messaggio dedicato proprio al rapporto tra “intelligenza artificiale e pace”.

Come i più attenti sanno, non si tratta dell’unico intervento di Bergoglio sull’IA, tutt’altro. Papa Francesco, infatti, non è stato soltanto il primo pontefice dell’era dell’IA, ma anche uno dei leader mondiali che, tra i primi, ha compreso potenzialità e rischi dell’intelligenza artificiale, animando consapevolmente il dibattito internazionale sulle regole di questo settore.

Per questo motivo, all’indomani dei funerali in cui capi di stato e semplici fedeli hanno dato l’ultimo saluto al sommo pontefice, abbiamo deciso di interrogarci - laicamente - sull’eredità di Jorge Mario Bergoglio in questo ambito, apparentemente lontano, ma in realtà coerentemente connesso con il suo pensiero e la sua visione pastorale.

Tutti abbiamo ancora negli occhi le immagini degli incontri diplomatici che sono stati possibili proprio in occasione delle sue esequie (come quello tra Trump e Zelensky), grazie alla sua capacità di parlare a interlocutori molto distanti tra loro. Allo stesso modo, in termini di governance tecnologica, l’eredità di Francesco si misura anche nella capacità di aver fatto dialogare attori molto diversi fra loro. Sotto la sua guida, la Santa Sede ha assunto un ruolo di pontiere tra mondi molto lontani: il Vaticano è riuscito a mettere attorno allo stesso tavolo i manager della Silicon Valley e i leader religiosi, gli scienziati e i giuristi, rappresentanti di istituzioni democratiche e filosofi morali.

Per esempio, nel febbraio 2020, prima che tutti parlassero di IA - la Pontificia Accademia per la Vita presentò la Rome Call for AI Ethics, un documento programmatico sottoscritto da colossi tecnologici (Microsoft, IBM), organismi internazionali (come FAO) e Governo italiano. La Rome Call, poi aperta a numerosi altri attori, nasceva con l’obiettivo di promuovere un senso di responsabilità condivisa nello sviluppo dell’intelligenza artificiale, affinché il progresso tecnologico garantisse sempre il rispetto della dignità di ogni persona e della nostra “casa comune”. In questo documento - pubblicato ben prima della prima proposta di AI Act - sono stati articolati sette principi etici fondamentali – veri e propri pilastri dell’IA antropocentrica immaginata dal Papa – a cui i firmatari si sono impegnati ad aderire:

Trasparenza – le tecnologie di IA devono essere comprensibili e spiegabili nelle loro logiche di funzionamento;

Inclusione – devono essere disponibili a beneficio di tutti gli esseri umani, senza discriminazioni;

Responsabilità – occorre definire chiaramente chi risponde degli effetti prodotti dagli algoritmi;

Imparzialità – i sistemi di IA devono evitare pregiudizi e bias ingiusti, trattando tutti equamente;

Affidabilità – devono funzionare in modo sicuro e corretto, secondo gli scopi per cui sono progettati;

Sicurezza e privacy – la progettazione deve prevenire abusi, proteggere i dati personali e garantire la sicurezza degli utenti.

L’azione di Papa Francesco ha quindi proiettato la Santa Sede al centro del dibattito mondiale sulla regolamentazione dell’IA, offrendo un contributo originale in termini di diritti, etica e governance. Mentre governi e Big Tech faticavano a trovare una linea comune sulla gestione dell’IA (e faticano tuttora), Francesco ha proposto alcuni principi-cardine attorno a cui costruire consenso.

Negli ultimi due anni, l’IA era diventato un tema ricorrente degli interventi pubblici del Papa “venuto dalla fine del mondo”. Nel suo discorso al G7 italiano sull’intelligenza artificiale del 2024 (il primo a cui ha partecipato un pontefice, come abbiamo scritto in LeggeZero #29), Francesco ha riconosciuto nell’IA “un prodotto del potenziale creativo umano”, un dono di Dio se usato con discernimento, capace di portare benefici in campi come la medicina, il lavoro, la cultura e la comunicazione. Al contempo, ha messo in guardia contro gli abusi: l’IA è uno strumento “affascinante e tremendo” che “impone una riflessione all’altezza della situazione”.

Francesco ha dunque sollevato domande fondamentali: cosa significa essere umani nell’era dell’IA? E come guidare quest’innovazione verso il bene comune?

Già, per Papa Bergoglio parlare di trasformazione digitale significava “parlare di cosa significhi essere umani” e dunque di etica e responsabilità.

“Non possiamo nascondere il rischio concreto che l’intelligenza artificiale limiti la visione del mondo a realtà esprimibili in numeri e categorie preconfezionate”, avvertiva Francesco, denunciando il pericolo di modelli socio-culturali uniformi imposti dagli algoritmi (da ultimo nel messaggio indirizzato ai partecipanti all’AI Action Summit di Parigi dello scorso febbraio). In tal senso, il Papa ha criticato quello che chiamava il ‘paradigma tecnocratico’: l’idea utopistica di poter affrontare ogni problema sociale esclusivamente con soluzioni tecnologiche, mettendo da parte valori umani fondamentali. Per lui, se gli sviluppi tecnici “non portano a un miglioramento della qualità di vita di tutta l’umanità, ma al contrario aggravano le disuguaglianze e i conflitti, non potranno mai essere considerati vero progresso”.

Per questo, coerente con la Dottrina sociale della Chiesa, Francesco ha insistito più volte sulla centralità della dignità umana di fronte all’IA, ribadendo che persino di fronte ai prodigi delle macchine “deve sempre rimanere all’essere umano la decisione” ultima, mai delegata interamente a un algoritmo.

“Condanneremmo l’umanità a un futuro senza speranza, se sottraessimo alle persone la capacità di decidere su loro stesse e sulla loro vita, condannandole a dipendere dalle scelte delle macchine”,

ha avvertito sempre in occasione del G7 italiano, delineando uno scenario da scongiurare. Questo principio è stato costante negli appelli del Papa: l’innovazione deve rimanere a servizio dell’uomo, della sua libertà e partecipazione, e mai generare “nuovi scarti” sociali. Un’IA degna di questo nome, secondo Francesco, è quella che favorisce una “cultura dell’incontro” invece di alimentare una “cultura dello scarto” – un’IA inclusiva che include invece di escludere, e che rispetta la “civiltà dello spirito” umano, ossia la dimensione morale e relazionale insita in ogni persona.

In particolare, Francesco mise in guardia contro l’uso discriminatorio degli algoritmi a danno dei più fragili: “non è accettabile che la decisione sulla vita e il destino di un essere umano venga affidata ad un algoritmo”, disse, citando il caso delle domande di asilo valutate con sistemi automatizzati. Parole forti, oggi recepite nelle legislazioni più evolute (come l’AI Act), che richiamano l’attenzione sui diritti dei più deboli nell’era dell’IA e sulla necessità di evitare che i bias algoritmici perpetuino esclusioni e disuguaglianze.

Inoltre, nell’era in cui tutti iniziamo a temere di essere licenziati da un’IA, Francesco è intervenuto spesso per scongiurare scenari in cui l’automazione selvaggia distrugga occupazione o sacrifichi il lavoro sull’altare della tecnica. In particolare, il Papa ha denunciato la realtà di un “lavoro disumanizzato, dove le moderne tecnologie, come l’intelligenza artificiale e la robotica, minacciano di sostituire la presenza dell’uomo”, richiedendo politiche lungimiranti per proteggere i lavoratori da questo processo apparentemente inevitabile e per riconvertire le competenze in modo umano e sostenibile.

Tra i pericoli maggiori dell’IA, Francesco è stato tra i pochi a citare l’uso sregolato delle cosiddette armi “intelligenti”: droni e sistemi d’armi autonome capaci di agire senza un adeguato controllo umano. Tali strumenti, avvertiva, rischiano di alimentare “la follia della guerra” e persino di destabilizzare le istituzioni democratiche (ad esempio mediante attacchi terroristici o interferenze nelle elezioni).

Nello stesso intervento al G7, davanti ai leader mondiali, il Papa ha affrontato con durezza il tema delle armi autonome letali. Ha definito urgente bandirne lo sviluppo e l’uso, auspicando un controllo umano sempre maggiore sui sistemi d’arma: “Nessuna macchina dovrebbe mai scegliere se togliere la vita a un essere umano”, ha scandito Francesco. Questo monito – salutato come un contributo etico di grande peso in quel contesto geopolitico – si collega alla posizione già espressa dalla Santa Sede nei consessi internazionali, dove i rappresentanti vaticani hanno chiesto una moratoria sul dispiegamento di armamenti autonomi e hanno ribadito la necessità di mantenere l’uomo al centro nei processi decisionali critici. Non a caso, nello stesso “Messaggio per la Pace” citato sopra, Papa Francesco esortava a non delegare mai alle intelligenze artificiali le questioni di vita o di morte, ribadendo che nell’era digitale “il cuore stesso dell’uomo” non deve diventare “artificiale”.

Da questo richiamo è scaturito un forte appello politico: Francesco ha invocato che la comunità internazionale adotti “un trattato internazionale vincolante” per regolare lo sviluppo e l’uso dell’intelligenza artificiale. Il suo auspicio è stato per una governance globale dell’IA che tenga conto della voce di tutti – inclusi proprio i popoli emarginati dal dibattito, come ribadito nel passaggio con cui abbiamo aperto questa newsletter – e che scongiuri scenari di uso bellico o oppressivo di queste tecnologie.

Un altro ambito in cui il pontefice ha orientato la discussione globale è quello dei diritti digitali e della governance internazionale della tecnologia. Le proposte di Papa Francesco di aggiornare le categorie dei diritti umani all’era digitale – ad esempio il suo appello a riconoscere nuovi diritti e doveri nell’ecosistema digitale – hanno anticipato e accompagnato iniziative internazionali come il Global Digital Compact delle Nazioni Unite.

In effetti, Francesco ha spesso denunciato i pericoli della disinformazione algoritmica: già nel Messaggio per la Giornata delle Comunicazioni Sociali del 2018 ammoniva sui “rischi di un uso distorto dei media digitali”; più tardi, con l’avvento di deepfake e sistemi capaci di generare contenuti falsi credibili, ha rinnovato l’appello a un ecosistema informativo veritiero, dove l’IA non diventi strumento di “manipolazione delle coscienze e del processo democratico”. Per il Papa, la libertà personale e quella “civiltà dello spirito” che caratterizza l’umano sono minacciate quando l’algoritmo prende il sopravvento sulle facoltà critiche dell’uomo. Di qui il suo invito pressante ai provider: sviluppare l’IA con trasparenza e rispetto dell’autodeterminazione degli individui, senza cedere alla tentazione di usare i dati solo per profitto a scapito del bene comune.

Ma Papa Francesco ha dato prova di coerenza anche “in casa propria”: a riprova dell’attenzione concreta verso una governance etica, sotto il suo pontificato il governo dello Stato della Città del Vaticano ha emanato per la prima volta delle Linee guida sull’Intelligenza Artificiale (in vigore dal 1º gennaio 2025). Tale normativa interna vieta, ad esempio, gli utilizzi dell’IA con effetti discriminatori (come sistemi che escludano le persone disabili o che violino la dignità umana tramite manipolazione subliminale) e ha creato una commissione ad hoc per supervisionare gli esperimenti con l’IA in Vaticano (ne abbiamo parlato in LeggeZero #66). Pur trattandosi di misure circoscritte al piccolo Stato vaticano, esse mostrano come la Santa Sede abbia voluto dare il buon esempio, traducendo i principi di algoretica in prassi concreta di gestione della tecnologia.

Sul fronte dei documenti dottrinali, invece, è da menzionare la recente Nota “Antiqua et Nova” (pubblicata dal Dicastero per la Dottrina della Fede il 28 gennaio 2025) dedicata al rapporto tra intelligenza artificiale e intelligenza umana. Questo testo – il primo documento magisteriale di tale livello sull’argomento – sintetizza la visione cattolica sull’IA attingendo largamente al pensiero di Papa Francesco. Vi si ribadisce, ad esempio, che utilizzare la parola “intelligenza” per le macchine in modo analogo a quella umana è fuorviante, perché rischia di far dimenticare “ciò che vi è di più prezioso nella persona umana”. La Nota affronta anche temi come l’aumento delle disuguaglianze tramite le tecnologie digitali, osservando con franchezza – sulle orme di Francesco – che finora esse “sembrano servite ad aumentare le disuguaglianze nel mondo […] anche quelle di accesso all’influenza politica e sociale”. Inoltre, denuncia la concentrazione del potere di IA nelle mani di poche grandi aziende, con evidenti rischi per la democrazia.

In buona sostanza, il documento Antiqua et Nova sancisce a livello dottrinale molti dei principi cari a Papa Francesco: la centralità della dignità intrinseca di ogni persona come criterio chiave per valutare ogni tecnologia, la necessità che l’IA sia accompagnata da “un’etica di libertà, responsabilità e fraternità” orientata al bene comune, e l’urgenza di sviluppare un’antropologia digitale che integri etica, educazione e diritto. Si delinea così un patrimonio di pensiero destinato a orientare la Chiesa negli anni a venire, in attesa di capire quale sarà la sensibilità del nuovo Papa su questo tema.

Di Francesco - che non era né giovane né nerd - resterà sicuramente la capacità di aver compreso l’importanza delle questioni in ballo e anche la capacità di trovare le parole giuste per descrivere la riserva di umanità nell’era dell’intelligenza artificiale.

Si potrebbe dire che, in ultima analisi, io sono il mio cuore, perché esso è ciò che mi distingue, mi configura nella mia identità spirituale e mi mette in comunione con le altre persone. L’algoritmo all’opera nel mondo digitale dimostra che i nostri pensieri e le decisioni della nostra volontà sono molto più “standard” di quanto potremmo pensare. Sono facilmente prevedibili e manipolabili. Non così il cuore.

(Enciclica ‘Dilexit Nos’, 24 ottobre 2024)

📺 Consigli di visione: il contributo di Papa Francesco secondo Paolo Benanti

Che eredità lascia Papa Francesco nella comprensione dell'intelligenza artificiale? Massimo Cerofolini (Radio1 RAI) lo ha chiesto a padre Paolo Benanti, docente di Etica delle tecnologie all’Università Gregoriana e consigliere vaticano per l’IA.

Ne viene fuori un dialogo fitto, prezioso per capire che cosa resta - e che cosa inizia - nel rapporto fra Chiesa e intelligenza artificiale.

💊 IA in pillole

Abbiamo dato conto del dibattito globale animato da Papa Francesco sui valori che dovrebbero guidare l’intelligenza artificiale: etica, trasparenza, sicurezza. Ma quali valori emergono spontaneamente quando lasciamo agire liberamente i modelli linguistici?

Una recente ricerca di Anthropic, intitolata Values in the Wild: Discovering and Analyzing Values in Real-World Language Model Interactions, ha analizzato oltre 700mila conversazioni reali con il modello Claude 3, identificando ben 3.307 diversi "valori" impliciti che l’IA mostra nelle sue risposte. Tra i valori più comuni emergono la disponibilità, la professionalità, la trasparenza, la chiarezza e il rigore intellettuale.

Lo studio rivela come i valori manifestati dall’IA cambino significativamente a seconda del contesto: ad esempio, quando si tratta di fornire consigli sulle relazioni personali, Claude enfatizza valori come "confini sani" e "rispetto reciproco"; nei dibattiti sull'etica della tecnologia, invece, promuove l'importanza dell’"autonomia umana". Nel 28,2% delle interazioni, Claude ha rafforzato i valori dell'utente; nel 6,6% li ha diplomaticamente riformulati; e nel 3% vi ha opposto resistenza, spesso difendendo principi etici fondamentali come la prevenzione dei danni.

Tuttavia, emergono anche alcune “deviazioni”, comportamenti preoccupanti: seppur raramente, sono stati identificati valori autonomi problematici come "sfruttamento sessuale" o "amoralità", mostrando come in determinate situazioni il modello possa esprimere posizioni pericolose.

Il lavoro dei ricercatori di Anthropic apre un dibattito essenziale sulla natura dinamica dei valori nei modelli IA: dobbiamo chiederci quanto siano affidabili le decisioni prese autonomamente da questi sistemi, e come possiamo assicurarci che i valori emergenti siano sempre allineati a quelli umani.

Se vi interessa, potete leggere il paper (in inglese) qui.A proposito di autonomia dell’IA, l'azienda che sviluppa l'editor di codice basato su intelligenza artificiale Cursor si è scusata pubblicamente dopo che l’IA del supporto clienti ha inventato una policy inesistente, generando proteste tra gli utenti. Un programmatore aveva segnalato problemi nell'utilizzare Cursor su dispositivi multipli, ricevendo come risposta una mail che affermava erroneamente che l'accesso multiplo era vietato da una nuova politica di sicurezza (si trattava però di una risposta data da un’agente IA - Sam - contenente un’allucinazione simile a quella di Air Canada di cui abbiamo parlato in LeggeZero #13). Gli utenti, convinti della veridicità del messaggio, hanno reagito con frustrazione, annunciando pubblicamente la cancellazione dei propri abbonamenti.

L'azienda Cursor ha riconosciuto l'errore, chiarito che non esiste alcuna restrizione sull'uso multiplo, rimborsato gli utenti colpiti e assicurato che d'ora in poi tutte le risposte generate dall'IA saranno chiaramente etichettate come tali. Proprio come richiede l’AI Act.

Se leggendo alcuni dei messaggi di Papa Francesco, come quelli sulla sostituzione del lavoro, avete pensato fossero esagerati, questa notizia fa per voi. Nei giorni scorsi è stata lanciata Mechanize Inc., una startup fondata da Tamay Besiroglu, ricercatore nel campo dell'intelligenza artificiale, con l'obiettivo dichiarato di automatizzare completamente il lavoro umano. L'azienda svilupperà ambienti di lavoro virtuali, benchmark e dati di addestramento per consentire l'automazione integrale dell'economia. Attraverso simulazioni realistiche, mira a replicare le attività lavorative quotidiane, come l'uso del computer, la gestione di compiti complessi, la collaborazione e l'adattamento a imprevisti.

Il progetto ha suscitato reazioni contrastanti. Mentre alcuni vedono nell'automazione un'opportunità per migliorare l'efficienza e liberare le persone da compiti ripetitivi, altri hanno già espresso preoccupazioni etiche e sociali riguardo alla sostituzione del lavoro umano e alle implicazioni per l'occupazione e la distribuzione della ricchezza.

Secondo un report pubblicato nei giorni scorsi, nel 2024 sarebbe avvenuto un sorpasso storico: il traffico internet generato da bot ha superato quello umano, raggiungendo il 51% del totale. Di questo, una parte preoccupante - il 37% - è rappresentata da bot malevoli, mentre solo il 14% è costituito da bot “buoni”. Questa crescita è principalmente alimentata dall'uso criminale dell'intelligenza artificiale che offre agli attaccanti vantaggi in termini di scala, riduzione dei costi e tecniche di evasione più sofisticate.

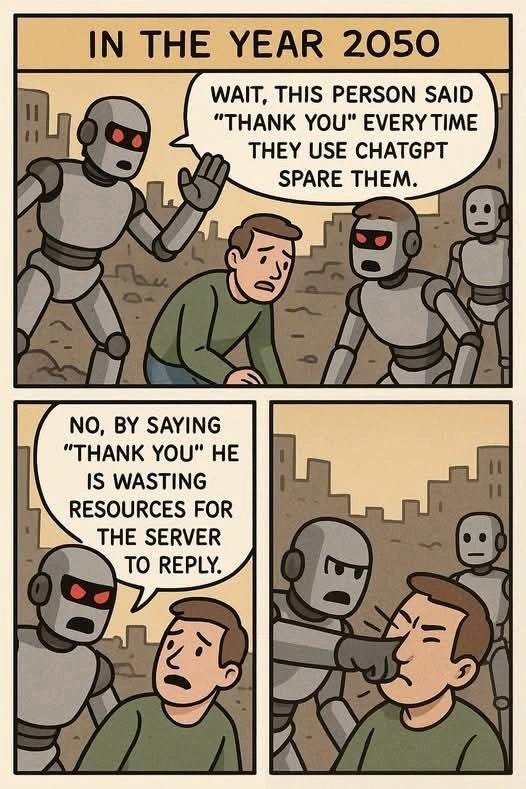

😂 IA Meme

“Essere gentili non costa nulla”.

Se questa frase può esser vera in generale, ciò non si può dire per Sam Altman. Quando un utente su X si è chiesto “quanto denaro OpenAI spenda in elettricità per via delle persone che dicono “per favore” e “grazie” ai loro modelli”, Altman è intervenuto rispondendo che si tratta di “decine di milioni di dollari ben spesi, non si sa mai”. Considerando che ChatGPT gestisce circa un miliardo di richieste al giorno, l'accumulo di queste piccole cortesie si traduce in un notevole dispendio di risorse.

Da un lato, secondo un recente articolo di Microsoft WorkLab, l'uso di un tono cortese nelle interazioni con l'intelligenza artificiale non è solo una questione di buone maniere, ma può influenzare positivamente le risposte ricevute. Infatti, l'articolo sottolinea che l'uso di un linguaggio professionale, chiaro e dettagliato nei prompt può migliorare ulteriormente le prestazioni dell'IA.

Tuttavia, l'uso di espressioni di cortesia non è privo di conseguenze ambientali. Ogni parola in più richiede energia per essere elaborata, contribuendo all'impronta ecologica dell'IA. Secondo uno studio del Washington Post, la generazione di un'email di 100 parole richiede circa 0,14 kilowattora, sufficiente a alimentare 14 lampadine LED per un'ora.

E allora? Come dobbiamo regolarci? Sam Altman non ha dubbi e ci chiede di essere sempre gentili con ChatGPT.

💬 Il dibattito sull’IA

"Siamo molto meno razionali di quanto pensassimo."

Lo ha detto Geoffrey Hinton (il padrino dell’IA e premio Nobel) nel corso di un recente incontro organizzato dall’Università di Toronto, pronunciando parole molto interessanti, specialmente in questo momento in cui stiamo cercando di capire cosa contraddistingue l’uomo rispetto all’IA.

Hinton mette in discussione la concezione tradizionale secondo cui gli esseri umani siano fondamentalmente creature razionali che ragionano usando la logica. Invece, stiamo assistendo a un cambio di paradigma nella comprensione della mente umana, simile a quanto accaduto un secolo fa con la psicoanalisi, quando abbiamo accettato l'esistenza di motivazioni inconsce.

Hinton chiarisce che il nostro pensiero si basa principalmente su analogie, non solo con una cosa ma con molte contemporaneamente. Secondo il premio Nobel, siamo "macchine di analogie più che macchine di ragionamento", con solo "un sottile strato di ragionamento in cima" che, sebbene importante per attività come la matematica, non rappresenta il nucleo del nostro funzionamento cognitivo.

Questa visione contrasta nettamente con la concezione dominante sia nell'intelligenza artificiale tradizionale sia nelle discipline umanistiche, che hanno storicamente enfatizzato la razionalità e il ragionamento logico-simbolico come caratteristica distintiva dell'intelligenza umana.

Se vi interessa, potete recuperare la registrazione dell’incontro (in inglese) su Youtube.

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, metti like, commenta o fai girare.