🤖Chi ha capito quello che sta succedendo? - Legge Zero #73

Il Cardinale Prevost ha scelto il nome di Papa Leone XIV come segno della centralità delle questioni sociali e dei conflitti sollevati dall'IA, mentre i legislatori di tutto il mondo sono in affanno.

🧠 Il nuovo conflitto sociale

L'ardente brama di novità che da gran tempo ha cominciato ad agitare i popoli, doveva naturalmente dall'ordine politico passare nell'ordine simile dell'economia sociale. E difatti i portentosi progressi delle arti e i nuovi metodi dell'industria; le mutate relazioni tra padroni ed operai; l'essersi accumulata la ricchezza in poche mani e largamente estesa la povertà; il sentimento delle proprie forze divenuto nelle classi lavoratrici più vivo, e l'unione tra loro più intima; questo insieme di cose, con l'aggiunta dei peggiorati costumi, hanno fatto scoppiare il conflitto. Il quale è di tale e tanta gravità che tiene sospesi gli animi in trepida aspettazione e affatica l'ingegno dei dotti, i congressi dei sapienti, le assemblee popolari, le deliberazioni dei legislatori, i consigli dei principi, tanto che oggi non vi è questione che maggiormente interessi il mondo.

Sono le parole che aprono la Rerum Novarum, l’enciclica pubblicata da Papa Leone XIII il 15 maggio 1891 che è ricordata come la prima “enciclica sociale”, quella che ha interpretato la questione operaia nata con la rivoluzione industriale e ha introdotto alcuni principi (bene comune, sussidiarietà, giusto salario, diritto di associazione) che sono diventati l’ossatura della dottrina sociale della chiesa.

134 anni dopo queste parole suonano però nuovamente attuali e potrebbero ben descrivere quello che sta accadendo a seguito della velocissima evoluzione dell’intelligenza artificiale. Ne è consapevole il nuovo Papa, Robert Francis Prevost che - al momento di scegliere il suo nome - ha optato per Leone XIV. È stato il nuovo pontefice a chiarire che in questa scelta c’entra l’intelligenza artificiale (potete sentirlo nel video qui sotto). Leone XIII aveva scritto la “Rerum Novarum” nel periodo in cui stava emergendo la questione operaia connessa all'industrializzazione della seconda metà del XIX secolo. Attualmente invece, la società si trova a dover affrontare una nuova rivoluzione tecnologica e gli avanzamenti dell'intelligenza artificiale, che "pongono nuove sfide per la protezione della dignità umana, della giustizia e del lavoro".

In altre parole, le “cose nuove” del nostro tempo sono le intelligenze artificiali, e la società – Chiesa compresa – inizia a interrogarsi su come guidare e governare questo cambiamento per il bene comune. Appena due settimane fa, in LeggeZero #71, ci interrogavamo su chi (e come) avrebbe raccolto la lezione di Papa Francesco sull’IA, adesso sappiamo che il suo successore ha deciso, in modo programmatico, di mettere l’IA al centro del suo impegno e potrebbe presto dedicarci un’apposita enciclica.

Attenzione a non fare l’errore di pensare che si tratti di una questione futura e marginale. Il conflitto, anzi i conflitti sono già qui e stanno esplodendo in tutta la loro concretezza, anche se il dibattito pubblico e politico fatica a tenere il passo.

Il primo riguarda la trasformazione del mondo del lavoro. Per capirlo è sufficiente mettere in fila alcuni annunci che vengono da alcune società USA (lo stesso Paese di cui è originario Leone XIV).

Il primo a scrivere ai suoi quasi 8mila dipendenti è stato, un mese fa, Tobi Lütke, fondatore e CEO di Shopify (società che gestisce una delle più importanti piattaforme di ecommerce). Nel memo interno ‘Reflexive AI usage is now a baseline expectation at Shopify’ - pubblicato su X e diventato quindi di dominio pubblico - ha chiarito che l’uso quotidiano dell’IA non è più una raccomandazione ma un obbligo: la capacità di dialogare con strumenti come ChatGPT, Claude, GitHub o Copilot entra nelle valutazioni di performance, e chi sceglierà di farne a meno, avverte il fondatore, “non crescerà e scivolerà verso il fallimento”. Lütke ricorda che questi tool sono già a disposizione di tutti, ma ritiene l’adozione ancora insufficiente; per colmare il divario impone una fase di prototipazione “AI-first”: ogni nuovo progetto dovrà partire chiedendosi come l’intelligenza artificiale possa accelerare il raggiungimento degli obiettivi. Il memo, inoltre, introduce anche un vincolo sulle assunzioni: prima di chiedere nuovo personale, i team dovranno dimostrare in modo credibile perché un agente IA non possa svolgere, in tutto o in parte, il lavoro che dovrebbe essere affidato alla nuova risorsa.

La policy di Shopify non è isolata. Una settimana fa Luis von Ahn, co‑fondatore e CEO di Duolingo (nota app di apprendimento linguistico), ha inviato ai circa 800 dipendenti una mail intitolata ‘Duolingo is going to be AI‑first’, subito pubblicata su LinkedIn e ripresa dalla stampa. Nel testo, il fondatore chiarisce che l’intelligenza artificiale non è più un optional ma “il nuovo cambio di piattaforma”: l’azienda “smetterà gradualmente di usare traduttori freelance per lavori che l’IA può gestire” (non ha rinnovato già contratti al 10% di loro), mentre la capacità di dialogare con modelli come ChatGPT o Claude finirà nei criteri di assunzione, nelle review di performance e persino nelle richieste di nuove risorse: “ci saranno nuove assunzioni solo se un team può dimostrare che non è possibile usare l’IA per quel lavoro”.

Von Ahn invita a muoversi “con urgenza, anche a costo di piccoli cali di qualità, perché aspettare l’IA perfetta significherebbe perdere il momento”.

Ma forse il più sincero di tutti è stato Micha Kaufman, co-fondatore e CEO di Fiverr (marketplace di freelance con circa 770 dipendenti) che inviato un’e-mail interna intitolata “AI is coming for your jobs”, poi pubblicata sul suo profilo X e ripresa dai media. Nel messaggio Kaufman adotta un tono di “radical candor”: annuncia che “l’IA arriverà per ogni ruolo, persino per il mio” e che le mansioni un tempo facili spariranno, mentre le difficili diventeranno la nuova normalità.

Non importa che tu sia programmatore, designer, product manager, data scientist, avvocato, addetto al supporto clienti, commerciale o contabile: l’IA saprà fare il tuo lavoro.

Per sopravvivere, spiega, “serve diventare talenti eccezionali”, cioè padroneggiare gli strumenti generativi – dal codice ai contratti– e trasformarsi in prompt-engineer, perché “Google è morto: LLM e IA generativa sono i nuovi fondamentali”. Chi ignora l’avvertimento, scrive Kaufman, finirà per “perdere il lavoro nel giro di pochi mesi”. Infine, anche il CEO esorta i team a fare di più, più in fretta e con le risorse che hanno già: prima di chiedere nuove assunzioni bisogna dimostrare di aver “spremuto” al massimo l’IA.

Fin qui la cronaca delle ultime settimane. E, va sottolineato, i CEO di Shopify, Duolingo e Fiverr non sono gli unici ad avere adottato nuove strategie di organizzazione del lavoro. Probabilmente sono solo tra i più trasparenti (nei confronti dei dipendenti e del mercato) e sicuramente ci aiutano a comprendere che - al momento - l’impatto dell’IA sul mondo del lavoro rischia di essere meno leggero di quanto qualcuno prevedeva (qui un articolo di Forbes sul punto), ponendo non solo questioni legate al numero dei posti di lavoro ma anche al benessere organizzativo e allo sfruttamento di dipendenti o collaboratori.

Partiamo dal benessere organizzativo. In alcune aziende, l’IA non è più soltanto un copilota: molte organizzazioni la stanno testando - oltre che per costringere i dipendenti ad aumentare al massimo la produttività (con ovvie conseguenze tossiche) - anche per ricoprire funzioni di vertice. Il rapporto State of AI di McKinsey rileva che oltre la metà delle organizzazioni con più di 500 milioni di fatturato la usa già per compiti manageriali. Cosa dobbiamo aspettarci da un capo IA? Ce lo stanno insegnando i primi esperimenti in giro per il mondo, come quelli della cinese NetDragon Websoft dove il CEO-avatar chiamato Tang Yu ha ridotto le inefficienze e gli sprechi, ma parte del personale ha lamentato un “distacco emotivo”, proprio come nella britannica DeepKnowledge dove il manager virtuale Vital ha fatto salire la produttività dei team remoti, lasciando i dipendenti (umani) senza manifestare fiducia o sostegno motivazionale.

Come se ciò non bastasse, si iniziano a registrare alcuni casi di distopico sfruttamento: attori o modelli che, per pochi dollari o per necessità, cedono il proprio volto a piattaforme IA (come Synthesia) e scoprono - troppo tardi - di aver perso ogni controllo sulla propria immagine. Due casi su tutti:

Simon Lee, attore sudcoreano: quando ha ceduto la sua immagine pensava di comparire in spot innocui, ma si è ritrovato ad essere il testimonial di cure miracolose su TikTok e Instagram. Il contratto – che ha firmato concedendo il diritto a usare la sua immagine – gli impedisce di far rimuovere i video che lui stesso definisce come truffaldini.

Connor Yeates, modello e performer britannico: nel 2022, mentre aveva problemi economici (e dormiva sul divano di un amico), firmò un accordo triennale con Synthesia per poco più di 5mila dollari. Ha poi scoperto che il suo avatar è stato utilizzato per sostenere un colpo di stato in Burkina Faso, un uso apertamente propagandistico e contrario alle stesse policy della piattaforma IA.

Insomma, l’esplosione delle tecnologie di IA, soprattutto generativa, hanno aperto diversi fronti (oltre a quelli affrontati sopra, in tanti numeri di LeggeZero abbiamo già parlato delle criticità dal punto di vista del diritto d’autore o del trattamento dei dati personali). Sia chiaro: non è colpa della tecnologia, ma dell’uso che singoli, società o governi fanno di questi potentissimi strumenti. Di fronte a questa realtà, è urgente porci una domanda: la società è preparata ad ad affrontare questi conflitti? Quanti sono i politici e i decisori che - come Leone XIV - hanno già compreso la centralità e l’urgenza di questi argomenti? E poi, di fronte a cambiamenti così rapidi, quali sono le leggi più adeguate a fronteggiare questa nuova realtà in modo equo e non discriminatorio?

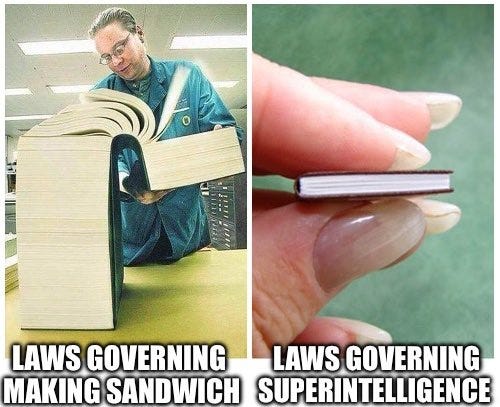

I casi citati mostrano come l’IA stia già rivoluzionando lavoro e società, anticipando i legislatori che sono chiamati ad evitare i danni (sociali, economici e culturali) del soluzionismo tecnologico. La nostra mappa mondiale sulle leggi dell’IA (che trovate qui aggiornata) dimostra che in tutto il mondo si sta cercando di regolare l’intelligenza artificiale, anche se l’impressione è che le norme fin qui adottate presentino limiti e ritardi.

La difficoltà di dettare regole per una tecnologia che è in costante crescita e sta cambiando tutti i settori della società sembra l’unico comune denominatore tra approcci molto diversi come quelli di UE e USA. Regole strutturate (come l’AI Act europeo) o norme specifiche (come le leggi dei singoli stati americani su deepfake elettorali e revenge porn) appaiono entrambe non adeguate rispetto alla velocità di tale rivoluzione. Basti pensare che le norme sui sistemi ad alto rischio dell’AI Act - la norma che secondo tutti è la più organica al mondo - troveranno piena applicazione non prima di agosto 2026, una data che sembra lontanissima ed entro la quale la tecnologia avrà raggiunto standard difficilmente immaginabili, l’IA continuerà ad essere integrata ovunque (spesso in modi imprevisti) e sarà sempre più difficile e cruciale comprendere il ruolo dell’essere umano nei processi lavorativi, produttivi, creativi e comunicativi.

Dopo la macchina a vapore vennero le prime leggi sul lavoro, dopo l’avvento di Internet si intervenne su privacy e cybercrime. Oggi, di fronte all’IA, siamo all’alba di una nuova “questione sociale”. L’auspicio è che il riferimento a Leone XIII e alla Rerum Novarum non resti un semplice simbolo, ma stimoli davvero una riflessione collettiva su come riequilibrare il rapporto tra tecnologia e lavoro nell’era digitale. Potrebbe voler dire ripensare i sistemi educativi per formare alle competenze del futuro, creare reti di protezione (come redditi minimi o supporto alla riqualificazione professionale) per chi sarà più colpito dall’automazione, e aggiornare continuamente le normative man mano che l’IA evolve (basti pensare alle nuove sfide poste da algoritmi generativi come ChatGPT, sconosciuti solo pochi anni fa).

L’unico errore che non possiamo permetterci è stare fermi o, peggio, fare come gli struzzi e lasciare che lo sviluppo tecnologico (e chi lo governa) decidano quali evoluzioni avrà la nostra società.

📰 250 CEO scrivono un appello per rendere l’informatica (e l’IA) materia obbligatoria in tutte le scuole USA 🇺🇸

Che succederebbe se bastasse un solo corso di informatica per assicurare agli studenti un futuro stipendio più alto dell’8 %? A questa domanda prova a rispondere l’iniziativa Unlock 8 lanciata da CSforALL e Code.org. Nella lettera aperta, un fronte di oltre 250 amministratori delegati (Microsoft, Adobe, American Airlines, AMD, Airbnb, Uber, Salesforce, ecc.) chiede ai 50 Stati USA di inserire l’informatica – e l’intelligenza artificiale – tra le materie obbligatorie delle superiori.

La spinta viene da uno studio Brookings: chi segue anche solo un corso introduttivo di informatica guadagna in media l’8 % in più, a prescindere dal percorso di carriera o dall’università (con un potenziale economico di oltre 660 miliardi di dollari all’anno). Oggi però solo 12 stati USA richiedono la materia per diplomarsi, il resto la considera opzionale, con il risultato che la maggior parte degli studenti non la sperimenta nemmeno.

Secondo i firmatari dell’appello, mentre Brasile, Cina, Corea del Sud, Emirati Arabi e Singapore hanno già reso obbligatorie competenze di coding o IA a scuola, gli Stati Uniti rischiano di restare indietro non solo come hub tecnologico, ma anche nella riduzione dei gap salariali. Il Presidente Trump nei giorni scorsi ha firmato un executive order per promuovere l’educazione sull’IA dei ragazzi americani, ma la competenza sul sistema scolastico è dei singoli Stati.

Da qui l’appello: trasformare tutti i ragazzi in “creator, not just consumers” (creatori, non solo utenti) di intelligenza artificiale.

Perché è un’iniziativa da tenere d’occhio?

l’appello ha già l’endorsement di big tech e di leader repubblicani e democratici: potrebbe trasformarsi ben presto in proposte di legge nei singoli Stati;

l’argomento salariale è facile da capire per famiglie e imprese, quindi è probabile che si assisterà ad un’accelerazione di partnership scuole-aziende per sperimentazioni, formazione e tutor IA;

insegnare IA a scuola rende necessarie linee guida e indicazioni su sicurezza, bias e privacy già in età scolare.

E in Italia? Per il momento, ci risulta solo una proposta legislativa dell’On. Chiara Tenerini (FI) per l’introduzione di un’ora settimanale di IA a partire dalle scuole medie.

⚖️ Il Governo italiano 🇮🇹 apre una consultazione sulle Linee Guida per l’implementazione dell’IA nel mondo del lavoro

È stato recentemente pubblicato dal Ministero del Lavoro e delle Politiche Sociali il documento "Linee guida per l’implementazione dell’intelligenza artificiale (IA) nel mondo del lavoro", sottoposto a consultazione pubblica fino al 21 maggio 2025.

Le Linee guida - che non saranno un documento vincolante - offrono indicazioni pratiche e operative per le aziende, in particolare le PMI, e per i lavoratori autonomi, con l’obiettivo di favorire un'adozione responsabile e sicura dell’IA (es. nell’ambito della selezione e gestione del personale), sottolineando la necessità di conformità alle normative europee (come l’AI Act e il GDPR) e internazionali (quali i principi OCSE e UNESCO).

Il documento definisce i principi guida per un uso etico e responsabile dell'IA, evidenziando trasparenza, supervisione umana, equità, non discriminazione e sicurezza dei lavoratori. Inoltre, identifica le principali fasi per l'integrazione dell'IA nei processi aziendali, dal design alla dismissione, con attenzione particolare alla formazione continua e allo sviluppo delle competenze digitali dei lavoratori (interessante anche la sezione dedicata a finanziamenti e incentivi).

Tra gli aspetti più importanti, emerge con particolare rilevanza il principio della supervisione umana sull’IA. Le Linee guida chiariscono che tutte le decisioni prese tramite sistemi automatizzati dovrebbero essere sottoposte al controllo e alla validazione di persone fisiche che ne comprendano le implicazioni. Tale supervisione, imposta anche dal GDPR per le decisioni interamente automatizzate, deve essere realizzata tramite specifici contratti di lavoro che tutelino adeguatamente la figura del supervisore umano.

Questa supervisione richiederà necessariamente interventi organizzativi significativi, quali la revisione dei processi produttivi per assicurare autonomia, esclusione di vincoli gerarchici e assenza di conflitti di interesse per il supervisore. È anche suggerita l'elaborazione di contratti che prevedano esplicitamente prerogative e tutele contro eventuali ritorsioni, visto il delicato ruolo del supervisore umano che, tra l'altro, può smentire i risultati degli algoritmi o addirittura interrompere il funzionamento dei sistemi IA.

Le Linee guida, che prevedono anche l'istituzione di un Osservatorio per monitorare l'impatto dell'IA sul mercato del lavoro (così come contemplato anche dal DDL italiano sull’IA), sono aperte alla consultazione per raccogliere feedback e contributi utili alla loro versione definitiva.

È possibile partecipare alla consultazione tramite la piattaforma ParteciPa, compilando un questionario oppure inviando un documento all'indirizzo: DipartimentoLavoro@lavoro.gov.it.

Per approfondire e partecipare alla consultazione, potete scaricare il documento qui.

😂 IA Meme

Ecco un meme che potete utilizzare per rispondere al prossimo amico o collega che vi dice che ci sono troppe norme sull’intelligenza artificiale.

😂 meme IA … che non lo erano

È diventato virale un video che mostra un robot umanoide, il modello H1 dell'azienda cinese Unitree Robotics, che durante un test in laboratorio ha iniziato a muoversi in modo incontrollato, spaventando i tecnici presenti. L'incidente è avvenuto a Hangzhou e le immagini, riprese dalle telecamere di sicurezza, mostrano il robot che, sospeso a una gru, improvvisamente inizia ad agitare braccia e gambe con movimenti frenetici, colpendo oggetti e causando il panico tra gli ingegneri. Tuttavia, secondo gli esperti, non si sarebbe trattato di una "ribellione" del robot, ma di un malfunzionamento causato da una fune di sicurezza legata alla sua testa. Questa fune ha interferito con il sistema di bilanciamento del robot, facendogli credere di essere in caduta libera e attivando movimenti che sono apparsi violenti e incontrollati.

L'incidente ha sollevato preoccupazioni sull'affidabilità e la sicurezza dei robot umanoidi, evidenziando la necessità di protocolli di sicurezza più rigorosi.

📣 Eventi

Agentforce World Tour- Milano, 29.05.2025

CAIO Day - Governare l’IA nella pubblica amministrazione - Bologna, 05.06.2025

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, metti like, commenta o fai girare.

In un mondo dove la conoscenza verticale viene completamente affidata alle macchine, sopravvivrà solo chi sviluppa conoscenze orizzontali