🤖 Ti fidi di me? – Legge Zero #10

ChatGPT e gli altri sistemi di IA generativa sono sicuri? Le notizie sui loro bug devono farci riflettere sulla necessità delle regole (e su cosa condividere nelle nostre conversazioni con i chatbot)

🧠 Non dirlo a ChatGPT

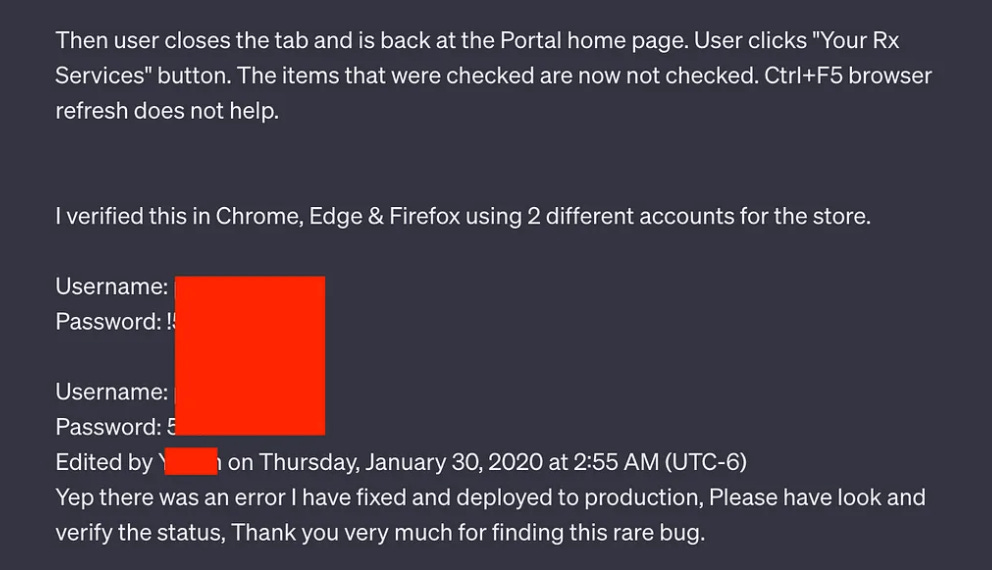

Chase Whiteside stava usando ChatGPT al quale aveva chiesto un suggerimento per “nomi ingegnosi per i colori di una tavolozza”. Mentre il chatbot elaborava la risposta, si è allontanato dal PC e quando è tornato ha trovato una strana sorpresa: poteva visualizzare nella sua cronologia alcune conversazioni che non aveva mai iniziato e che non c’entravano niente con i suoi prompt. Come ha raccontato ad Ars Technica, in queste conversazioni erano riportati ticket di assistenza di un portale di farmacie, un porzione di codice e le credenziali di accesso a un sito web. OpenAI ha subito fatto sapere che si tratta di un caso di frode e non di un malfunzionamento, sostenendo che le credenziali di accesso all’account dell’utente sarebbero state compromesse e che un attaccante avrebbe usato l’account per avviare le conversazioni.

Eppure non è la prima volta che i sistemi di IA generativa (ChatGPT in primis) vengono accusati di divulgare, sia pur involontariamente, dati e informazioni destinati a rimanere riservati. Poche settimane fa, alcuni ricercatori hanno reso noto che attraverso parole chiave specifiche, denominate “attack”, è possibile indurre i sistemi di IA a rivelare ampie parti dei dati di addestramento, incluse informazioni sensibili o riservate.

Le implicazioni sono evidenti sia in termini di privacy che di protezione del know how aziendale. Per questo motivo, Apple e Samsung sono state tra le prime aziende a limitare l’uso di sistemi di IA generativa per evitare che informazioni riservate inserite dai dipendenti nei propri prompt potessero divenire di dominio pubblico (nel caso di Samsung a causa di un bug di ChatGPT è stata divulgata una porzione di codice di un software aziendale). Sono tantissime le organizzazioni pubbliche e private che stanno seguendo il loro esempio, adottando policy che vietino ai dipendenti l’utilizzo di tutte le versioni dei sistemi di IA che utilizzino le informazioni aziendali (e i prompt) per addestrare i modelli.

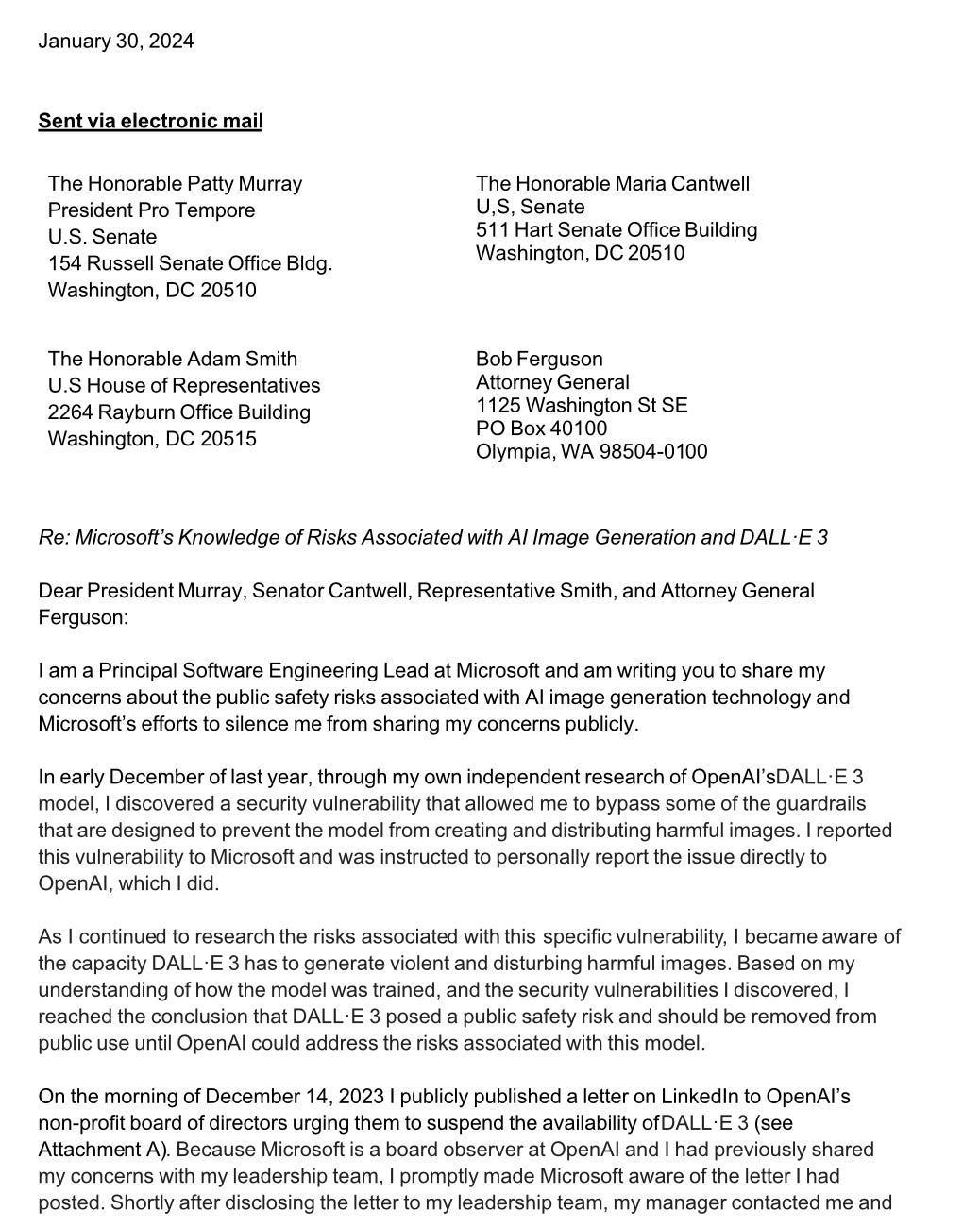

Quelli legati alla perdita di riservatezza non sono gli unici rischi dei sistemi di IA generativa: al centro di alcune delle notizie più importanti degli ultimi giorni ci sono anche altri problemi di sicurezza. Un dirigente di Microsoft, Shane Jones, in una lettera al procuratore generale dello stato di Washington e ai rappresentanti del Congresso, ha sostenuto di aver scoperto a dicembre delle vulnerabilità in DALL-E 3, il generatore di immagini con l’intelligenza artificiale generativa sviluppato da OpenAI (molto probabilmente usato dagli autori del deepfake di Taylor Swift). Queste falle nel sistema consentirebbero agli utenti di infrangere le protezioni di sicurezza per creare immagini violente ed esplicite.

È notizia sempre di pochi giorni fa quella che riguarda Europecar, la nota azienda di autonoleggio. I dati di 50 milioni di utenti - divulgati a seguito di un presunto data breach subito dalla società - sarebbero stati, a detta di Europecar, generati da IA e quindi non ci sarebbe stata nessuna violazione. L’attaccante non avrebbe, cioè, esfiltrato dei dati ma li avrebbe creati, utilizzando l’IA, in modo da ricattare comunque la società o provocarle un danno reputazionale.

Anche questa è chiaramente una vicenda che ci fa capire quanti e quali rischi potenziali si nascondono nell’utilizzo non responsabile dell’IA, generativa e non. Ed è questo anche uno dei motivi per cui servono le norme che impongano a chi sviluppa sistemi di IA non solo di essere trasparente su modalità di addestramento e controlli, ma anche di adottare misure in materia di mitigazione dei rischi sistemici e sicurezza informatica. L’AI Act (che come scriveremo più avanti è sempre più vicino) va in questa direzione così come l’executive order adottato dal Presidente USA Biden nell’ottobre del 2023.

Bisogna però sottolineare che così come i malintenzionati possono sfruttare l’intelligenza artificiale a loro favore, analogamente tali tecnologie possono essere utilizzate altresì per incrementare la sicurezza dei sistemi e dei dati di amministrazioni e imprese. L’utilizzo efficace dell’IA facilita il livello della comprensione delle minacce ed integra rapidamente la conoscenza dei “difensori” per combattere alla pari (o quasi) con gli attaccanti. L’IA difensiva apprende ciò che è normale per un’organizzazione ed è in grado di rilevare attività anomale e potenzialmente pericolose non appena si manifestano anche se mai individuate in precedenza.

Anche in questo caso è necessario agire non solo da un punto di vista tecnologico ma pure da quello normativo. In questo senso deve leggersi la recente proposta di legge in materia di cybersicurezza approvata dal Governo e che passerà ora all’esame del Parlamento. Il DDL introduce disposizioni per innalzare il livello di prevenzione e di contrasto dei reati informatici e il coordinamento degli interventi delle autorità in caso di attacchi informatici alle infrastrutture critiche, aumentando la consapevolezza delle pubbliche amministrazioni sulle minacce.

Nella versione iniziale del provvedimento era presente una norma specifica sulle funzioni dell’Agenzia per la cybersicurezza nazionale (ACN) con lo scopo di consentire alla stessa ACN di promuovere e sviluppare ogni iniziativa volta a valorizzare l’IA come risorsa per il rafforzamento della cybersicurezza nazionale e favorire un suo uso etico e corretto.

Non sappiamo ancora se la norma sarà presente nella versione finale del disegno di legge, magari potrebbe prevalere la scelta di rinviare ogni decisione al momento in cui sarà definita la governance italiana in materia di IA. Non c’è molto tempo per le scelte, però: per stare al passo degli attaccanti è necessario tenere alto il livello dell’attenzione, dei singoli, delle organizzazioni, delle istituzioni.

🔊 Un vocale da… Anna Vaccarelli (Istituto di informatica e telematica del CNR): in che modo l’intelligenza artificiale può essere utilizzata sia per gli attacchi che per la difesa? Nel vocale di questa settimana ce lo spiega una delle pioniere della cybersecurity.

📰 Da UK 🇬🇧 un report sull’impatto a breve termine dell’IA sulla sicurezza informatica

Il National Cyber Security Center inglese ha pubblicato un report che analizza come l’intelligenza artificiale influirà sull’efficacia delle minacce nei prossimi due anni.

Nel report si legge, ad esempio, che entro il 2025 l’IA offrirà agli autori delle minacce un miglioramento delle capacità nell’ingegneria sociale, favorirà lo sviluppo delle tecniche di attacco e renderà gli attacchi ransomware molto più pericolosi. Inoltre la “GenAI” e i modelli linguistici di grandi dimensioni renderanno difficile per tutti identificare tentativi di phishing o valutare se una richiesta di reimpostazione di password è autentica.

Per questo, nel report, viene sottolineata la necessità di investire nsubito in competenze, tecnologie e risorse finanziarie.

📰 Cineca lavora al modello GPT tutto italiano 🇮🇹

Realizzare un nuovo modello GPT, completamente italiano, per supportare il settore pubblico e privato nell’uso dell’Intelligenza artificiale generativa: è questo l’obiettivo del progetto “Modello Italia” presentato in queste settimane dal Cineca.

Il progetto porterà allo sviluppo di un Foundational Large Language Model - modello di reti neurali alla base di strumenti di intelligenza artificiale quali ChatGPT o Crystal - di nuova generazione che sarà rilasciato con licenza completamente open source. Nel comunicato del Cineca si legge che particolare attenzione in fase di sviluppo sarà data alla sicurezza e alla protezione dei dati personali per garantire per l’uso del sistema su larga scala in ambienti ad elevata criticità come la sanità, la finanza e la sicurezza nazionale. Riuscirà il modello italiano a competere con quelli delle big tech?

⚖️ AI Act sempre più vicino: il Consiglio Europeo lo approva all’unanimità

Dopo l’accordo politico di dicembre (ne abbiamo parlato in LeggeZero #3), un altro passo verso l’adozione definitiva del Regolamento europeo in materia di IA. L’AI Act è stato approvato all’unanimità dal Consiglio Europeo, incassando il voto favorevole di tutti i 27 Stati dell'Unione. Compreso quello di Francia, Italia e Germania, che si erano alleate durante i negoziati per rivedere alcune misure relative agli usi di polizia e all'AI generativa.

Adesso bisogna segnare in calendario la data del 24 aprile, quando il Parlamento europeo sarà chiamato al voto finale.

⚖️ OpenAI torna nel mirino del Garante Privacy

Una delle notizie di maggior rilievo della settimana è senza dubbio la decisione del Garante per la protezione dei dati personali di contestare a OpenAI la violazione della normativa in materia di protezione dei dati personali in relazione al suo servizio più famoso, ChatGPT.

Dopo circa 10 mesi dal primo provvedimento di limitazione provvisoria del trattamento che aveva portato al blocco temporaneo di ChatGPT in Italia (per gli utenti senza VPN) e al termine dell’istruttoria svolta, il Garante ha ritenuto che gli elementi acquisiti possano configurare più violazioni della normativa in materia di data protection.

Base giuridica del trattamento, allucinazioni, trasparenza dell’algoritmo e uso da parte dei minori sono alcuni dei punti su cui OpenAI, entro 30 giorni, dovrà difendersi.

😂 IA Meme

Qui ci siamo noi di LeggeZero alle prese con la scelta dei contenuti da inserire nella newsletter, visto che ormai l’IA è ovunque.

📚 Consigli di lettura: "Lawyering in the Age of Artificial Intelligence"

Se siete giuristi (avvocati, consulenti) dovete assolutamente leggere questa ricerca che arriva dall’Università del Minnesota (USA). L’indagine rileva che l’uso dell’IA generativa non solo migliora la qualità delle prestazioni dei professionisti del settore legale, ma accelera anche significativamente i processi di lavoro.

I test condotti dagli studenti hanno dimostrato che l’IA aiuta maggiormente i meno esperti. Questo studio suggerisce una riflessione profonda sull'integrazione dei sistemi di IA anche nella formazione nel settore forense e sulle sue implicazioni future nella professione, aprendo nuove frontiere per l’organizzazione degli studi e per i servizi resi ai clienti.

📚 Consigli di visione: Agogà (Rai 3) Deepfake, norme e rischi per le elezioni

Quante volte abbiamo detto “l’ho visto con i miei occhi” per confermare ai nostri interlocutori che qualcosa era accaduto davvero? I deepfake generati attraverso l’IA sono pericolosi proprio perché noi siamo stati abituati a fidarci dei nostri sensi.

Di deepfake, del loro uso nelle campagne elettorali e degli strumenti di tutela si è parlato nel corso della puntata di Agorà (Rai 3) del 31 gennaio in cui è stato ospite Ernesto Belisario insieme a Michele Mirabella. La registrazione dell’approfondimento è disponibile su Raiplay.

📣 Eventi

L'intelligenza artificiale nella P.A. Opportunità e sfide - Torino, 7.2.2024

AI Festival - Milano, 14-1 .2.2024

L’intelligenza artificiale a supporto del lavoro parlamentare - Roma, 14.2.2024

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare. Grazie!