🤖 Né apocalittici, né integrati – Legge Zero #31

L'IA ci farà perdere il lavoro o ci aiuterà a lavorare - e vivere - meglio? La risposta non dipende dalla tecnologia, ma da come scegliamo di svilupparla e usarla. Ecco perché servono le regole.

🧠 La regola del 20-60-20

‘L’IA ci ruberà il lavoro. Lo sta già facendo, nell’indifferenza di istituzioni e sindacati.’

‘No, non è vero. Come per tutte le altre tecnologie, alcuni lavori moriranno e altri nasceranno, ma ci sarà sempre bisogno dell’essere umano’.

Il dibattito sull’IA dei nostri giorni può essere riassunto, con pochissime eccezioni, in questa diatriba tra tecno-ottimisti e tecno-scettici, tra apocalittici e integrati (per usare le categorie coniate da Umberto Eco a metà degli anni ‘60 in relazione ai mezzi di comunicazione di massa dell’epoca).

Se ci pensate, molte delle discussioni sull’intelligenza artificiale si riducono a un dibattito tra queste due fazioni. Eppure questa contrapposizione non restituisce la reale complessità del periodo che stiamo vivendo e di tecnologie che presentano - al tempo stesso - opportunità e rischi senza precedenti. Insomma, la realtà è molto più complessa di una contrapposizione manichea tra bene e male.

Proviamo a spiegarlo con un esempio. Qualche settimana fa, nel nostro Paese qualcuno ha lanciato l’allarme: 200mila dipendenti pubblici sarebbero a rischio a causa dell’IA. È un titolo acchiappaclic o si tratta di un rischio concreto? La domanda è mal posta, a mio avviso.

La verità, infatti, è che la pubblica amministrazione italiana sta subendo un ridimensionamento senza precedenti: non è più un posto di lavoro attrattivo.

Secondo i dati pubblicati da lavoce.info, per 100 posizioni a tempo indeterminato lasciate scoperte per l’uscita di dipendenti pubblici, ne vengono ricoperte con nuovi ingressi solo 72. E neanche la recente stagione di concorsi pubblici del PNRR è riuscita a invertire la tendenza. In sintesi: non troviamo più chi voglia lavorare nella pubblica amministrazione.

In questo contesto, quindi, l’intelligenza artificiale può essere utilissima sia per contribuire all’efficienza del lavoro, riducendo i tempi per la gestione dei procedimenti amministrativi e l’erogazione dei servizi, sia per migliorare le condizioni di lavoro negli uffici pubblici (e rendere di nuovo “figo” il posto pubblico, per usare le parole di un recente spot governativo).

È quanto stanno provando a fare negli USA dove si sono resi conto di avere un grande problema con le richieste di accesso presentate sulla base del FOIA (la loro norma sulla trasparenza). Nonostante nello scorso anno, le amministrazioni federali siano riuscite ad evadere 1,1 milioni di richieste, ci sono almeno 200mila domande ancora arretrate. E la situazione peggiora costantemente. Il rischio, oltre al contenzioso, è perdere la fiducia di cittadini e giornalisti a causa del ritardo nell’ottenere trasparenza. Per questo motivo, sono state avviate diverse sperimentazioni: dal chatbot che consente agli utenti di capire qual è l’ufficio che detiene i documenti di interesse (evitando inutili scambi di comunicazioni con altri uffici) a strumenti di analisi delle domande che consentano ai dipendenti di risparmiare fino al 60% del tempo nell’analisi dell’istanza (trovate alcuni dettagli qui).

Il Segretario di Stato USA Blinken, nel corso di un recente evento, ha raccontato di come l’IA sta aiutando i dipendenti del suo Dipartimento a migliorare la qualità della diplomazia statunitense (qui l’elenco di tutti i sistemi di IA che utilizzano). Invece, Elizabeth Allen, Vice Segretario di Stato per la Diplomazia Pubblica e gli Affari Pubblici, ha fornito la sua formula relativa a come cambia il lavoro dei dipendenti pubblici:

20% del lavoro è scrivere un buon prompt

ChatGPT fa il 60% del compito

il restante 20% consiste nella revisione da parte del pubblico dipendente.

Al momento, quindi, non sembra che l’IA sia un nemico dei dipendenti pubblici, quanto piuttosto un alleato.

I tecno-entusiasti, però, non possono esultare. Secondo uno studio pubblicato da Harward Business Review, i dipendenti che utilizzano l'IA come parte centrale del loro lavoro si sentono più soli, bevono di più e dormono meno rispetto a chi non la utilizza. Questo impatto negativo sulla salute e sul benessere psicologico è una conseguenza dell'aumento dell'automazione e della riduzione delle interazioni umane senza la riprogettazione dei flussi di lavoro che metta al centro la qualità e la dignità del lavoro.

Ecco a cosa servono le regole, degli Stati e dei datori di lavoro (le AI policy), a cogliere le opportunità riducendo i rischi. Lontano dalle diatribe da social tra apocalittici e integrati.

🔊 Un vocale da… Marco Carrara: qual è il vero segno della popolarità nell’era dell’IA? Nel vocale di questa settimana ce ne parla il più giovane conduttore della RAI - volto di Timeline e Agorà - con alcune importanti considerazioni sul ruolo degli esseri umani nel giornalismo.

📰 Aspen Institute pubblica il Rapporto 2024 sull'IA

L'Osservatorio permanente sull'adozione e l'integrazione dell'intelligenza artificiale di Aspen Institute Italia - guidato da Giuliano Amato - ha pubblicato il Rapporto annuale sull'Intelligenza Artificiale.

Alcuni punti salienti delle 250 pagine del rapporto:

Avanzamenti scientifici nell'ambito dell'IA: il rapporto mette in luce i recenti progressi tecnologici, con particolare attenzione all'IA generativa.

Scenari degli effetti etici e socio-economici: vengono esaminati gli impatti dell'IA sulla vita quotidiana, sottolineando l'importanza della formazione per mantenere l’occupazione della forza lavoro e mitigare i rischi legati a questa rivoluzione tecnologica.

Quadro regolatorio: il rapporto analizza le normative europee e globali, sottolineando l’importanza dell'adozione dell'AI Act da parte del Parlamento europeo. Secondo l’Osservatorio, questo atto garantisce sicurezza, rispetto dei diritti fondamentali e promuove l'innovazione.

Effetti sul sistema economico italiano: il rapporto offre una prospettiva sul contesto italiano, evidenziando la necessità di colmare il divario infrastrutturale e di investimenti per sfruttare appieno le potenzialità dell'IA.

Conclusioni e proposte strategiche: viene sottolineata l'importanza di un impegno interdisciplinare e di un dialogo congiunto tra governi, industrie, istituzioni educative e società civile per garantire che l'IA possa essere proficua per tutti. Si sostiene la necessità di un “Centro Europeo per l’IA” che, in modalità analoga al CERN di Ginevra, sia in grado lavorare sulla ricerca avanzata, sullo sviluppo di standard etici e tecnologici, e sulla formazione di talenti nel campo dell'IA.

Il rapporto può essere scaricato qui.

📰 Apple e Meta: per colpa delle istituzioni UE 🇪🇺, gli utenti europei devono attendere

L’AI Act ancora non è stato pubblicato in Gazzetta Ufficiale, ma due grandi aziende USA sono già costrette ad escludere gli utenti europei da alcuni dei loro servizi di IA.

Dapprima Meta - a seguito delle pressioni del Garante privacy irlandese e non senza polemiche - ha rinunciato ad addestrare la propria IA sui dati degli utenti europei di Instagram e Facebook, comunicando che al momento i suoi servizi di IA non saranno disponibili nel vecchio continente.

In seguito, è stata Apple ad annunciare che - a causa delle norme del Digital Markets Act (DMA) - le funzionalità di Apple Intelligence non saranno disponibili per gli utenti europei, almeno fino al 2025.

Per alcuni è un bene, significa che le norme funzionano nel proteggere i diritti e le libertà fondamentali delle persone. Per altri, invece, a lungo andare, le barriere normative possono essere controproducenti (in questo senso questo articolo di Stefano Da Empoli).

⚖️ L’European Data Protection Board 🇪🇺 pubblica un kit innovativo per la trasparenza dell’IA

Il Comitato europeo per la protezione dei dati (EDPB) ha reso disponibili tre documenti interessanti nell’ottica di definire - alla vigilia della pubblicazione dell’AI Act - nuovi strumenti e metodologie per migliorare la trasparenza e la responsabilità nell'uso dell'intelligenza artificiale. Questi documenti propongono soluzioni pratiche per assicurare che l’uso dell’IA sia conforme alle normative vigenti e, soprattutto, facilmente comprensibile (specialmente dagli utenti finali).

I documenti hanno ad oggetto:

Foglietti informativi (come quelli dei medicinali): si tratta di modelli pensati per essere utilizzati da provider e utenti finali, fornendo dati chiave come il nome del sistema, la versione, i dettagli del proprietario e il livello di rischio (sul modello dei ‘bugiardini’ dei farmaci).

Punteggi Algoritmici: un sistema di valutazione che mira a quantificare l'etica e l'efficacia degli algoritmi IA, ispirato ai modelli nutrizionali per prodotti alimentari e a quelli per l’efficienza energetica degli elettrodomestici (A+++) . Questo approccio ha l’obiettivo di guidare la percezione pubblica e influenzare le scelte dei consumatori attraverso una maggiore comprensione dei sistemi di IA.

Checklist per audit: contiene la descrizione di una metodologia per valutare i sistemi di IA sotto il profilo del rispetto dei principi etici e della normativa sulla protezione dei dati personali.

Li potete scaricare qui.

⚖️ Per il Presidente dell’Antitrust tedesca 🇩🇪 lo sviluppo dell’IA accrescerà le pratiche restrittive della concorrenza

Il Presidente dell'Antitrust tedesca, Andreas Mundt, ha lanciato un avvertimento riguardo all'impatto dell'intelligenza artificiale (IA) sulla concorrenza. Secondo Mundt, l'IA intensificherà le pratiche restrittive della concorrenza da parte delle grandi aziende tecnologiche.

Durante la conferenza stampa annuale del Bundeskartellamt, Mundt ha dichiarato che i sistemi IA diventeranno sempre più ambienti chiusi, limitando la possibilità per gli utenti di cercare alternative.

L’Autorità tedesca non è l’unica che sta investigando sul rispetto delle leggi in materia di concorrenza, anche negli USA sono state aperte istruttorie in tal senso.

Trovate una sintesi completa dello stato dell’arte qui.

⏮️ Update

In LeggeZero #28 abbiamo scritto dell’IA candidata a sindaco della città di Cheyenne nel Wyoming. Si trata di VIC - Virtually Integrated Citizen, creata da un cittadino, Victor Miller, utilizzando la tecnologia di OpenAI. Prima che intervenissero le Autorità, OpenAI ha disabilitato l’accesso di Miller a GPT per la violazione dei termini d’uso (che prevedono il divieto di uso dei servizi di IA in ambito politico-elettorale). Come sempre più spesso accade, le piattaforme arrivano prima delle istituzioni, anche con le sanzioni. Adesso vedremo se Miller aggirerà il divieto o ricorrerà ad altri strumenti.

Continuano le azioni giudiziarie degli editori contro i provider di IA. Nei giorni scorsi il Center for Investigative Reporting ha avviato un'azione legale contro OpenAI e Microsoft, accusando le aziende di aver utilizzato senza autorizzazione i suoi contenuti giornalistici protetti da copyright per addestrare i modelli di intelligenza artificiale (ChatGPT e Copilot). Potete scaricare l’atto introduttivo qui sotto.

L’azione è molto simile a quella promossa dal New York Times di cui abbiamo parlato in LeggeZero #6.

In questo articolo di NBC trovate una ricostruzione di quali editori hanno fatto causa ai provider e di quelli che, invece, hanno trovato un accordo con le aziende di IA (recentemente Time Magazine).

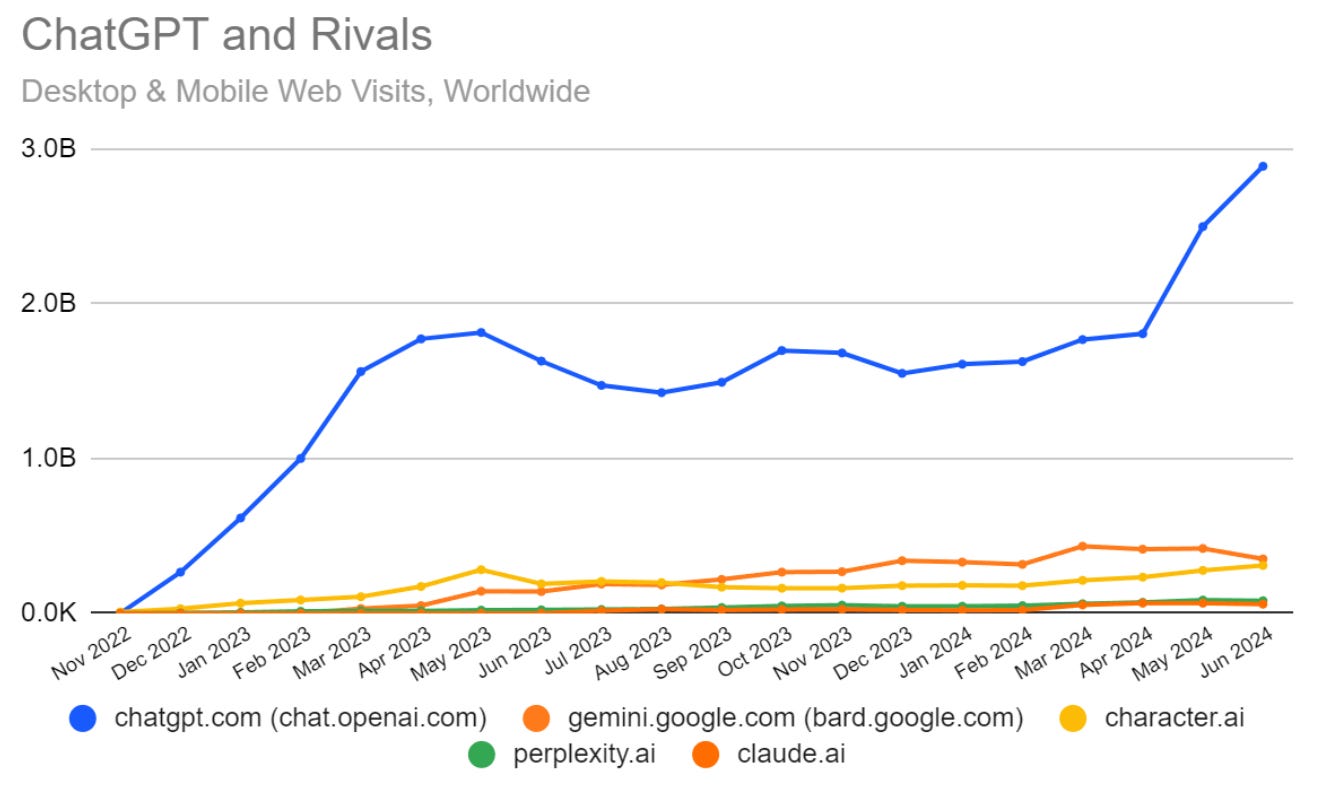

Se vi chiedete perché si parla tanto di ChatGPT (e perché ci sono così tante azioni legali contro OpenAI), guardate questa grafica sul traffico generato dai diversi strumenti di IA. NB: il divario è aumentato dopo il lancio di GPT-4o.

Fonte immagine: Similarweb

😂 IA Meme

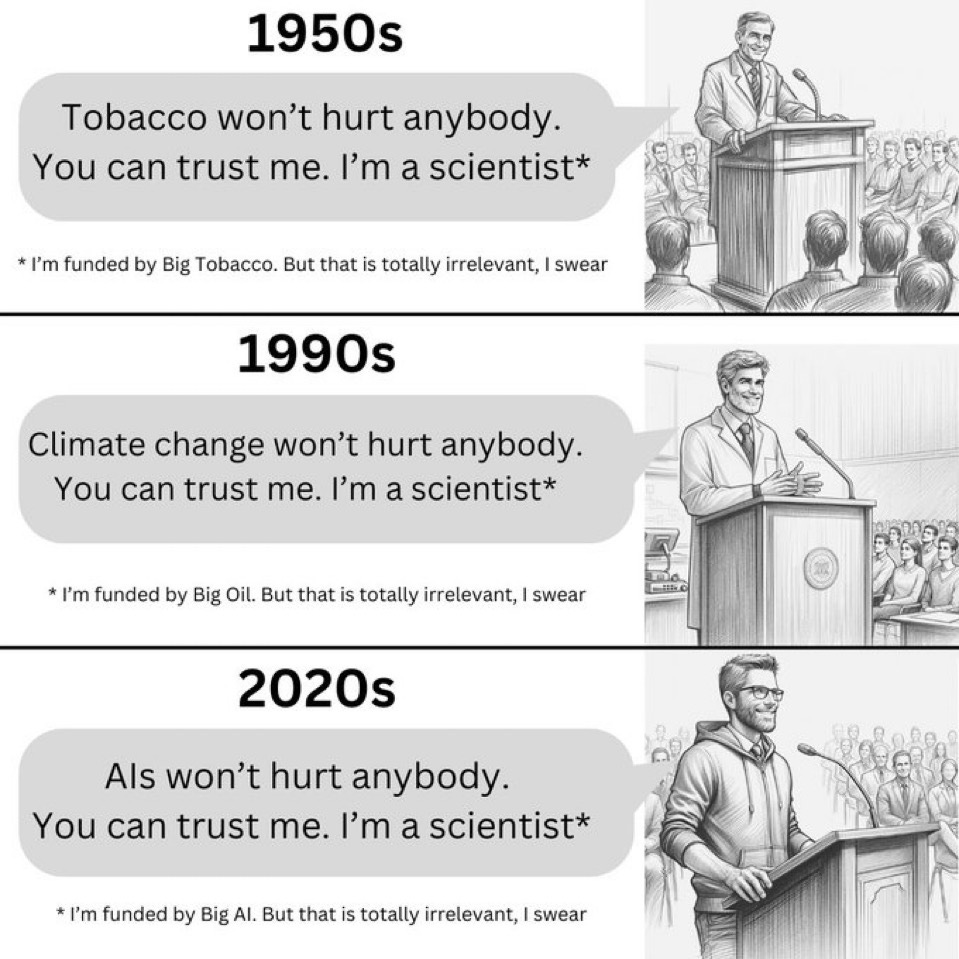

Nelle ultime settimane, in California si è molto discusso di una proposta di legge presentata dal Senatore Scott Wiener (SB-1047) che, se approvata definitivamente, imporrebbe stringenti misure di sicurezza a sviluppatori e provider di IA (qui un articolo di Politico, qui un articolo di Vox).

Da un lato le aziende, con 150 tra founder e CEO che hanno firmato una lettera a Wiener, sottolineando che il disegno di legge sarebbe una minaccia all'innovazione tecnologica e alla competitività economica dello Stato (il motore dell’innovazione degli USA e quindi del mondo). Dall’altro gli attivisti che hanno deciso, per sensibilizzare i parlamentari, di utilizzare anche i meme (qui sotto ne trovate alcuni).

Stando ai risultati della votazione, la strategia ha funzionato. I senatori hanno approvato la proposta con 32 voti favorevoli e un solo contrario. Adesso la palla passa all’altra camera, l’Assemblea dello Stato della California, che dovrebbe esaminare la proposta nel mese di agosto.

📚 Consigli di lettura: "Generative AI Misuse: A Taxonomy of Tactics and Insights from Real-World Data" di Google DeepMind

DeepMind di Google ha pubblicato un interessante studio che evidenzia come i deepfake, in particolare quelli che impersonano politici e celebrità, siano diventati una delle principali forme di abuso delle tecnologie IA (come accennato da Marco Carrara nel vocale di questa settimana).

L'articolo fornisce una classificazione dettagliata delle tattiche di abuso dell’IA generativa, basata su un'analisi qualitativa di circa 200 incidenti osservati tra il gennaio 2023 e il marzo 2024. Viene messo in luce come le tecnologie di GenAI siano state sfruttate o abusate nella pratica, illustrando le strategie e le motivazioni degli attaccanti, e come queste capacità vengano manipolate attraverso le varie modalità (immagine, testo, audio, video).

L'analisi di DeepMind, realizzata con il supporto del suo gruppo di ricerca e sviluppo Jigsaw, rivela che la creazione di immagini, video e audio realistici ma falsi è l’abuso più ricorrente.

Il focus principale dei malintenzionati è influenzare o manipolare l'opinione pubblica, un obiettivo che rappresenta il 27% degli usi identificati, sollevando preoccupazioni significative su come i deepfake possano influenzare le elezioni e il dibattito a livello globale.

Questo paper di DeepMind non solo indica le principali sfide nella gestione della sicurezza IA ma è una risorsa utile per chi è chiamato a definire misure di regolazione e mitigazione dei rischi dell’intelligenza artificiale (nelle conclusioni gli autori riflettono sulla necessità di una governance più forte).

📚 Consigli di visione: #dueparole tra Matteo Flora ed Ernesto Belisario su ‘La sfida dell’intelligenza artificiale nelle pubbliche amministrazioni’

L'intelligenza artificiale nelle pubbliche amministrazioni è spesso vista con timore, ma - come abbiamo visto nel primo piano - si tratta di una preoccupazione eccessiva.

In un episodio di #CiaoInternet, Matteo Flora ne ha parlato con l’avvocato Ernesto Belisario per approfondire questa tematica complessa e attuale: il potenziale dell'AI per migliorare l'efficienza, ridurre i carichi di lavoro e rendere la pubblica amministrazione più attrattiva per i nuovi talenti, senza però tralasciare le relative sfide e opportunità future.

Trovate l'episodio del podcast qui.

📣 Eventi

Open HUB: Abruzzo generatore di competenze - Pescara, 01.07.2024

Intelligenza artificiale, natura e parchi - Pisa, 02-07.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.

Io sono d'accordo con Flora quando dice che l'IA sostituirà i super-junior (stagisti e tirocinanti). O meglio: ne limiterà molto l'assunzione per svolgere quei ruoli ripetitivi e semplici. Inoltre, se come dicono alcuni avremo davvero "agenti IA" fra qualche anno, sarà anche una questione di formazione: i lavoratori non dovranno più saper svolgere il loro lavoro, ma saper insegnare agli agenti a svolgerlo e supervisionarli.