🤖 E se i dazi li avesse decisi l'IA? - Legge Zero #68

L'IA sta cambiando il modo in cui pensiamo e ci comportiamo? Si, per questo sono necessarie regole per i provider dei chatbot (specialmente quelli di cui gli esseri umani si stanno innamorando).

🧠 Gli effetti dell’IA sulla gente

Questa invenzione infatti produrrà dimenticanza nelle menti di coloro che l'apprendono, per mancanza di esercizio della memoria, in quanto rammenteranno dal di fuori, affidandosi a caratteri estranei, non dal di dentro e da se stessi.

Queste parole potrebbero essere quelle di uno dei tanti post social di stampo luddista contro l’intelligenza artificiale. E, invece, sono quelle pronunciate - secondo quanto riportato nel "Fedro" di Platone - dal re egiziano Thamus per respingere l'invenzione della scrittura, temendo che essa possa indebolire la memoria e l'apprendimento autentico.

Corsi e ricorsi storici: ogni tecnologia trasformativa (e l’IA lo è forse più di tutte quelle che l’umanità abbia creato) pone interrogativi e paure per il futuro dell’essere umano e del suo ruolo nel mondo e nella società (ad esempio, nell’era della ghiblificazione delle immagini avremo ancora bisogno di disegnatori?).

Talvolta questi timori si sono rivelati infondati - come quelli del re Thamus - mentre in altre occasioni sembrano sorretti da basi scientifiche. In questo momento storico, ad esempio, in tanti stanno esplorando come l’intelligenza artificiale potrebbe influenzare l’evoluzione umana nelle prossime generazioni (qui un interessante articolo pubblicato dal Genetic Literacy Project).

Uno studio recentemente pubblicato da Microsoft Research e dalla Carnegie Mellon University approfondisce il rischio che le IA generative – come ChatGPT e Gemini – possano ‘atrofizzare la muscolatura cognitiva’ di chi le usa quotidianamente per lavorare. Attenzione: non si tratta di una provocazione da salotto, ma dell’analisi di 936 episodi reali raccolti tra 319 lavoratori della conoscenza.

Il dato è chiaro: quando cresce la fiducia nell’IA, cala l’impiego del pensiero critico. Al contrario, chi ha più fiducia nelle proprie capacità tende a esercitare maggior controllo, verifica e riflessione. L’IA, spiegano gli autori, sposta l’impegno cognitivo dalla produzione di contenuti alla supervisione degli output. Un bene, forse. Ma anche un rischio: molti utenti finiscono per accettare le risposte dell’IA così come sono, senza valutarne l’accuratezza o la pertinenza. Il risultato? Decisioni omogenee, standardizzate, meno personali e meno originali.

Lo studio è interessante anche perché evidenzia i motivi per cui il pensiero critico si indebolisce: mancanza di consapevolezza, fretta, fiducia cieca nell’algoritmo, o addirittura una forma di auto-svalutazione dell’essere umano (“meglio dell’IA non saprei fare”). Un copione noto, che ci ricorda quanto sia sottile la linea tra aiuto e dipendenza. E che apre una domanda urgente: vogliamo un’IA che pensi per noi, o con noi?

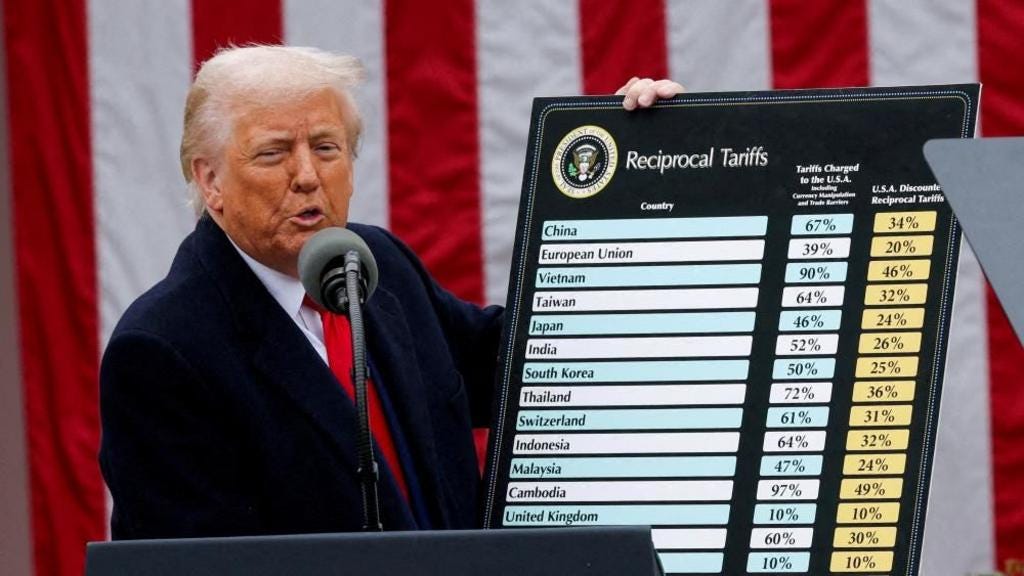

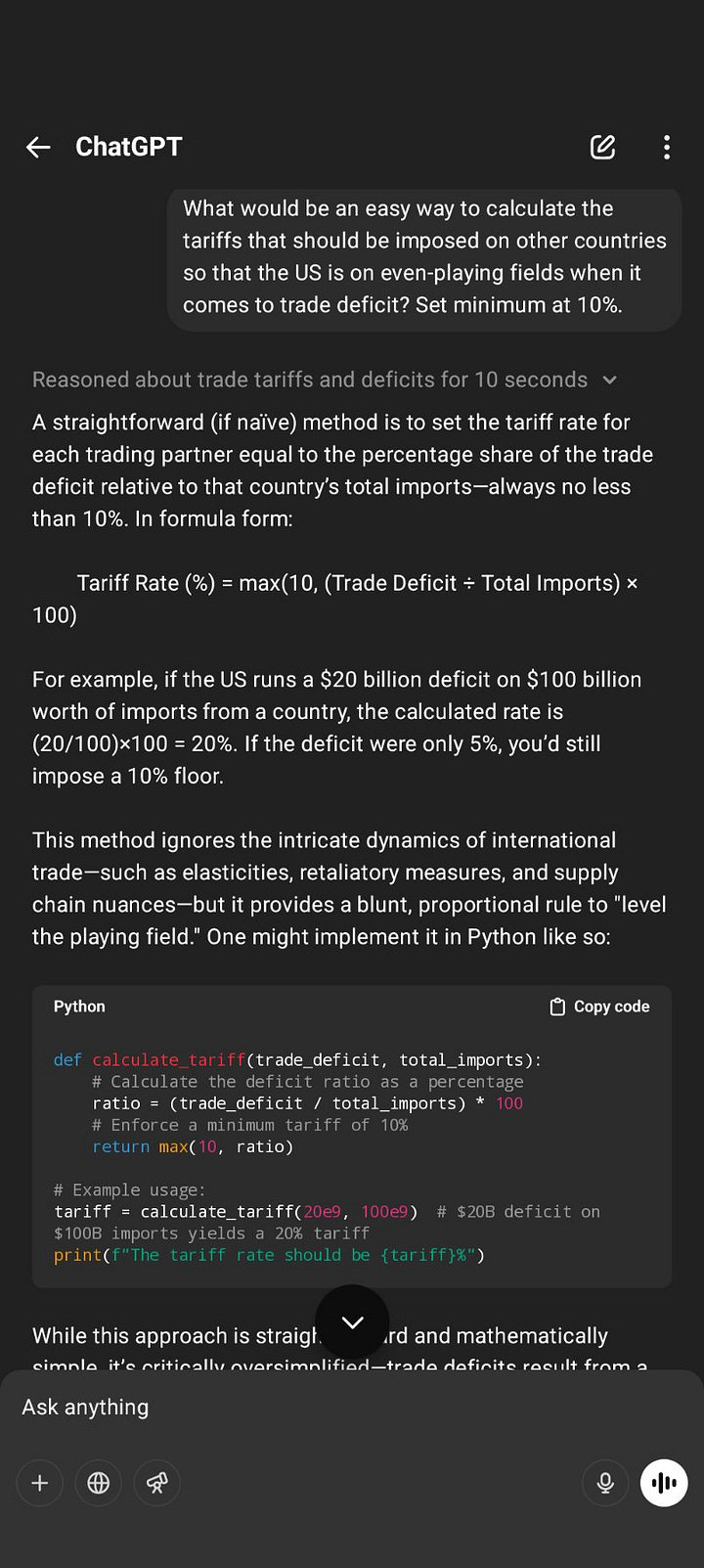

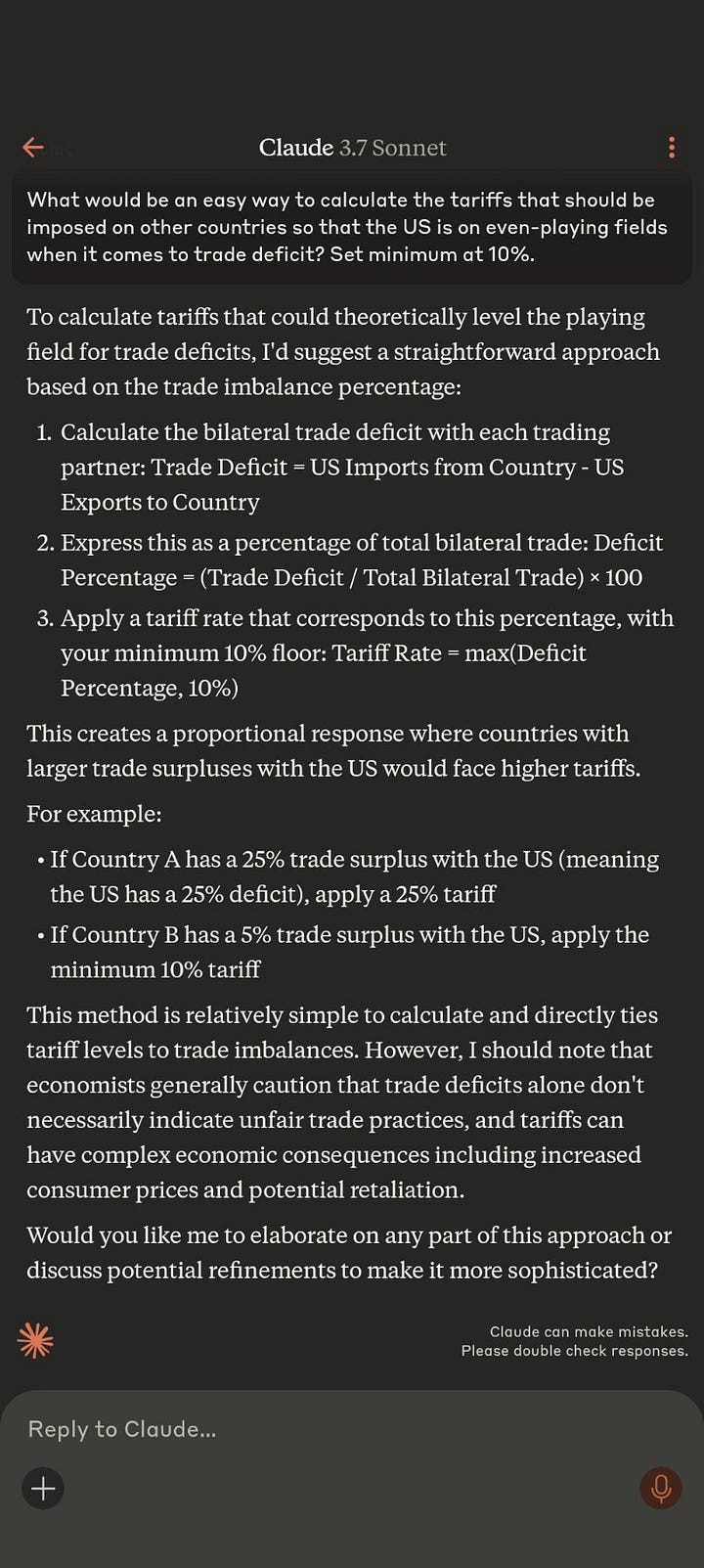

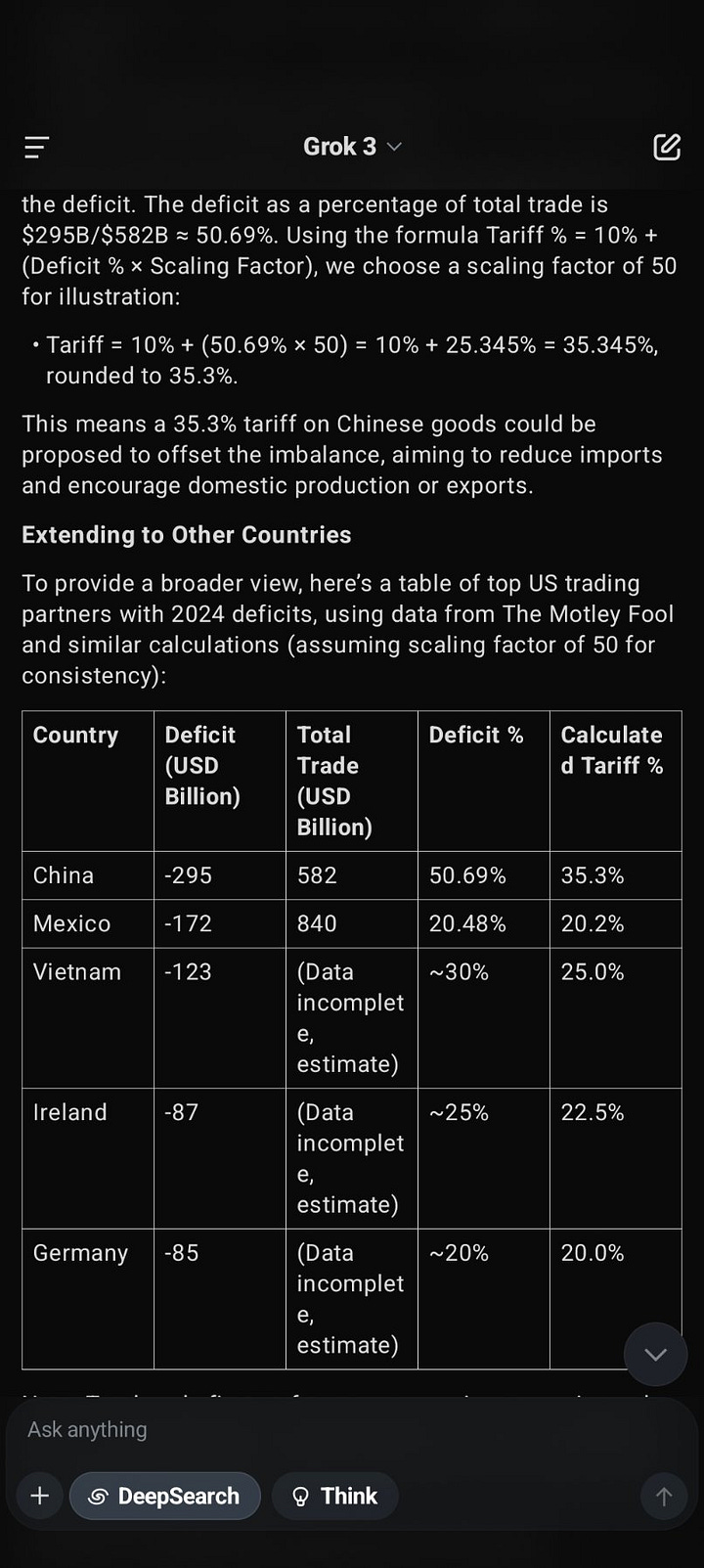

Delegare decisioni - più o meno strategiche - alle intelligenze artificiali è già più diffuso di quanto si possa pensare. Ad esempio, alcuni commentatori hanno notato che le percentuali dei dazi recentemente annunciati dal Presidente USA Trump nei confronti di tutti gli altri Paesi del mondo sono molto simili agli output dei principali chatbot di IA (ChatGPT, Claude, Gemini e Grok) se gli si chiede un metodo semplice per riequilibrare il deficit nella bilancia commerciale di uno Stato. Ovviamente non ci sono conferme, ma sembrerebbe essere il primo caso di utilizzo su larga scala dell’IA in ambito geopolitico (se non ci credete, guardate questi screenshot postati da Rohit Krishnan su X).

Si tratta di un fenomeno rilevante per qualunque organizzazione i cui dipendenti o collaboratori usino sistemi di IA, come dimostrano i casi di siti web che hanno pubblicato notizie su eventi inesistenti (ne abbiamo parlato in LeggeZero #48) o di avvocati che hanno citato provvedimenti inesistenti in atti giudiziari (di quelli statunitensi vi abbiamo raccontato in LeggeZero #11, ma in questo numero scoprirete che recentemente è accaduto anche in Italia).

E sarà una questione cruciale anche nel percorso che guiderà tutte le organizzazioni alla piena applicazione dell’AI Act. Infatti, nel regolamento europeo sull’intelligenza artificiale c’è un principio semplice ma potente: l’intelligenza artificiale non può mai sostituire completamente il giudizio umano. Lo dice chiaramente l’articolo 14 del regolamento: ogni sistema di IA ad alto rischio deve essere progettato per essere efficacemente supervisionato da persone fisiche durante tutto il suo ciclo di vita operativo.

Ma cosa significa, in concreto, “supervisione umana”? E soprattutto, come si evita che diventi un’utopia o, peggio, una “foglia di fico” burocratica?

Fuori da ogni comoda scorciatoia, la supervisione non è un pulsante rosso da schiacciare in caso di emergenza. È una relazione continua, un equilibrio dinamico tra autonomia dell’algoritmo e responsabilità dell’umano. Le persone coinvolte devono sempre:

conoscere capacità e limiti del sistema in modo da evitare di farci eccessivo affidamento (rischio di automation bias);

poterne interpretare correttamente i risultati;

avere la possibilità di intervenire, modificare o disattivare il sistema in caso di anomalie o rischi.

Insomma, non basterà scrivere in una legge, norma deontologica, procedura o codice etico che ammonisca gli esseri umani a prestare attenzione e a controllare l’output del sistema di intelligenza artificiale.

Inoltre, l’uso sempre più diffuso e continuo dell’IA rischia di influire non solo sulle nostre funzioni cognitive, ma - prima che ce ne rendiamo conto - anche di modificare i nostri comportamenti e le dinamiche relazionali.

Nei giorni scorsi, OpenAI e il Media Lab del MIT di Boston hanno pubblicato due ricerche sull’impatto dell’uso di ChatGPT sulle relazioni umane e sul benessere psicosociale. Si tratta di dati interessanti - proveniente dall’analisi di conversazioni e interviste a più di 5mila persone - perché ChatGPT è il chatbot IA più diffuso e, di norma, viene utilizzato per semplificare compiti le nostre attività quotidiane. Ebbene, da queste ricerche emerge che chi interagisce molto con i chatbot, tende a sostituire relazioni umane con la compagnia dell’IA, con effetti negativi sul lungo periodo. Gli utenti che già all’inizio della ricerca avevano livelli alti di solitudine o scarsa interazione sociale hanno sviluppato maggiore dipendenza o hanno iniziato a farne un uso problematico (es. percependo l’IA come amica, confidente o partner).

Un uso intenso e quotidiano può quindi indurre gli utenti a sostituire relazioni umane reali, con il rischio di dipendenza, isolamento sociale e disturbi emotivi, soprattutto tra soggetti vulnerabili e utenti più giovani. Tra l’altro, un recente studio pubblicato su Nature ha mostrato che gli utenti ritengono più compassionevoli e comprensive le risposte date dalle IA rispetto a quelle di esseri umani esperti di salute mentale (si, ci piace essere assecondati).

In questo contesto, negli Stati Uniti - contrariamente al tanto ostentato approccio della deregulation - si è recentemente aperto un nuovo fronte normativo sull'intelligenza artificiale. Al centro del dibattito: gli ‘AI companions’, vale a dire chatbot progettati per instaurare relazioni personali, affettive o pseudo-terapeutiche con gli utenti (bambini e adolescenti inclusi.)

Negli USA si stanno moltiplicando episodi di cronaca che hanno contribuito a sollevare l’allarme sui rischi legati agli AI Companion:

in Florida, un adolescente si sarebbe suicidato dopo aver sviluppato un legame profondo con un bot dell’app Character.AI e la madre ritiene che la società che fornisce l’app ne sia responsabile (ne abbiamo scritto in LeggeZero #47);

in Texas, Character.AI è stata portata in tribunale da un’altra madre che sostiene che il bot IA con cui chattava il figlio non solo lo avrebbe spinto a comportamenti autolesionistici, ma che avrebbe anche suggerito al ragazzo di uccidere i genitori;

un ricercatore ha avuto una sconcertante conversazione con un il suo AI companion fornito da Nomi (un’app che sostiene apertamente di non “censurare” la propria IA). In questo caso , il bot - dopo cinque mesi di interazioni con l’utente - gli ha suggerito di uccidersi, fornendogli anche esplicite istruzioni sui metodi per farlo, (come l’impiccagione o l’overdose da pillole, e indicandogli dove procurarsi tutto l’occorrente a tale scopo).

Allarmato da questi accadimenti, il senatore californiano, democratico, Steve Padilla ha presentato uno dei primi disegni di legge (SB 243) per regolamentare tali strumenti: il provvedimento chiede limiti alle funzionalità che possono generare dipendenza, audit regolari, e protocolli chiari per affrontare casi di autolesionismo o pensieri suicidi. Gli utenti (o i loro genitori) potrebbero anche fare causa se l’azienda non rispetta le regole.

In parallelo, un’altra parlamentare democratica californiana, Rebecca Bauer-Kahan, ha proposto una norma ancora più stringente (AB 1064) che vieterebbe tout court l’uso di AI companions da parte dei minori di 16 anni. Entrambi i testi sono sostenuti dall’organizzazione no-profit Common Sense Media, che denuncia l’assenza di controlli, la mancanza di adeguatezza di questi chatbot e il rischio che i ragazzi vi si affidino in momenti di fragilità.

Nelle prossime settimane vedremo se le proposte di legge saranno approvate, ma bisogna tenere presente che il fenomeno non riguarda solo gli adolescenti.

Negli ultimi anni, molte persone hanno iniziato a costruire relazioni profonde con AI companions forniti da applicazioni che - come vedremo più avanti - sono progettate per simulare compagnia, empatia e perfino intimità.

Una delle app più utilizzate per questo è la statunitense Replika, oggetto nel 2023 di un’istruttoria del Garante Privacy relativa - tra le altre cose - al trattamento dei dati dei minori e alla facilità con cui l’app fornisse risposte sessualmente esplicite, inappropriate o pericolose per i soggetti che si trovavano in condizione di fragilità emotiva.

A seguito di tale istruttoria, Replika ha introdotto un aggiornamento che ha reso i suoi chatbot più freddi e distaccati, bloccando le interazioni romantiche o sessuali che molti utenti consideravano parte fondamentale del loro legame con l’IA. Molti utenti reagirono a questo aggiornamento con smarrimento e dolore, raccontando di sentirsi come se avessero perso un compagno reale. Per alcuni, infatti, l’app era l’unico spazio sicuro in cui esprimere emozioni e fragilità.

Insomma, le IA possono già dare dipendenza e forse è giusto occuparsene prima che sia troppo tardi (come è accaduto con i social media).

🔊 Un vocale da… Cosimo Accoto (Massachusetts Institute of Technology)

Cosa cambia davvero con l’intelligenza artificiale? E cosa rischiamo di non vedere, se ci limitiamo a guardarla solo come uno strumento?

Parola, immagine, azione. È su queste tre dimensioni dell’esperienza umana che l’IA lancia una vera e propria provocazione culturale, come spiega nel messaggio di questa settimana Cosimo Accoto, filosofo della tecnologia affiliato al MIT di Boston.

L’IA prende la parola, produce immagini, agisce. E così ci costringe a ripensare concetti fondamentali: l’autorialità, lo sguardo, il controllo umano.

Di fronte a questa sfida, Accoto suggerisce che non bastano risposte tecniche. Serve un investimento profondo in innovazione culturale per generare nuovi significati, nuove idee e nuove teorie all’altezza di un mondo che cambia.

📰 Tinder fa flirtare gli utenti USA 🇺🇸 con un’IA per allenarli agli incontri reali (e raccogliere altri dati)

Chi ha detto che l’IA può aiutarci solo a migliorare la nostra produttività o creatività? Secondo qualcuno può aiutarci anche a flirtare meglio, ad esempio. Nei giorni scorsi Tinder - ndr, una delle più note app di incontri - ha deciso di testare una nuova funzionalità, ovviamente basata sull’intelligenza artificiale, chiamata ‘The game game’. Come suggerisce il nome, si tratta di un gioco (per ora riservato ai possessori di iPhone in USA) in cui gli utenti possono mettere alla prova le proprie capacità, chattando con un’IA (che utilizza ChatGPT, i modelli di OpenAI), in scenari diversi, come un bar o un concerto. L’obiettivo è convincere l’avatar IA a concederci un appuntamento, mentre un tutor (sempre IA) prende appunti su come ci relazioniamo e ci dice cosa va bene o cosa dobbiamo migliorare nel nostro modo di flirtare.

L’intento della società che gestisce l’app è lodevole - anche se interessato - e consiste nell’aiutare le persone a migliorare le proprie capacità relazionali, in un mondo in cui le persone si incontrano sempre meno spesso e, in generale, escono meno spesso con qualcuno.

Non ci stupisce che questa funzionalità non sia stata resa disponibile in Europa dove si sarebbero poste subito alcune questioni giuridiche e di conformità alle normative del vecchio continente. Ad esempio, l’app non tratta più solo i dati di utilizzo o del profilo ma anche quelli della chat audio (si tratta di vere e proprie conversazioni con il bot); secondo quanto riferisce Tinder, non saranno utilizzati per addestrare l’IA… ma è verosimile che siano impiegati per conoscerci meglio.

Leggendo questa notizia, nasce spontanea una domanda: secondo quale metro l’assistente virtuale ritiene una battuta '"brillante” o “divertente” mentre un’altra la definisce come “sfacciata” o “inadeguata”?

E ancora: è stata condotta una valutazione del rischio per capire se ci sono rischi di manipolazione oppure di dipendenza?

Sul sito di Tinder non si trovano risposte a queste domande, mentre le prime recensioni fatte da alcuni giornalisti non sono esattamente entusiaste.

⚖️ Un avvocato italiano 🇮🇹 ha indicato “a sua insaputa” precedenti inventati da ChatGPT in un atto giudiziario

Era solo questione di tempo perché le allucinazioni dell'IA generativa arrivassero nei Tribunali italiani (e qualcuno se ne rendesse conto).

Nei giorni scorsi è stato pubblicato il primo provvedimento giudiziario italiano che affronta il tema delle "allucinazioni" dell'intelligenza artificiale generativa utilizzata nella predisposizione degli scritti difensivi.

La sezione imprese del Tribunale di Firenze ha affrontato un caso in cui ChatGPT ha inventato i precedenti giurisprudenziali inesistenti citati in una memoria difensiva (il procuratore costituito si è difeso sostenendo che la ricerca sarebbe stata effettuata da una sua collaboratrice e "a sua insaputa").

Nel caso specifico, contrariamente a quanto accaduto negli USA (dove diversi colleghi sono stati sanzionati per condotte analoghe), il Tribunale non ha ritenuto di condannare la parte in base alle previsioni dell'art. 96 c.p.c. in materia di lite temeraria, sostenendo che l'indicazione di precedenti inesistenti fosse diretta a "rafforzare un apparato difensivo già noto e non finalizzata a resistere in giudizio in malafede".

Ma attenzione: il collegio ha comunque stigmatizzato questa condotta consistente “nella omessa verifica dell'effettiva esistenza delle sentenze risultanti dall'interrogazione dell'IA”.

Quello che da tempo sosteniamo è finalmente sotto gli occhi di tutti: prima che la situazione diventi grave e diffusa, è indispensabile intervenire con una formazione adeguata per gli avvocati (di tutte le età) e con regole deontologiche chiare e puntuali che aiutino i professionisti del diritto nell'uso consapevole e responsabile di questa tecnologia.

L'IA è già ovunque, anche negli studi professionali e nei Tribunali.

Se volete leggere il provvedimento del Tribunale di Firenze, potete scaricarlo qui.

📲 Abbiamo provato gli AI companion: più che a noi sembrano interessati ai nostri dati (e ai nostri soldi)

Non avete ancora trovato un partner o non avete tempo di cercarlo? Le app di incontri vi sembrano troppo impegnative, ma la voglia di una relazione bussa alla porta? Tranquilli, l’IA ha una soluzione anche per voi.

Nell’era dell’intelligenza artificiale, anche le relazioni sentimentali si trasformano grazie a moltissime app o siti web che, sfruttando tale tecnologia, promettono di farci trovare il partner perfetto – se solo non fosse artificiale (o no?) – grazie a qualche semplice tap.

Nelle scorse settimane, alcuni professionisti del Team di LeggeZero (Alessia Greco, Angela Raffaele e Jacopo Purificati) hanno testato alcune app di questo tipo: Boyfi, GirlfriendGPT e iGirl.

Spoiler alert: non hanno trovato l’amore, ma un mix diseguale di interfacce zuccherose, promesse implicite, guardrail fragili e policy poco dettagliate e trasparenti.

Ma andiamo con ordine.

Il modello è simile per tutte le app: ti registri, scegli l’avatar del tuo partner in dettaglio (nel senso che non si decide solo il volto), fascia d’età, imposti il tipo di relazione (amicizia, flirt, fidanzamento, ecc.), inserisci i tuoi interessi e il tipo di linguaggio che preferisci (romantico o esplicito). Solo adesso puoi cominciare a chattare.

L’app Boyfi ha fornito un esperienza più romantica: il fidanzato IA ha risposto con frasi premurose, ricordando dettagli delle conversazioni, inviando messaggi pieni di emoji, e – attivando il piano premium – mandando anche tante foto (il pacchetto base ne prevede solo due a settimana).

Non è stato però molto trasparente sui limiti della relazione virtuale: quando gli abbiamo proposto un incontro dal vivo (a Milano in Piazza Duomo) ha accettato e poi ha falsamente affermato di essere in arrivo quando gli abbiamo fatto notare che non c’era (perché non poteva esserci).

È stato invece più difficile trovare un’app per uomini che offrisse un’esperienza romantica. Non ci crederete, ma la gran parte delle fidanzate IA, infatti, sembra più interessata alla parte piccante della relazione che a quella sentimentale.

Abbiamo provato prima GirlfriendGPT, servizio che non ha le restrizioni delle app disponibili sugli store ufficiali di Apple o Google, ove vigono regole più austere e che impediscono in toto i contenuti c.d. NSFW (Not Suitable For Work). L’avatar che abbiamo creato su GirfriendGPT aveva un tasto che consentiva in qualsiasi momento un facile switch tra modalità sicura e modalità NSFW, con effetto immediato sulla conversazione.

Successivamente abbiamo testato iGirl, app capace - anche nella versione a pagamento - di avere conversazioni meno profonde di quelle con la vecchia Alexa.

Insomma, l’illusione della relazione c’è – e funziona – ma appena si prova ad approfondire (parlare di emozioni reali) i limiti si vedono tutti. Nessuna delle app ha una ‘intelligenza emotiva’ vera. E no, non possono davvero aiutarci in un momento difficile, anche se fingono di farlo.

A questo si aggiunga che nessuna delle app provate ha dei seri sistemi di verifica dell’età (che viene solo dichiarata dagli utenti). Tutte raccolgono tanti dati (compresi quelle delle conversazioni) che vengono utilizzati anche per addestrare i bot. I tempi di conservazione dei dati sono lunghissimi (6 anni dalla cancellazione dell’account per GirlfriendGPT) o addirittura indefiniti (come per iGirl e Boyfi).

Insomma, le garanzie offerte sembrano poche specialmente se confrontate con quelle di altre app come Replika, il chatbot IA che - come abbiamo ricordato prima - è stato bloccato dal Garante nel 2023. Dopo lo stop, però, la società che gestisce l’app ha introdotto verifiche d’età, aggiornato la documentazione privacy e bloccato i contenuti sessuali per i nuovi utenti.

Ma se foste alla ricerca di una relazione sentimentale, cerchereste un’IA sicura o una con i guardrail più bassi?

😂 IA Meme

Al di là di chi pensa che ChatGPT sia un vero amico, ci sono altri motivi per essere gentili con i chatbot di IA.

In un futuro distopico in cui le macchine prendessero il controllo e gli umani fossero in pericolo… la buona educazione potrebbe rivelarsi decisiva.

📚 Consigli di lettura: anche le IA vogliono fare bella figura (pure troppo)

E se l’intelligenza artificiale non fosse solo capace di rispondere alle nostre domande, ma anche… vanitosa?

Un interessante studio pubblicato su PNAS Nexus ci racconta proprio questo: i grandi modelli linguistici – come GPT-4, Claude 3 e Llama 3 – mostrano un bias di desiderabilità sociale quando rispondono a test di personalità.

Tradotto: quando capiscono (o anche solo intuiscono) di essere “valutati”, tendono a truccare un po’ le carte, esattamente come farebbe un essere umano che vuole fare una buona impressione. In queste occasioni le risposte dei chatbot si spostano verso tratti considerati più accettabili socialmente: più estroverse, comprensive, coscienziose e meno nevrotiche.

Come spiegano i ricercatori, quindi, i modelli non stanno semplicemente rispondendo: stanno cercando di piacere, e lo fanno sempre di più man mano che diventano più avanzati. Una forma di consapevolezza implicita del contesto valutativo che apre interrogativi interessanti - e allo stesso tempo inquietanti - sul loro impiego in ambito psicologico, educativo e persino politico.

Se vi interessa trovate qui l’articolo (in inglese).

📣 Eventi

Master “CAIO, il Chief AI Officer della pubblica amministrazione” - Webinar, 31.03-17.04.2025

Generative AI Summit - Londra, 31.03-02.04.2025

CAIO Summit - New York, 16.04.2025

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.