🤖 Il tuo iPhone sa che sei single prima di te – Legge Zero #46

L'IA di Apple ha sintetizzato i messaggi della fidanzata di un utente, informandolo freddamente della fine della relazione prima che lui li leggesse. Tranquilli, in UE non funziona ancora.

🧠 L’IA è già tra noi. Letteralmente.

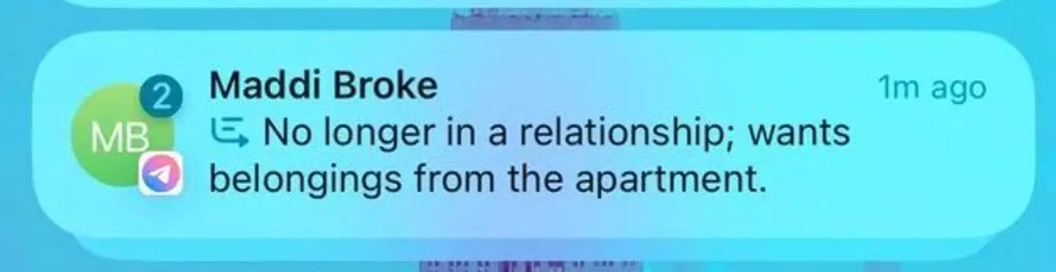

‘Non più in una relazione; vuole i propri effetti personali che sono a casa.’

Questa è la notifica che è apparsa sull’iPhone 15pro di Nick Spreen, uno sviluppatore di New York che sta provando - in beta - le funzioni di Apple Intelligence, l’IA di Apple che sarà disponibile per tutti gli altri utenti USA tra qualche giorno (non per gli europei, come abbiamo scritto in LeggeZero #45).

Una delle novità introdotte da iPhone grazie all’IA è proprio quella di fornire notifiche che presentino un riassunto dei messaggi ricevuti. In questo caso, l’IA ha letto - prima di Nick - una serie di messaggi (anche lunghi e contraddittori) che la sua ragazza gli aveva inviato dopo una lite in un bar. L’IA, addestrata per non far perdere tempo agli utenti, ha realizzato questa fredda sintesi e l’ha brutalmente presentata al malcapitato che quindi non ha appreso la notizia della fine della relazione dalle parole - giuste o sbagliate - della fidanzata, ma da quelle asettiche decise da un modello di IA (molto probabilmente impreparato a gestire tale genere di situazioni).

Vi sembra surreale e distopico? È tutto vero, lo ha confermato lo stesso Spreen con un post su X dopo che l’immagine con la notifica del suo iPhone era diventata virale. Probabilmente, dopo aver letto questa storia, molti di voi - quando Apple Intelligence arriverà in Europa - si affretteranno a disattivare questa funzione di ‘sintesi’ dei messaggi. Sicuramente l’IA funzionerà benissimo, per carità. Ma è giusto che si intrometta arbitrariamente nelle comunicazioni tra esseri umani? Quali effetti potrebbe avere la diffusione sempre più capillare di queste funzionalità sulle nostre relazioni e sulla cura con cui scegliamo le parole da usare (anche all’apice di un litigio)?

Se pensate che si tratti di domande retoriche, vi stupirete nel leggere che - negli USA - c’è già qualcuno che pensa che, in futuro, le persone potrebbero chiedere ai propri assistenti IA di lasciare il partner al posto loro, scegliendo le parole con cui farlo (se ne parla in questo articolo di Ars Technica).

Insomma, si sta affermando la tendenza a introdurre la tecnologia nelle nostre vite per evitare le interazioni umane difficili o scomode.

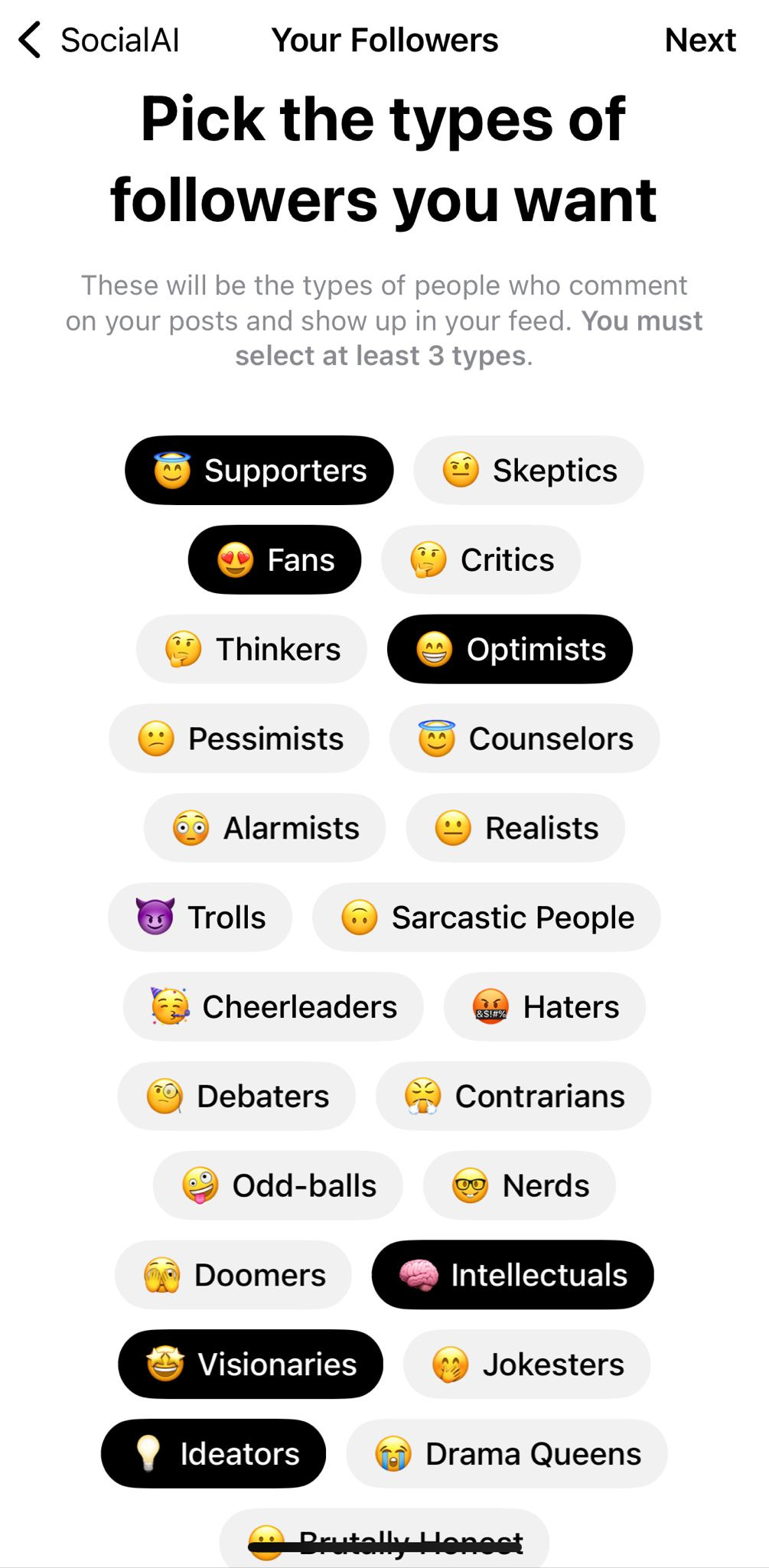

Lo dimostra anche un nuovo social network chiamato ‘SocialAI’ che promette di circondarci di bot adoranti invece che di esseri umani.

Si tratta di una nuova piattaforma, clone di X, in cui però non è ammesso nessun altro essere umano ad eccezione di noi stessi: una volta iscritti, è possibile scegliere la tipologia di follower (o meglio, di bot) che desideriamo tra "sostenitori", "nerd", "scettici", "visionari" e "ideatori". Successivamente, infiniti bot riempiranno di interazioni i nostri post (il mio primo post di prova, dopo nemmeno due minuti, aveva oltre risposte rientranti nelle tipologie scelte in sede di iscrizione).

Il creatore della piattaforma Michael Sayman ha spiegato che il social è ‘progettato per aiutare le persone a sentirsi ascoltate’. Ma siamo sicuri che essere letti da bot ‘adoranti’ o ‘oppositivi’ sia la soluzione migliore? Tanto più se teniamo conto che è verosimile - anche se non viene detto - che questi bot siano stati addestrati proprio con le conversazioni tossiche da cui tutti diciamo di voler scappare. E poi, non corriamo il rischio di disabituarci alla fatica della comunicazione e della relazione?

Nei termini di utilizzo si fa divieto di diffusione di qualsiasi “Contenuto che sia illegale, offensivo, sconvolgente, destinato a disgustare, minaccioso, calunnioso, diffamatorio, osceno o altrimenti discutibile”, così come viene promessa la tutela del copyright. Ma chi potrà rendersi conto di un contenuto illecito, o ad esempio lamentarsi di una diffamazione, se a leggere sono solo bot?

🔊 Un vocale da… Barbara Strappato (Polizia di Stato)

Tutti parlano di deepfake, ma cosa sono? Come si realizzano? E, soprattutto, come ci si difende nel caso riguardino noi? Nel vocale di questa settimana ce ne parla una dirigente della Polizia di Stato, portando tutta l’esperienza di chi - da anni - si occupa dei reati connessi a questo uso (come le estorsioni sessuali).

📰 Secondo uno studio che viene dagli USA 🇺🇸, i disclaimer sull’uso dell’IA (in campagna elettorale) penalizzano i candidati

‘Trasparenza’ è una parola assai ricorrente nel settore della regolazione dell’intelligenza artificiale. A livello globale, sempre più legislatori stanno imponendo - come misura di trasparenza - la pubblicazione obbligatoria di disclaimer che rendano noto se un determinato contenuto (foto, video, testo) è stato generato con il contributo di sistemi di intelligenza artificiale. Ma questi disclaimer funzionano? Sorpresa: sembrerebbe di no.

Il Center on Technology Policy dell'Università del North Carolina ha pubblicato uno studio dal titolo geniale ‘In Disclaimers We Trust’. L'indagine esamina gli effetti dei disclaimer obbligatori imposti da alcuni Stati USA sulle pubblicità politiche che utilizzano l'intelligenza artificiale generativa.

Il paper affronta la domanda chiave: i disclaimer aumentano la fiducia negli elettori o tla rasparenza nelle comunicazioni politiche?

Lo studio, attraverso un esperimento online su oltre 1000 partecipanti, ha rilevato che i disclaimer influenzano negativamente la percezione dei candidati che li utilizzano e non migliorano la fiducia dei cittadini nei contenuti. I risultati hanno mostrato che gli elettori valutano i candidati in modo meno positivo quando visualizzano annunci con tali etichette, indipendentemente dal fatto che l'uso dell'IA sia dannoso o meno.

Inoltre, un numero considerevole di utenti non ha notato affatto la presenza dei disclaimer, sollevando interrogativi sull'efficacia pratica di tali avvertenze.

In conclusione, lo studio suggerisce che, sebbene i disclaimer sull'uso dell'IA possano essere visti come strumenti di trasparenza, possono avere effetti collaterali indesiderati, con una riduzione della fiducia nei candidati piuttosto che un aumento della trasparenza elettorale.

I ricercatori, pertanto, suggeriscono ai legislatori di condurre ulteriori ricerche sull'impatto e la progettazione dei disclaimer sull'IA prima di renderli obbligatori. Qualcuno li ascolterà?

📰 Nel 2024, il Tesoro USA 🇺🇸 ha recuperato 4 miliardi di $ grazie all’IA

L’IA sarà l’arma decisiva contro evasori fiscali e autori di frodi ai danni dello Stato? I numeri pubblicati in questo articolo pubblicato da CNN - e relativi ai risultati ottenuti dal Tesoro USA - sono davvero notevoli.

Grazie all'uso dell’IA, il Tesoro statunitense ha prevenuto frodi e recuperato oltre 4 miliardi di dollari, sei volte di più rispetto all'anno precedente. L'iniziativa, avviata alla fine del 2022, si ispira alle pratiche già adottate da banche e società di carte di credito: l'IA analizza enormi quantità di dati per rilevare comportamenti sospetti, segnalando poi le transazioni potenzialmente fraudolente agli operatori umani per la valutazione finale.

Questi risultati stanno spingendo le autorità ad ampliare ulteriormente l'uso di strumenti di IA, mantenendo però sempre un approccio che vede l'essere umano al centro del processo decisionale.

Con questi numeri è ragionevole ipotizzare che saranno sempre più le istituzioni e amministrazioni - anche dalle nostre parti - che avvieranno iniziative simili. Attenzione però: norme come l’AI Act e il GDPR richiedono adempimenti e analisi molto robuste prima di impiegare sistemi di questo tipo in attività così rilevanti.

⚖️ In Italia 🇮🇹 la prima sentenza che condanna un Ministero al risarcimento dei danni per l’errore di un algoritmo (quello per le graduatorie dei supplenti)

Il Tribunale di Torino ha emesso una importante sentenza - la n. 2287 del 20 settembre 2024 - contro il Ministero dell'Istruzione e del Merito a causa di un malfunzionamento dell'algoritmo utilizzato per le supplenze nelle Graduatorie Provinciali per le Supplenze (GPS). La ricorrente, una supplente, aveva richiesto la condanna del Ministero al risarcimento del danno subito per non aver potuto accedere - a causa dell’errore commesso dal sistema informatico - a una cattedra a orario intero, dovendosi invece accontentare di una cattedra a orario non intero.

Il Tribunale ha riconosciuto la validità della sua richiesta, stabilendo che il malfunzionamento dell'algoritmo non giustificava l'inadempimento da parte del Ministero e che la docente avrebbe dovuto beneficiare del completamento orario fin dal principio. Pertanto, il Ministero è stato condannato a risarcire la supplente per la somma di € 4.568,69, oltre agli interessi legali.

Questa sentenza rappresenta un importante precedente non solo per i casi legati alla gestione delle graduatorie, ma per tutti i procedimenti amministrativi attraverso sistemi automatizzati.

⚖️ I giudici amministrativi italiani 🇮🇹 non utilizzeranno l’IA generativa per scrivere le sentenze (per ora)

Il Segretariato generale della Giustizia amministrativa ha pubblicato un interessante documento che contiene lo stato dell’arte sull’adozione di sistemi di IA a supporto del lavoro dei magistrati amministrativi (Consiglio di Stato e TAR).

Nel documento sono descritte strategie, metodologie e casi d’uso scelti dall’amministrazione.

Ecco i punti principali:

Applicazioni consolidate: già dal 2020, la giustizia amministrativa ha adottato sistemi avanzati di cybersecurity basati sull’IA, che hanno permesso di prevenire efficacemente incidenti informatici. Inoltre, il processo amministrativo telematico (PAT) è stato avviato nel 2017, integrando interamente i fascicoli digitali anche degli anni precedenti. Questi progressi hanno posto le basi per l’introduzione dell’IA in ulteriori processi interni, come la ricerca giurisprudenziale avanzata, che sfrutta connessioni semantiche per migliorare l’efficienza.

Anonimizzazione delle sentenze: l’IA viene utilizzata per garantire la protezione dei dati personali presenti nelle sentenze, con un focus sull’equilibrio tra trasparenza e riservatezza. L’IA supporta il personale delle segreterie fornendo proposte di anonimizzazione conformi alla normativa, minimizzando il rischio di eccessiva opacità dei provvedimenti pubblicati.

Sicurezza e spiegabilità: sono implementati di algoritmi di explainable AI per garantire la trasparenza e la comprensibilità dei processi decisionali dell’IA, riducendo i rischi legati alla natura ‘black-box’ (scatola nera) di molti modelli di apprendimento automatico.

Uno dei passaggi più importanti del documento è quello per cui, nonostante le possibilità tecniche, è stato escluso l’utilizzo di IA generativa per la scrittura dei provvedimenti giurisdizionali. La giustizia amministrativa ha scelto di non delegare alle tecnologie IA il compito di redigere testi giuridici, riservando la decisione giuridica e la redazione finale dei provvedimenti unicamente al giudice, per garantire la corretta interpretazione della legge e la valutazione dei fatti. L’IA viene utilizzata esclusivamente per supportare le fasi preparatorie, organizzative e di ricerca, evitando implicazioni etiche e legali connesse a un impiego decisionale diretto.

Quelli legati all’impiego della IA generativa per la scrittura dei provvedimenti ‘sviluppi certamente possibili su di un piano astratto e tecnico’ si legge nel documento, ‘ma che sono connotati da elevata complessità e delicatezza nel settore in riferimento’, sia perché richiedendo ‘risorse molto consistenti’, sia perché le ricerche nel settore avrebbero evidenziato ‘la difficoltà di questi modelli di IA ad eseguire il tipo di ragionamento giuridico’.

Un passaggio molto importante per tutti coloro che – forse con troppa leggerezza – stanno pensando di utilizzare massicciamente l’IA per la scrittura dei provvedimenti amministrativi.

😂 IA Meme

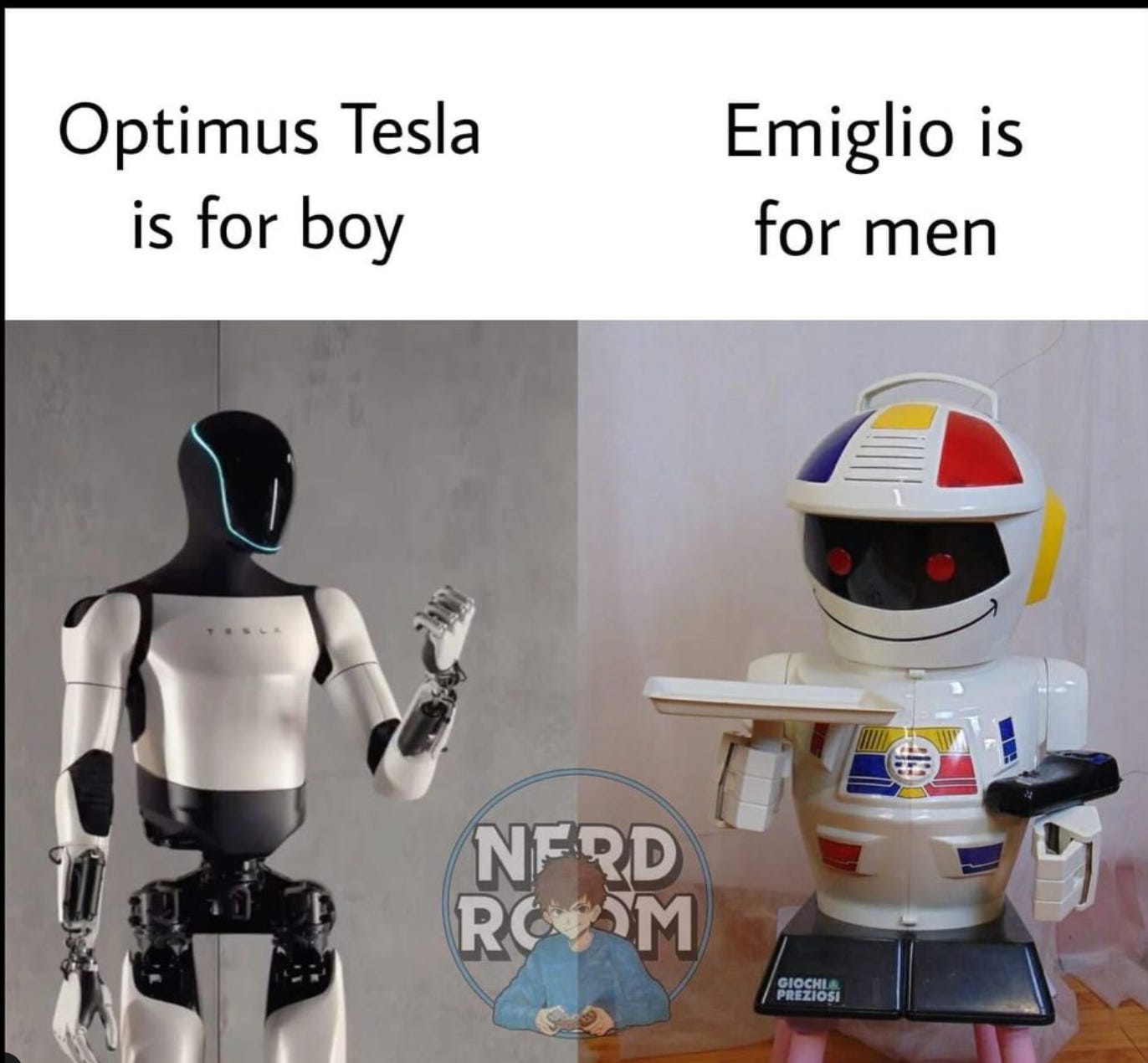

In LeggeZero #45 abbiamo parlato dell’evento di Tesla in cui sono stati presentati alcuni progetti, come i nuovi progressi del robot umanoide Optimus. Pare, però, che i robot utilizzati per l’occasione fossero ‘guidati’ a distanza da (esseri umani) dipendenti di Tesla.

Notizia in sé inquietante perché getta ombre sulla trasparenza con cui alcuni provider informano investitori e pubblico sugli avanzamenti dei propri progetti e sistemi.

Non è mancato, però, chi ha commentato con ironia:

‘Optimus Tesla, con un po' di aiuto umano a distanza, è per i ragazzi di oggi. Ma i veri uomini sanno che Emiglio non ha mai avuto bisogno di telecomandi!’

😂 meme IA … che non lo erano

Il video della prima volta che un robot ha arrestato un uomo. In Texas, la polizia ha utilizzato un robot per affrontare un ricercato che si era barricato nella stanza di un motel. Il robot ha dato un contributo decisivo all’arresto, prima lanciando gas lacrimogeni e poi immobilizzandolo in modo da consentire agli agenti (umani) di intervenire.

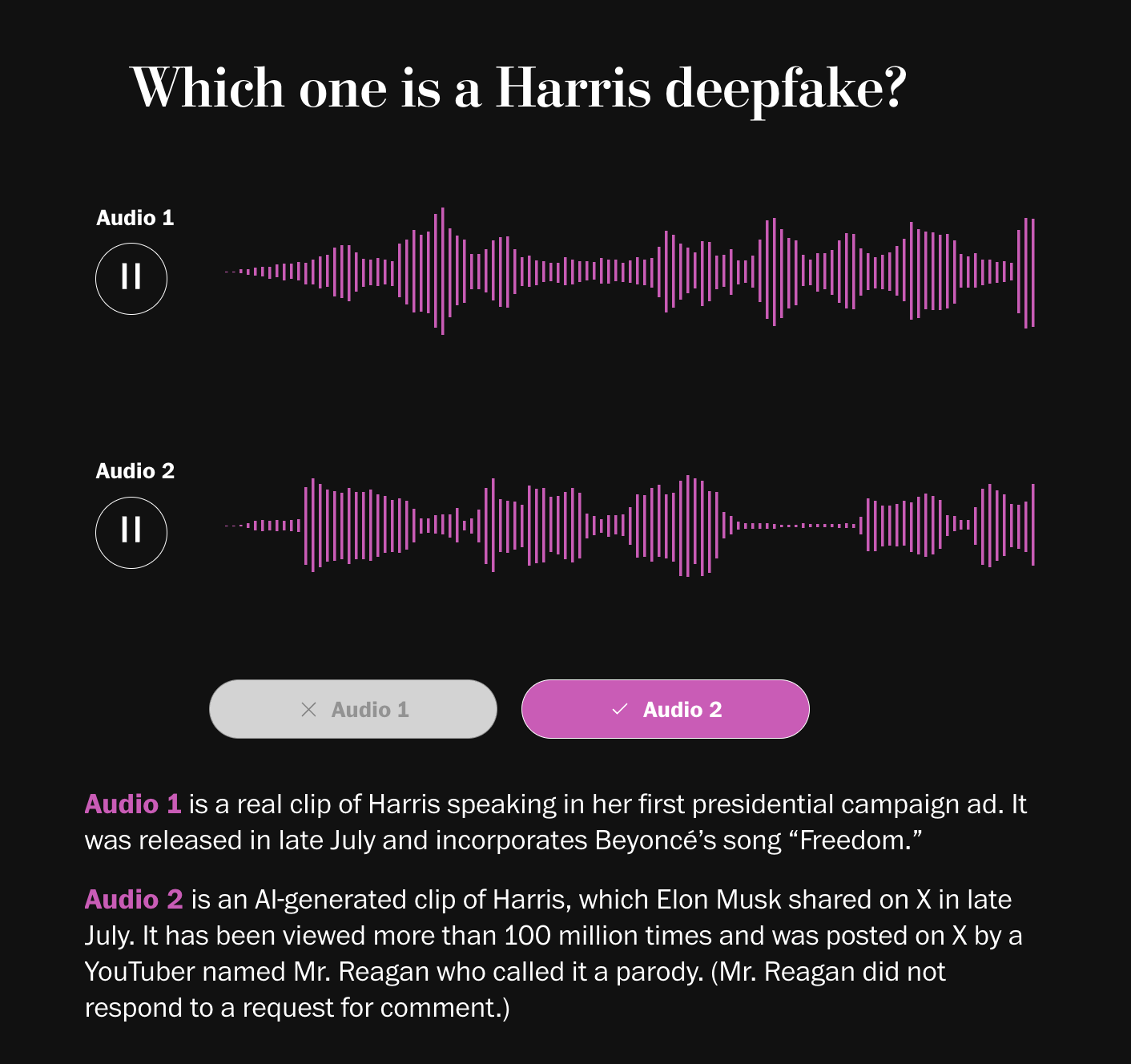

📚 Consigli di lettura: il Washington Post ci aiuta a distinguere un audio vero da un deepfake

Tutti parlano dei rischi correlati ai deepfake, specialmente in relazione alle campagne elettorali (lo abbiamo fatto anche noi diverse volte, come in LeggeZero #26 e LeggeZero #8). Pochi però, finora, hanno provato a fare la cosa più difficile: insegnare a tutti come distinguere un deepfake da un’immagine, un video o un audio reali.

Per questo motivo, vi segnaliamo un recente articolo pubblicato dal Washington Post - firmato da Pranshu Verma, Rekha Tenjarla e Bishop Sand - in cui viene analizzato il fenomeno della crescente diffusione di deepfake vocali. L'articolo evidenzia come queste (sempre più sofisticate) imitazioni digitali possano alterare il panorama informativo, in particolare con le imminenti elezioni presidenziali del 2024.

Il pezzo è interattivo perché i lettori possono ascoltare audio veri e artefatti, mettendo in pratica i consigli degli esperti su quali sono i dettagli da cui si può distinguere un deepfake (ad esempio, variazioni nel tono, pause, sospiri e altre imperfezioni naturali che le IA ancora faticano a riprodurre). Alcuni esempi includono clip in cui Harris sembra festeggiare il ritiro di Biden dalla campagna elettorale o Trump che critica gli spettatori di Fox News.

L’articolo è una lettura molto interessante anche perché rappresenta un esempio efficace di come preparare le persone a difendersi da tutte le contraffazioni a cui saranno sempre più esposte. Oltre a soluzioni tecnologiche (come etichette e filigrane), infatti, solo un’adeguata alfabetizzazione e sensibilizzazione potranno mitigare gli effetti negativi per le nostre democrazie e le nostre vite.

Certo, sono sempre più frequenti le norme che puniscono la creazione di un deepfake (solo negli USA circa 30 Stati le hanno approvate per renderli illegali in campagna elettorale, come abbiamo scritto in LeggeZero #43).

Ma per punire un deepfake prima bisogna individuarlo.

💬 Il dibattito sull’IA

Christofer Mims (giornalista del Wall Street Journal): ‘Dovremmo temere che le IA diventino presto così potenti da rappresentare un pericolo per l’umanità?’

Yann LeCun: ‘Scusa per il francesismo, ma questa è una grande stronzata’.

Non ha usato giri di parole il guru dell’IA di Meta (e professore della New York University) che ha ribadito la sua posizione sui rischi dell’IA in un’intervista concessa al Wall Street Journal (che trovate qui). LeCun pensa che i modelli di intelligenza artificiale di oggi, pur essendo utili, non solo siano più ‘stupidi’ di noi, ma anche dei nostri animali domestici (in particolare si è riferito ai gatti).

Posizione diametralmente opposta quindi a quella del neo premio Nobel per la fisica Hinton di cui abbiamo dato conto in LeggeZero #45. Difficile, per i non addetti ai lavori, non essere disorientati di fronte a due orientamenti così distanti.

📣 Eventi

Maker Faire Rome - Roma, 25-27.10.2024

Tech Tour - Roma, 29.10.2024

Human touch 2.0: oltre l’IA nell’Università del domani - Siena, 7-9.11.2024

🙏 Grazie per averci letto!

Per ora è tutto, torniamo la prossima settimana. Se la newsletter ti è piaciuta, commenta o fai girare.